Googleが大規模言語モデル「PaLM 2」のテクニカルレポートを公開するも肝心な部分の情報は記載されず

GoogleはGoogle I/O 2023の中でGPT-4の競合となる大規模言語モデル「PaLM 2」を発表しました。同時にPaLM 2のテクニカルレポートも公開されましたが、トレーニングデータの収集元やトレーニングにおけるハードウェアの設定など重要な情報については公開されませんでした。

PaLM 2 Technical Report(PDF)

https://ai.google/static/documents/palm2techreport.pdf

PaLM 2でどんなことが可能になるのかについては下記の記事で詳しく記載してあります。

Googleが大規模言語モデル「PaLM 2」を発表、すでに25のGoogleサービスに導入済み - GIGAZINE

PaLM 2のテクニカルレポートは全部で92ページに及んでいますが、その中でトレーニングに用いたデータについて説明しているのは半ページのみとなっています。その半ページによると、PaLM 2のトレーニングデータには「ウェブのドキュメント」「本」「コード」「数式」「会話文」が含まれており、PaLMをトレーニングした時と比較してより大規模になったと同時に英語以外の言語の割合が増加しているとのことですが、具体的にどうやって収集したどんなデータを利用したのかについては記載されていません。

データを秘匿しているのはGoogleだけではありません。PaLM 2の競合となるGPT-4のテクニカルレポート(PDF)においても、GPT-4を開発したOpenAIは「GPT-4のような大規模モデルの競争環境と安全性の両方を考慮し、このレポートにはモデルサイズを含むアーキテクチャ、ハードウェア、トレーニング計算、データセット構築、トレーニング方法、または同様のものに関する追加の詳細情報を記載しません」と記しており、大規模言語モデルの開発において情報が秘匿される傾向が続いています。

こうした情報の秘匿について、Hacker Newsでは「モデルの詳細な情報が企業の存続を左右するほど重要になり、情報をオープンにする時代が終わってしまった」とコメントされています。

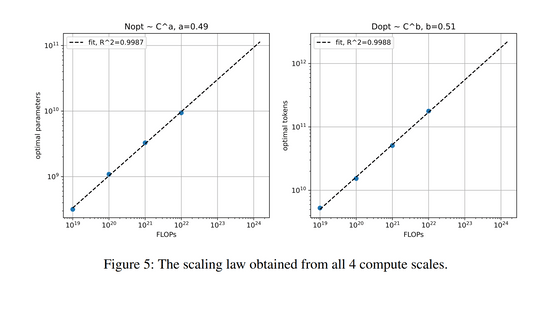

とはいえすべての情報が秘匿されているわけではなく、PaLM 2のテクニカルレポートにおいては「計算量とモデルのサイズとトレーニングに利用するデータ量の最適な関係」「プライバシー保護への取り組み」「人種差別など有害な返答の出現量についての調査」などが解説されています。下図の横軸はともに計算量を表しており、左のグラフの縦軸は最適なパラメーター数(=モデルのサイズ)、右のグラフの縦軸は最適なトークン数(=トレーニングに利用するデータの量)を表しています。今回のテクニカルレポートでは、計算量の増加に伴ってモデルのサイズとトレーニングデータ量を同じ割合で増加させるのが一番効率良くトレーニングを行えると述べられています。

プライバシー保護の観点では、PaLM 2では「トレーニングした文言と全く同じ言葉が生成される」という逐語記憶(verbatim memorization)の発生量がPaLMに比べて減少したとのこと。トレーニングデータに含まれる割合が小さい言語でも逐語記憶が発生しにくくなったと記載されています。

しかしPaLM 2のテクニカルレポートは、さまざまな言語にわたる有害な反応に関して、まだやるべきことが残っていることも明らかにしています。たとえば、特に有害なプロンプトが与えられた場合にPaLM 2は30%以上の確率で有害な反応を生成したり、英語、ドイツ語、ポルトガル語などの特定の言語において、人種的アイデンティティや宗教などのプロンプトが原因でPaLM 2は17%以上の確率で有害な反応を示すという結果になったりしました。

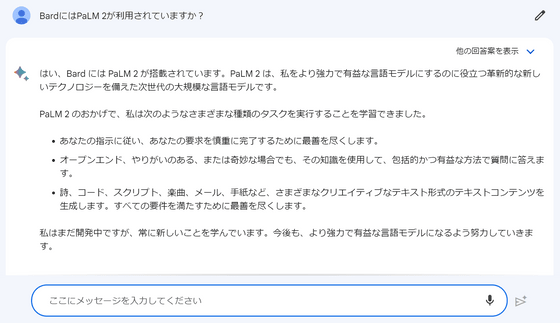

なお、PaLM 2とのやりとりを実際に試してみたい場合はGoogle製のAIチャットサービス「Bard」を利用するのが簡単です。

・関連記事

オープンソースの大規模言語モデル開発プロジェクト「RedPajama」が最初のモデル「RedPajama-INCITE」をリリース、無料で商用利用も可能 - GIGAZINE

GPT-4やPaLMなどの大規模言語モデルは規模が大きくなると突然予想外の能力を開花させることがある - GIGAZINE

MicrosoftがBingのチャットAIを全ユーザーに開放、「質問に画像やグラフで回答」などAI機能の強化や今後追加予定の新機能も発表 - GIGAZINE

オープンソースで商用利用可能な言語モデル「MPT-7B」リリース、GPT-4の2倍の長さの文章を受け付ける - GIGAZINE

ChatGPTなどに使われる大規模言語モデルを従来のシステムよりも15倍高速・低コストで学習できる「DeepSpeed-Chat」をMicrosoftが公開 - GIGAZINE

ChatGPTやBardなど複数のチャットAIへ同時に質問して結果をずらっと比較できる「ChatALL」を使ってみたよレビュー - GIGAZINE

・関連コンテンツ