NVIDIA製グラボやAppleチップのAI推論処理能力をまとめた一覧表、どのグラボやMacを買えばいいのかの参考になる

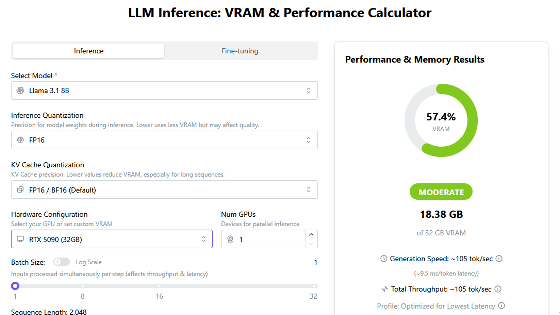

一昔前まではグラフィックボードのメイン用途はゲームなどの3Dグラフィック処理でしたが、近年では「ローカルでAIで動作させる」ということを目的にグラフィックボードを選択する事例も増えています。大量のNVIDIA製グラフィックボードやApple製チップで大規模言語モデル「LLaMA 3」の推論処理を実行した際の処理性能をまとめたウェブページ「GPU-Benchmarks-on-LLM-Inference」を見つけたので、内容をまとめてみました。

GitHub - XiongjieDai/GPU-Benchmarks-on-LLM-Inference: Multiple NVIDIA GPUs or Apple Silicon for Large Language Model Inference?

https://github.com/XiongjieDai/GPU-Benchmarks-on-LLM-Inference

GPU-Benchmarks-on-LLM-InferenceはAI研究者のXiongjie Dai氏が作成した性能比較ページで、各種グラフィックボードやApple製チップでLLaMA 3の推論処理を実行した際の秒間処理トークン数がまとまっています。なお、LLaMA 3の実行には「llama.cpp」を使用しており、「パラメーター数が8Bのモデル」「パラメーター数が8Bのモデルを量子化したもの」「パラメーター数が70Bのモデル」「パラメーター数が70Bのモデルを量子化したもの」で性能を検証しています。

性能比較表に含まれるグラフィックボードのうち、比較的入手が容易なゲーム用途のグラフィックボードの検証結果を抜き出したものが以下。最も高い性能を示したのは「RTX 4090 24GB」でした。また、「RTX 3090 24GB」「RTX 4080 16GB」「RTX 4090 24GB」の3モデルは量子化を施していないLLaMA 3 8Bを実行できています。一方で、LLaMA 3 70Bは量子化済みのモデルであっても実行不可能でした。

| GPU | 8B Q4_K_M | 8B F16 | 70B Q4_K_M | 70B F16 |

|---|---|---|---|---|

| RTX 3070 8GB | 70.94 | メモリ不足 | メモリ不足 | メモリ不足 |

| RTX 3080 10GB | 106.40 | メモリ不足 | メモリ不足 | メモリ不足 |

| RTX 3080 Ti 12GB | 106.71 | メモリ不足 | メモリ不足 | メモリ不足 |

| RTX 3090 24GB | 111.74 | 46.51 | メモリ不足 | メモリ不足 |

| RTX 4070 Ti 12GB | 82.21 | メモリ不足 | メモリ不足 | メモリ不足 |

| RTX 4080 16GB | 106.22 | 40.29 | メモリ不足 | メモリ不足 |

| RTX 4090 24GB | 127.74 | 54.34 | メモリ不足 | メモリ不足 |

グラフィックボードを複数個搭載したマシンの処理性能はこんな感じ。グラフィックボードを増やすことでメモリ不足は解消できるものの、秒間処理トークン数に大きな違いは出ないことが分かります。

| GPU | 8B Q4_K_M | 8B F16 | 70B Q4_K_M | 70B F16 |

|---|---|---|---|---|

| RTX 3090 24GB 2個 | 108.07 | 47.15 | 16.29 | メモリ不足 |

| RTX 3090 24GB 4個 | 104.94 | 46.40 | 16.89 | メモリ不足 |

| RTX 3090 24GB 6個 | 101.07 | 45.55 | 16.93 | 5.82 |

| RTX 4090 24GB 2個 | 122.56 | 53.27 | 19.06 | メモリ不足 |

| RTX 4090 24GB 4個 | 117.61 | 52.69 | 18.83 | メモリ不足 |

| RTX 4090 24GB 8個 | 116.13 | 52.12 | 18.76 | 6.45 |

計算処理向けグラフィックボードの処理性能は以下の通り。

| GPU | 8B Q4_K_M | 8B F16 | 70B Q4_K_M | 70B F16 |

|---|---|---|---|---|

| RTX 4000 Ada 20GB | 58.59 | 20.85 | メモリ不足 | メモリ不足 |

| RTX 4000 Ada 20GB 4個 | 56.14 | 20.58 | 7.33 | メモリ不足 |

| RTX 5000 Ada 32GB | 89.87 | 32.67 | メモリ不足 | メモリ不足 |

| RTX 5000 Ada 32GB 4個 | 82.73 | 31.94 | 11.45 | メモリ不足 |

| RTX A6000 48GB | 102.22 | 40.25 | 14.58 | メモリ不足 |

| RTX A6000 48GB 4個 | 93.73 | 38.87 | 14.32 | 4.74 |

| RTX 6000 Ada 48GB | 130.99 | 51.97 | 18.36 | メモリ不足 |

| RTX 6000 Ada 48GB 4個 | 118.99 | 50.25 | 17.96 | 6.06 |

そして、ハイパフォーマンスコンピューティングやAI処理向けのチップでLLaMA 3の各モデルを実行した際の推論処理性能が以下。

| GPU | 8B Q4_K_M | 8B F16 | 70B Q4_K_M | 70B F16 |

|---|---|---|---|---|

| A40 48GB | 88.95 | 33.95 | 12.08 | メモリ不足 |

| A40 48GB 4個 | 83.79 | 33.28 | 11.91 | 3.98 |

| L40S 48GB | 113.60 | 43.42 | 15.31 | メモリ不足 |

| L40S 48GB 4個 | 105.72 | 42.48 | 14.99 | 5.03 |

| A100 PCIe 80GB | 138.31 | 53.18 | 24.33 | メモリ不足 |

| A100 PCIe 80GB 4個 | 117.30 | 51.54 | 22.68 | 7.38 |

| A100 SXM 80GB | 133.38 | 53.18 | 24.33 | メモリ不足 |

| A100 SXM 80GB 4個 | 97.70 | 45.45 | 19.60 | 6.92 |

| H100 PCIe 80GB | 144.49 | 67.79 | 25.01 | メモリ不足 |

| H100 PCIe 80GB 4個 | 118.14 | 62.90 | 26.20 | 9.63 |

また、Apple製チップ搭載Macでの推論処理性能はこんな感じ。M2 UltraとM3 Maxの性能差をみるとLLMの処理におけるメモリ容量の重要性が分かります。

| GPU | 8B Q4_K_M | 8B F16 | 70B Q4_K_M | 70B F16 |

|---|---|---|---|---|

| M1 7‑Core GPU 8GB | 9.72 | メモリ不足 | メモリ不足 | メモリ不足 |

| M1 Max 32‑Core GPU 64GB | 34.49 | 18.43 | 4.09 | メモリ不足 |

| M2 Ultra 76-Core GPU 192GB | 76.28 | 36.25 | 12.13 | 4.71 |

| M3 Max 40‑Core GPU 64GB | 50.74 | 22.39 | 7.53 | メモリ不足 |

Dai氏は、性能比較結果をもとに「お金を節約するならNVIDIA製のゲーム用グラフィックボード、ビジネス用途ならプロ向けグラフィックボード、省電力性能や静音性能を求めるならMacを購入してください」と結論付けています。

・関連記事

画像生成AIをノートPCでどれくらいの速度で動かせるのか、「Razer Blade 16」のVRAM容量16GB「GeForce RTX 4090 Laptop」で実際に試してみたよレビュー - GIGAZINE

VRAM容量12GBの「GeForce RTX 4070 SUPER」は画像生成AIでどれだけの性能を発揮するのか?旧世代グラボと徹底比較してみたよレビュー - GIGAZINE

4K画質&レイトレーシング対応で120FPSをたたき出すNVIDIA DLSS3対応のGeForce RTX 4090搭載グラボ「TUF-RTX4090-24G-GAMING」でゲームしたり動画編集したりしてみた - GIGAZINE

M4/M4 Pro/M4 Max搭載MacBook Proが登場、ローカルで巨大AIを実行可能でバッテリーは24時間持続 - GIGAZINE

なぜ研究者はローカルPCでAIを実行する必要があるのか? - GIGAZINE

・関連コンテンツ

in ハードウェア, ソフトウェア, Posted by log1o_hf

You can read the machine translated English article A list of the AI inference processing ca….