なぜ研究者はローカルPCでAIを実行する必要があるのか?

高度な生成AIは動作に相応の機器を必要とするため、一般的なユーザーが高度な生成AIを使うためにはネットに接続して利用するしかありません。一方で、高度なAIをローカルで実行できるような試みが行われ、実際にローカルで動作する高度なAIもいくつか存在します。AIをローカルで動作させることの利点について、科学誌Natureが利用者の声をいくつか紹介しました。

Forget ChatGPT: why researchers now run small AIs on their laptops

https://www.nature.com/articles/d41586-024-02998-y

免疫系タンパク質の構造のデータベース「histo.fyi」を運営するクリス・ソープ氏はAIをノートPCで動作させています。ソープ氏は以前にChatGPTの有料版を試したそうですが、高価で出力が適切でないと感じたため、80億~700億のパラメータを持つLlamaをローカルで使用しているとのことです。

ソープ氏によれば、もうひとつの利点は「ローカルモデルは変更されないこと」だといいます。商業的に展開されているAIモデルは企業の意向によって動作が変わってしまい、ユーザーはプロンプトやテンプレートの変更を余儀なくされることがありますが、ローカルであればユーザーの意思で自由に使用できます。ソープ氏は「科学は再現性のあるものを求めるものです。自分が生成しているものの再現性をコントロールできないというのは心配の種になります」と語り、AIをローカルで動かすことの有用性について意見を述べました。

記事作成時点では数千億のパラメーターを持つAIモデルもありますが、パラメーターは多ければ多いほど処理の複雑さが増します。企業によっては、こうした複雑なモデルを公開する一方で、一般消費者向けPCで実行できる縮小版や「重み」を公開したオープンウェイト版を公開しているところもあります。

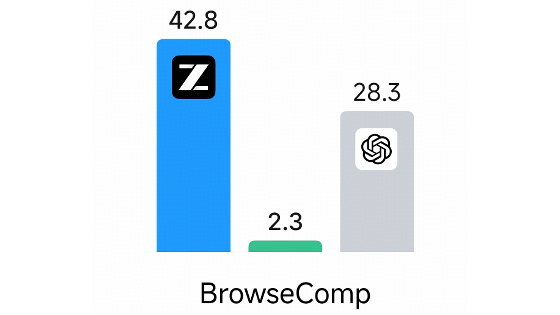

例えばMicrosoftは小型言語モデルの「Phi-1」や「Phi-2」を2023年にリリースしていて、2024年には「Phi-3」を矢継ぎ早にリリースしています。Phi-3は38億から140億のアクティブパラメータを持ち、いくつかのベンチマークでは最小モデルでさえ200億のパラメータを持つとされる「GPT-3.5 Turbo」を上回っていることが示されています。研究者はこれらのモデルをベースに独自のアプリケーションを作ることができます。

ニューハンプシャー州の生物医学科学者であるKal'tsit氏はローカルで動作するアプリケーションを作った開発者の一人です。Kal'tsit氏はアリババが作成した「Qwen」モデルを微調整し、原稿を校正したり、コードのプロトタイプを作ったりするモデルを作成して公開。Kal'tsit氏は、「ローカルモデルは用途に合わせて微調整できることに加え、もう一つの利点はプライバシーです。個人を特定できるデータを商用サービスに送信することはデータ保護規制に抵触する可能性があり、もし監査が行われたら厄介なことになるでしょう」と語りました。

他にも、医療報告書に基づいて診断を手助けしたり、患者の問診を書き起こしたり要約したりするAIを使用している医師は、プライバシーを重視するためにローカルモデルを使用していると語ります。

Firefoxを開発するテック企業・MozillaでオープンソースのAIを統括するスティーブン・フッド氏は、「オンラインとローカル、どちらのアプローチを選ぶにせよ、ローカルモデルはほとんどの用途ですぐに十分な性能を発揮するはずです。この1年間の進歩の速さには驚かされます。どのようなアプリケーションにするかはユーザーが決めることです。自分の手を汚すことを恐れないでください。その結果、嬉しい驚きがあるかもしれません」と述べました。

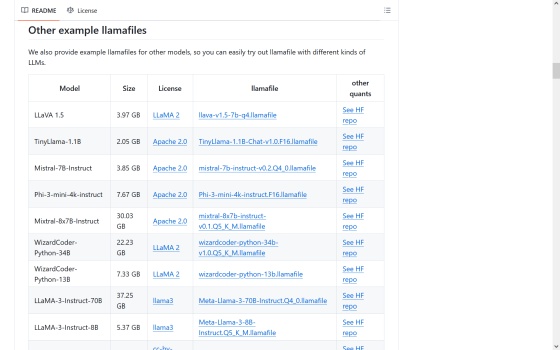

ローカルでAIモデルを動作させる方法の1つとして、Mozillaの開発者が提供している「llamafile」というツールを使うものがあります。

GitHub - Mozilla-Ocho/llamafile: Distribute and run LLMs with a single file.

https://github.com/Mozilla-Ocho/llamafile?tab=readme-ov-file

上記のURLにアクセスしたら「Download llava-v1.5-7b-q4.llamafile」にかかったリンクをクリックします。

ダウンロードしたファイルの拡張子を「.exe」に変更します。

ファイルをクリックするとブラウザが立ち上がり、チャットインターフェイスが表示されます。

上記の方法だと「LLaVA 1.5」をローカルで実行できます。他のモデルのリンクもいくつか用意されています。

・関連記事

「オープンソース」を称するAIモデルは実際どのくらいオープンなのか? - GIGAZINE

1立方ミリメートルの脳の断片をハーバード大学とGoogleの研究者がナノメートル単位で3Dマッピングすることに成功 - GIGAZINE

Googleが大規模言語モデル「Gemma 2」をベースとしたパラメーターサイズがコンパクトな「Gemma 2 2B」、AIモデルの入出力をフィルタリングする「ShieldGemma」、モデル解釈ツール「Gemma Scope」を発表 - GIGAZINE

Mistral AIがコード生成特化型AI「Codestral Mamba」をオープンソースライセンスでリリース - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Why do researchers need to run AI on the….