「オープンソース」を称するAIモデルは実際どのくらいオープンなのか?

近年発展を遂げているAI分野では、OpenAIの大規模言語モデル「GPT」がクローズドで開発されている一方、MetaのLLaMAやGoogleのGemmaなどの大規模言語モデルはオープンでの開発が進められています。しかし、「オープンソースで開発を進めている」と称する言語モデルであっても、どの程度オープンなのかは不透明です。そこで、ラドバウド大学の研究チームは、「オープンソース」を称する言語モデルのオープン度合いについて調査結果を報告しています。

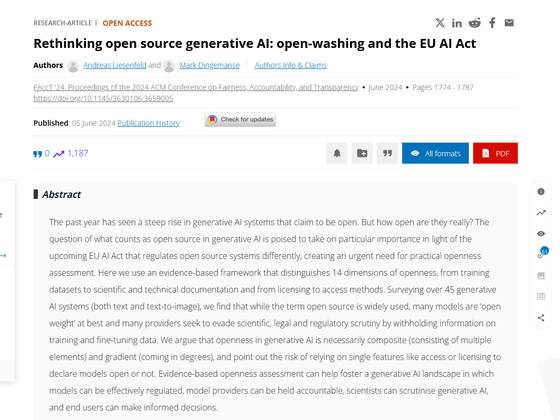

Rethinking open source generative AI: open-washing and the EU AI Act | Proceedings of the 2024 ACM Conference on Fairness, Accountability, and Transparency

https://dl.acm.org/doi/10.1145/3630106.3659005

Not all ‘open source’ AI models are actually open: here’s a ranking

https://www.nature.com/articles/d41586-024-02012-5

「オープンソース」という用語は、ソースコードへのアクセスとプログラムの使用や配布に制限がないことを意味します。しかし、大規模言語モデルの複雑さと関連する膨大なデータ量を考慮すると、全てをオープンソースにすることは決して簡単なことではありません。また、モデルの全てを明らかにすると、商業的または法的リスクにさらされる可能性があるほか、悪用されるリスクも高まります。

それでも、「オープンソース」というラベルを貼るだけで、大規模言語モデルを開発する企業は「自分たちは透明性のある企業」とアピールすることが可能です。

「オープンウォッシング」と呼ばれるこの慣行の実態を探るため、ラドバウド大学のマーク・ディンゲマンセ氏らの研究チームは「オープンソース」または「オープン」と主張する40個の大規模言語モデルの評価を実施しました。評価には、コードとトレーニングデータの可用性や公開されているドキュメント、モデルへのアクセスのしやすさなどを含めた14のパラメーターが使用されました。

ディンゲマンセ氏らの調査結果の抜粋が以下。どのモデルも「オープン」と主張しているものの、BigScienceのBloomZは全ての項目が「オープン」と評価されている一方で、MetaのLlama 3-Instructにはほとんどオープンな項目がないことが指摘されています。

| 大規模言語モデル | ソースコード | モデルのデータ | モデルの重み | プレプリント | API |

|---|---|---|---|---|---|

| BloomZ | オープン | オープン | オープン | オープン | オープン |

| OLMo | オープン | オープン | オープン | オープン | 部分的にオープン |

| Mistral 7B-Instruct | 部分的にオープン | クローズド | オープン | 部分的にオープン | オープン |

| Orca 2 | クローズド | クローズド | 部分的にオープン | 部分的にオープン | 部分的にオープン |

| Gemma 7B-Instruct | 部分的にオープン | クローズド | 部分的にオープン | 部分的にオープン | クローズド |

| Llama 3-Instruct | クローズド | クローズド | 部分的にオープン | クローズド | 部分的にオープン |

研究チームは「オープンまたはオープンソースと主張する多くのAIモデルが、実際には重みを公開しているだけに過ぎません」と指摘。つまり、外部の研究者はトレーニング済みのモデルにアクセスして使用することは可能ですが、モデルの検査を行ったり、カスタマイズしたりすることは不可能というわけです。また、人間のフィードバックを使用するなど特定のタスクに合わせてモデルがどのように微調整されたかを完全に理解することも困難で、ディンゲマンス氏は「より多くの情報を明かさなければ、『オープン』とは呼べません」と述べました。

また、研究チームによると、分析したモデルの約半数が一般的な記述子以外のデータセットに関する詳細を一切公開していないとのこと。

Googleの広報担当者は「あくまでGemmaは『オープン』で、『オープンソース』ではありません」と述べたほか、「既存のオープンソースの概念は、必ずしも全て受け入れられるわけではありません」と語りました。また、Microsoftの広報担当者は「何がどの程度利用できるかについて、可能な限り正確であるように努めています。モデルやコード、ツール、データセットなどの成果物を一般公開することを選択しているのは、開発や研究コミュニティがAI技術の進歩において重要な役割を担っているためです」と述べています。

ダブリン大学トリニティ・カレッジの認知科学者であるアベバ・ビルハネ氏は「この研究は現在のオープンソース化論争を巡る多くの誇大広告や空論を一刀両断するものです」と主張。ディンゲマンス氏は「科学にとってオープンであることは再現性の面で非常に重要です。再現できなければ、それを科学と呼ぶのは難しくなります」「研究者が革新を起こすための唯一の方法は、既存のモデルを扱うことです。そのためには十分な情報が必要です」と語りました。

・関連記事

IBMが自社製AI「Granite」のコード生成モデルをオープンソース化、116のプログラミング言語でトレーニングされパラメータは30~340億 - GIGAZINE

GoogleのAIに匹敵するオープンソースのAIモデル「Falcon 2」をUAEがリリース - GIGAZINE

Googleがオープンソースのビジュアル言語モデル「PaliGemma」を公開&Llama 3と同等性能の大規模言語モデル「Gemma 2」を発表 - GIGAZINE

NVIDIAがオープンモデル「Nemotron-4 340B」を発表、LLMトレーニング用合成データの生成に革命を起こすか - GIGAZINE

Metaが大規模言語モデルをトレーニングする上でどこに注意したのか&どのように取り組んだのかを解説 - GIGAZINE

Metaはどのようにして大規模なAIを稼働させるインフラをメンテナンスしているのか? - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1r_ut

You can read the machine translated English article How open are so-called 'open source' AI ….