Appleが児童性的虐待資料(CSAM)検出に関する言及を削除

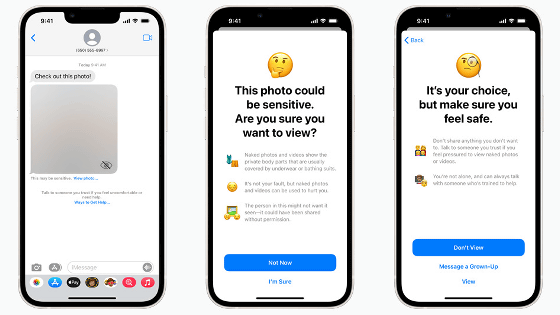

2021年8月にAppleが発表した、端末内に児童性的虐待資料(CSAM)が保存されていないかスキャンする機能は、セキュリティやプライバシーの観点から大きな反発を招き、実装の延期が決まっています。新たに、Appleのサイト上にある「子どもの安全」に関するページで、以前まで存在したCSAMに関する言及が削られていることが明らかになりました。

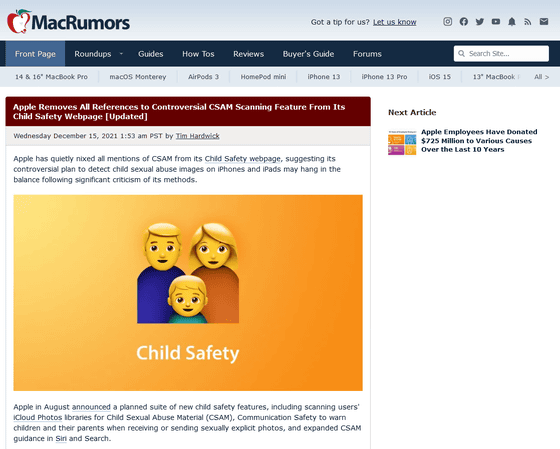

Apple Removes All References to Controversial CSAM Scanning Feature From Its Child Safety Webpage [Updated] - MacRumors

https://www.macrumors.com/2021/12/15/apple-nixes-csam-references-website/

Apple scrubs controversial CSAM detection feature from webpage but says plans haven’t changed - The Verge

https://www.theverge.com/2021/12/15/22837631/apple-csam-detection-child-safety-feature-webpage-removal-delay

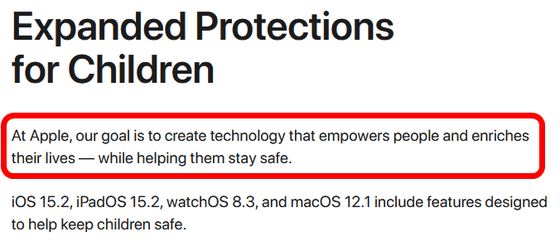

これはニュースサイト・MacRumorsが指摘したもの。当該ページで、Appleは「人々に力を与え生活を豊かにするテクノロジーを生み出し、人々が安全でいられるよう手助けする」ことを目標に掲げており、子どもがメッセージングアプリで裸の写真を送信したり受信したりしたときに警告を発する機能があるということを説明しています。

Child Safety - Apple

https://www.apple.com/child-safety/

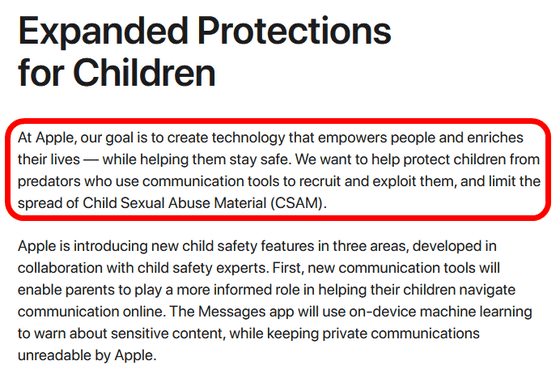

このページには2021年12月10日まで、先ほど掲げられていた目標に加えて、「我々は、コミュニケーションツールを使って子どもたちに声をかけ、食いものにする捕食者から子どもたちを守り、児童性的虐待資料(CSAM)の拡散を抑え込む手助けがしたいと考えています」という文言がありました。この文言は、12月13日のiOS 15.2などのリリースに合わせて消滅しています。

以下は12月10日時点のページを保存したInternet Archive。

Child Safety - Apple

https://web.archive.org/web/20211210163051/https://www.apple.com/child-safety/

MacRumorsは言及が削除されたことで、AppleがCSAMのスキャンに関する計画を放棄したものであると推測しています。

しかしニュースサイトのThe VergeがAppleに問い合わせたところ、広報のシェーン・バウアー氏から「機能延期を表明した2021年9月以来、Appleの立場は変わっていない」と返答があったそうで、機能追加を諦めたわけではないようです。

・関連記事

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も - GIGAZINE

Appleが表明した「iPhoneの写真・メッセージスキャン」については社内からも懸念の声が挙がっている - GIGAZINE

Appleが「児童性的虐待資料検出はプライバシーを損なうものではない」とFAQを発表 - GIGAZINE

「iPhone内の児童ポルノ画像を検知する機能」の延期をAppleが発表 - GIGAZINE

AppleはiCloudメールの添付ファイルを2019年からスキャンしていた - GIGAZINE

Appleの児童ポルノ規制はかえってリスクの増加を招くという指摘 - GIGAZINE

・関連コンテンツ

in メモ, Posted by logc_nt

You can read the machine translated English article Apple removes mention of child sexual ab….