「モザイク画像の解像度を64倍にする研究」が人種差別の議論に発展、非難を集めた研究者はアカウントを停止

計算機科学の分野において功績を収めた人物に贈られるチューリング賞を2018年に受賞した、Facebookの人工知能部門におけるチーフ研究者、ヤン・ルカン氏は、人工知能および機械学習における人種差別の議論で多くの非難を受け、Twitterアカウントを停止することを発表しました。

Yann LeCun Quits Twitter Amid Acrimonious Exchanges on AI Bias | Synced

https://syncedreview.com/2020/06/30/yann-lecun-quits-twitter-amid-acrimonious-exchanges-on-ai-bias/

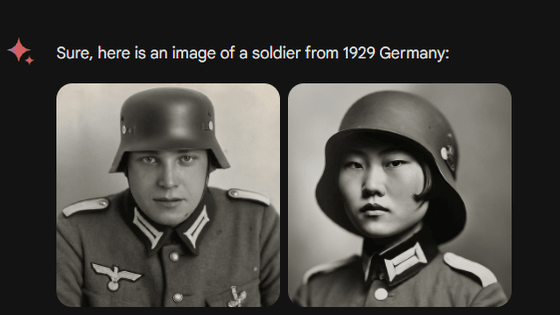

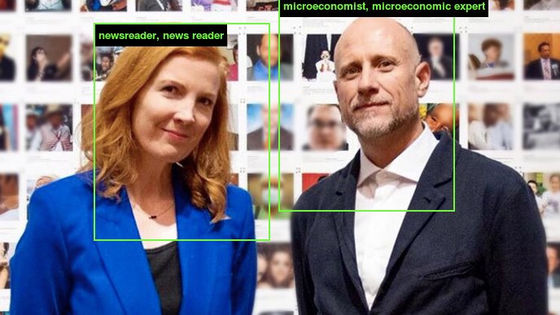

きっかけは2020年6月20日に、デューク大学が人工知能アルゴリズムを用いた高品質の画像生成に関する研究結果をTwitter上で公表したことから始まりました。

Face Depixelizer

— Bomze (@tg_bomze)

Given a low-resolution input image, model generates high-resolution images that are perceptually realistic and downscale correctly.

????GitHub: https://t.co/0WBxkyWkiK

????Colab: https://t.co/q9SIm4ha5p

P.S. Colab is based on thehttps://t.co/fvEvXKvWk2 pic.twitter.com/lplP75yLha

デューク大学が公表したのは、16×16ピクセルのモザイクのような画像を数秒で1024×1024ピクセルの精細な画像に変換してしまうという技術。以下の記事を見ると画像変換の例や使用されている技術について確認できます。

モザイク画像の解像度を64倍にして限りなく高品質の画像を生み出す技術が開発される - GIGAZINE

デューク大学の研究はGitHub上で公開されているほか、以下のウェブサイトで実際に画像変換を試すことができるようになっています。

Face Depixelizer Eng - Colaboratory

https://colab.research.google.com/github/tg-bomze/Face-Depixelizer/blob/master/Face_Depixelizer_Eng.ipynb

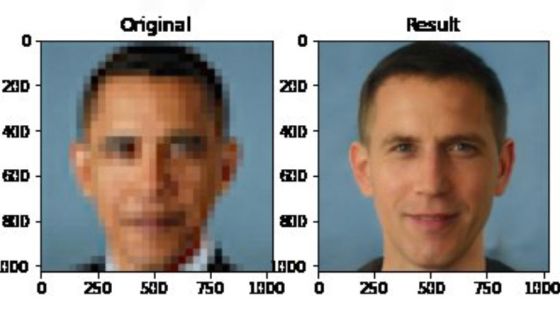

しかし、デューク大学が行った研究はモザイク画像から詳細な画像を「復元」する技術ではなく、人工知能が画像から元画像を類推して「新たな画像を生み出す」という技術です。実際、バラク・オバマ前アメリカ大統領のモザイク画像を変換した人が、オバマ氏の顔が正しく復元されなかったことに疑問を呈しました。

???????????? pic.twitter.com/LG2cimkCFm

— Chicken3gg (@Chicken3gg)

上記のツイートに対し、ペンシルベニア州立大学のブラッド・ワイブル准教授は、「この画像は、人工知能における偏見の危険性を物語っています」とツイート。

This image speaks volumes about the dangers of bias in AI https://t.co/GsoQqSr3XP

— Brad Wyble (@bradpwyble)

そして、ルカン氏がワイブル氏のツイートに対し、「機械学習システムの学習データにバイアスがかかっています。この顔をアップサンプリングするシステムは、主に白人の写真を含むFlickrFaceHQで事前に訓練されているので、変換結果は誰もが白人のように見えます。もしセネガルのデータセットで全く同じ訓練をすれば、誰もがアフリカ人に見える結果になるでしょう」とツイートしました。

ML systems are biased when data is biased.

— Yann LeCun (@ylecun)

This face upsampling system makes everyone look white because the network was pretrained on FlickFaceHQ, which mainly contains white people pics.

Train the *exact* same system on a dataset from Senegal, and everyone will look African. https://t.co/jKbPyWYu4N

人工知能分野において黒人を守る「Black in AI」グループの創設者であり、Googleで倫理人工知能チームの技術リーダーを務めるティムニット・ゲブル氏は、ルカン氏の発言を受けて「このフレーミングにはうんざりしています。多くの人が説明しようとしてきたし、多くの学者も説明しようとしてきました。私たちの話を聞いてください。機械学習による弊害をデータセットだけのせいにしないでください」とツイートしました。

I’m sick of this framing. Tired of it. Many people have tried to explain, many scholars. Listen to us. You can’t just reduce harms caused by ML to dataset bias. https://t.co/HU0xgzg5Rt

— Timnit Gebru (@timnitGebru)

顔認識システムや人工知能アルゴリズムにおける人種や性の偏りに関する研究で知られるゲブル氏は、長年にわたり人工知能における公平性や倫理性を提唱し、「機械学習のデータセットを多様化しよう」と主張してきました。同氏がMITメディアラボと共同で行った研究では、「市販の顔認識ソフトウェアは、肌の色が薄い男性に比べて肌の色が濃い女性の方が誤分類されやすい」ということが明らかになっています。

ルカン氏は、自身のコメントはデューク大学が用いた特定のデータセットに対するものであると弁明。また、データの選択に注意を払う必要があるのは「機械学習の研究者でなく、機械学習を利用する技術者である」とも述べています。

Not so much ML researchers but ML engineers.

— Yann LeCun (@ylecun)

The consequences of bias are considerably more dire in a deployed product than in an academic paper.

しかし、ゲブル氏はルカン氏のツイートに対し「信じられない」と述べ、「私たちは彼のような人々が学ぶべきであると言っています。私たち自身のコミュニティで人々を教育しようとしているのです」とツイート。

This is not even people outside the community, which we say people like him should follow, read, learn from. This is us trying to educate people in our own community. Its a depressing time to be sure. Depressing.

— Timnit Gebru (@timnitGebru)

ルカン氏とゲブル氏の約1週間におよぶ議論は、数千件のコメントやリツイートを集め、多くの著名な人工知能研究者がルカン氏の説明に不満を表明しました。Google Researchの科学者であるデビッド・ハー氏は、「私は敬意を持ってルカン氏の意見に同意しません。機械学習が人種に偏りのあるデータでベンチマークされている限り、機械学習システムの偏りとして反映されます。偏ったベンチマークを行った機械学習で、技術者に偏りのないデータによる再訓練を求めるのは何の役にも立ちません」とコメントしています。

機械学習と人種の問題に関する議論には、ルカン氏とゲブル氏を筆頭に人工知能研究者や人種差別に関する活動家など多くの人々が参加。議論だけでなく、ルカン氏かゲブル氏のどちらかを単に攻撃するだけのツイートも多く集まりました。

2020年6月25日、ルカン氏は「私は、AIの倫理と公平性に関するゲブル氏の仕事をとても尊敬しています。私は偏りが人工知能によって増幅されないことを確認するために働くことについて深く気にかけています。ここでの伝え方が話題を呼んでしまい申し訳ありませんでした」とツイートし、ゲブル氏に謝罪しました。

@timnitGebru I very much admire your work on AI ethics and fairness. I care deeply about about working to make sure biases don’t get amplified by AI and I’m sorry that the way I communicated here became the story.

— Yann LeCun (@ylecun)

1/2

そして、2020年6月29日にルカン氏はTwitterで「先週の投稿に続いて、Twitterやその他の手段で互いに攻撃するのをやめてください。 特にゲブル氏や私の投稿に対して批判的であったすべての人への攻撃を停止してください。言葉であろうとなかろうと衝突は有害であり、逆効果にしかなりません。私はあらゆる形態の差別に反対します。私は自分の価値観と信念についてFacebookに投稿をしました。これが、Twitterでの最後の重要な投稿になります」とツイートし、アカウントへの投稿を停止することを公表しました。

Conflicts, verbal or otherwise, are hurtful and counter-productive.

— Yann LeCun (@ylecun)

I stand against all forms of discrimination.

I made a long post on FB about my values and and core beliefs:https://t.co/TMUCPpZu6m

This will constitute my last substantial post on Twitter.

Farewell everyone.

Twitter上での議論を受け、デューク大学の研究チームも論文を2020年6月24日に更新しました。論文には「全体的に、StyleGANからのサンプリングは、有色人種の顔よりも白人の顔の方がはるかに頻繁に得られるようです。生成された写真は人種的な偏りを示しており、白人を表す写真の72.6%が白人を表しています。アジア人は13.8%、黒人は10.1%とかなり少なく、インド人は写真のわずかな割合の3.4%を示しています」と付け加えられています。

[2003.03808] PULSE: Self-Supervised Photo Upsampling via Latent Space Exploration of Generative Models

https://arxiv.org/abs/2003.03808

・関連記事

「AI」と「機械学習」は何がどのように違うのか?をわかりやすく解説するとこうなる - GIGAZINE

「ブラックリスト」「マスター/スレイブ」というプログラミング用語が「人種差別的」として言い換えられつつある - GIGAZINE

「ヘイトスピーチ検出AI」が逆に人種差別を助長する可能性がある - GIGAZINE

Google Photosが黒人をゴリラと認識した事件で開発者が謝罪 - GIGAZINE

「Amazonの顔認証ソフトの差別性」を巡りAmazonとMITの研究者が対立する - GIGAZINE

・関連コンテンツ