「Amazonの顔認証ソフトの差別性」を巡りAmazonとMITの研究者が対立する

by halfpoint

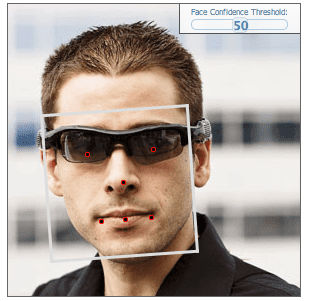

Amazonは低コストな顔認識API「Amazon Rekognition」を開発し、アメリカの警察等の法執行機関に提供しています。マサチューセッツ工科大学の研究者が「Amazonの顔認証ソフトは他社製品に比べて黒人女性の認識精度が低い」との実験結果を発表したところ、即座にAmazonが反論し、MIT側もその翌日に再反論するなど、両者の対立が深まっています。

Actionable Auditing: Investigating the Impact of Publicly Naming Biased Performance Results of Commercial AI Products — MIT Media Lab

https://www.media.mit.edu/publications/actionable-auditing-investigating-the-impact-of-publicly-naming-biased-performance-results-of-commercial-ai-products/

Face Recognition Researcher Fights Amazon Over Biased AI - The New York Times

https://www.nytimes.com/aponline/2019/04/03/us/ap-us-biased-facial-recognition.html

機械学習を用いた顔認証システムについては、ビッグデータを保有する大企業が競うようにして開発を進めていますが、Googleのフォトアプリ「Google Photos」が黒人の男女に「ゴリラ」とタグ付けしてしまい、開発者が陳謝する事態が発生するなど、各企業ともに苦戦が続く状況です。

Amazonの顔認証システム「Amazon Rekognition」もその例に漏れず、アメリカの連邦議員を犯罪者と誤認識してしまうなど、その精度についてたびたび批判を受けています。しかもAmazon Rekognitionは政府や警察などの公的機関にも積極的に採用されているため、Amazonの株主や従業員、アメリカの連邦議会議員などから懸念の声が上がっていますが、AmazonのベゾスCEOは「今後も法執行機関を含めた顧客への提供を続けていく」との意向を示してます。

Amazon幹部が「顔認識ソフトを法執行機関に提供し続ける」と従業員に対して説明

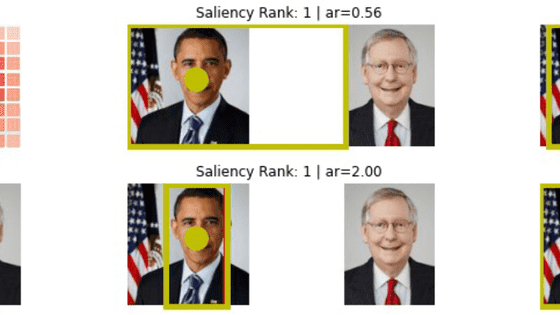

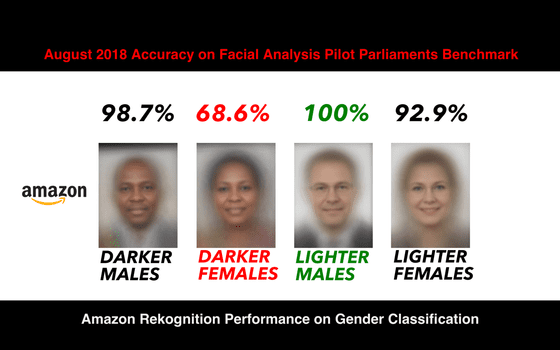

そんな中、Amazon Rekognitionに人種差別的な偏りがあるとの研究結果を発表したのは、マサチューセッツ工科大学で情報科学を研究するJoy Buolamwini氏とInioluwa Deborah Raji氏です。2人が行った実験は、性別や肌の色が異なる1270人の顔写真を「肌が白い男性」「肌が白い女性」「肌が黒い男性」「肌が黒い女性」の4つに分類し、Microsoft・IBM・中国のMegviiが開発した顔認証システムに読み込ませ、男性か女性かの判別結果の的中率を調べるというもの。実験の結果、3社の認証システムはいずれも「肌が白い男性」はほぼ100%正答した一方「肌の黒い女性」の正解率は最低で、Microsoftが98.48%・Megviiが95.9%・IBMが83.03%でした。しかしこの結果は、Buolamwini氏が半年前に実施した同様の調査では3社とも誤答率が30%近かったのに比べて劇的に改善されていることから、「バイアスは大幅に軽減されつつある」と評価しています。

一方で、上記の3社に加えて新たに実験の対象となったのがKairosとAmazonです。実験結果では、肌が黒い女性の正解率がKairosは77.5%、Amazonに至っては68.63%しかなく、もっとも正解率が高いMicrosoftの98.48%とはかけ離れた結果となりました。

by Joy Buolamwini

この結果発表に対し、Amazonは即座に反論。Amazon Web Servicesで人工知能研究の責任者を務めるマット・ウッド氏は技術ブログで、実験では古いバージョンのAmazon Rekognitionが使われていることや、実験が「顔認証」と「顔分析」を取り違えたものであると指摘しています。この指摘は、写真を読み込ませて属性を分析するのは「顔分析」の手法ですが、実験ではAmazon Rekognitionが個人を認識する「顔認証」の機能が使われているというもの。「顔分析」と「顔認証」とでは基盤となる技術や機械学習に使われるデータがまったく違うため、実験結果は正しくないとのことです。ウッド氏は同じ投稿の中で、「顔認識技術が無責任に使用されれば、リスクがあることを我々は承知しています。しかし、新技術に対する不安感のために、間違った実験結果と誤解を招く結論をニュースメディアで拡散させるべきではありません」との意見を述べています。

この反論に対し、Buolamwini氏は自身のブログで、「この分野で使用されている用語は常に一貫しているわけではない」と再反論。また、ウッド氏が「最新バージョンのAmazon Rekognitionは100万人の顔データを99%以上の精度で分析できた」と述べている点についても、「顔データの内訳が分からなければAmazon Rekognitionにバイアスがないかどうかを判断しようがない」と指摘しています。例えば、Facebookは2014年に自社の顔認証システムは97%以上の精度だと公表したたことがありますが、この時に使用した1680人分のデータのうち77%が男性で、80%が白人だったとのこと。

by Aaron Parecki

Buolamwini氏は、法執行機関が性別や肌の色についての分析に偏りがある顔認識システムを使用すれば、必ず差別的な悪用を招くとの懸念を示し、「Amazonが法執行機関や政府機関にこの技術を提供し続けることは無責任です」と述べました。

・関連記事

Amazon幹部が「顔認識ソフトを法執行機関に提供し続ける」と従業員に対して説明 - GIGAZINE

IBMが100万人の顔データを収めた膨大なデータセットを「顔認識技術の公平性」を目指してリリース - GIGAZINE

MicrosoftやGoogleの研究者が「顔認識技術」に規制を求めている - GIGAZINE

Amazonの顔認識技術が28人の議員を「犯罪者」と誤認 - GIGAZINE

Amazon株主がベゾスCEOに「政府への顔認識技術の供与をやめるべき」との要望書を提出 - GIGAZINE

「色による差別」は人種だけでなくロボットでも起こると研究者が指摘 - GIGAZINE

自動運転車は歩行者の肌の色が濃いと衝突事故を起こしやすい - GIGAZINE

Google Photosが黒人をゴリラと認識した事件で開発者が謝罪 - GIGAZINE

Googleはゴリラ画像を検索結果からブロックしている - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, Posted by log1l_ks

You can read the machine translated English article Researchers of Amazon and MIT are in con….