Samsungが高速メモリ「HBM4」のNVIDIAへの供給に向けて最終調整段階に入り2026年2月の量産開始を目指す

Samsungが広帯域幅メモリ「HBM4」の量産開始に向けてNVIDIAと最終調整段階に入ったことが複数のメディアによって報じられています。

Samsung to start production of HBM4 chips next month for Nvidia supply, source says | Reuters

https://www.reuters.com/world/asia-pacific/samsung-start-production-hbm4-chips-next-month-nvidia-supply-source-says-2026-01-25/

Samsung Nears Nvidia’s Approval for Key HBM4 AI Memory Chips - Bloomberg

https://www.bloomberg.com/news/articles/2026-01-26/samsung-nears-nvidia-s-approval-for-key-hbm4-ai-memory-chips

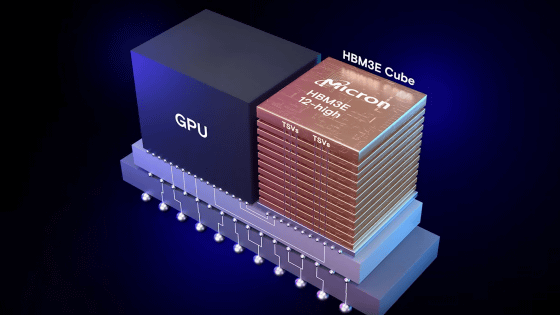

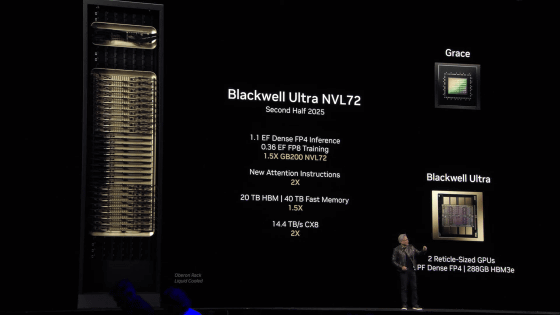

HBMはHigh Bandwidth Memory(広帯域幅メモリ)の略称で、非常に高速な通信が可能であることからデータ交換頻度の高いAI処理チップに採用されています。NVIDIAが2026年後半に提供開始を計画している「Vera Rubin」では次世代規格のHBM4が採用される予定で、SamsungはVera Rubinの計画に間に合わせるために開発を進めていました。

NVIDIAがAI特化の次世代GPUアーキテクチャ「Blackwell Ultra」「Vera Rubin」「Rubin Ultra」を発表、RubinはHopperの900倍の性能でコストはわずか3% - GIGAZINE

ロイターが関係者から得た情報によると、Samsungは2026年2月にHBM4を量産開始する予定だとのこと。また、Bloombergも「SamsungのHBM4はNVIDIAからの認証取得に近づいており、2026年2月に量産開始予定」と報じています。

なお、メモリ分野でSamsungのライバルであるSK hynixもHBM4の開発を進めており、2026年1月初頭に開催されたSEC 2026の会場で16層のHBM4を展示していました。

CES 2026: CEO Kwak Strenghtens AI Memory Partnerships

https://news.skhynix.com/sk-hynix-ceo-kwak-noh-jung-finds-way-forward-for-ai-memory-on-the-ground-at-ces-2026/

・関連記事

NVIDIAが自動運転車開発を加速させるオープンソースAIモデル「Alpamayo」やAIチップ「Rubin」などAI関連ソフトウェア&ハードウェアを大量発表 - GIGAZINE

NVIDIAがAIチップ「Rubin CPX」を発表、動画生成や大規模コーディングタスクに対応するべく数百万トークンの入力に最適化 - GIGAZINE

NVIDIAがAI特化の次世代GPUアーキテクチャ「Blackwell Ultra」「Vera Rubin」「Rubin Ultra」を発表、RubinはHopperの900倍の性能でコストはわずか3% - GIGAZINE

NVIDIAがAIアクセラレータのアップグレード計画を発表、2025年にBlackwell Ultraが登場し2026年にはRubinがデビュー - GIGAZINE

AMDがノートPC向けプロセッサ「Ryzen AI 400」やAI特化GPU「MI455X」などの製品を発表 - GIGAZINE

2026年は供給されるメモリの最大70%をデータセンターが消費し他分野にも品不足が波及へ - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1o_hf

You can read the machine translated English article Samsung enters final adjustment stage fo….