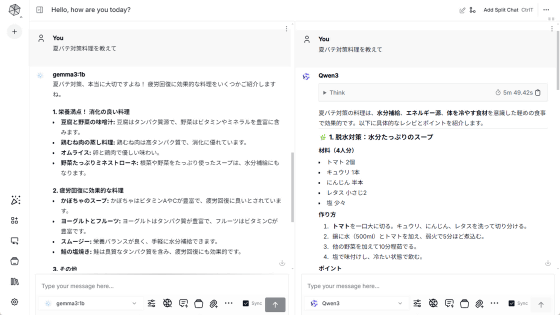

AndroidスマホでもiPhoneでもAIモデルをローカルで実行してチャットできる無料アプリ「Cactus Chat」レビュー

ChatGPTやGeminiといった人気のチャットAIはサーバーで処理を実行していますが、「オフラインでもAIを使いたい」「自分のデータをサーバーにアップロードしたくない」といった需要に応えるべくPCやスマートフォンなどのデバイス上でチャットAIを動作させるための研究開発が進んでいます。「Cactus Chat」もスマートフォン上でチャットAIを動作させられるアプリの1つで、AndroidスマートフォンとiPhoneの両方に対応しています。どれくらいの速度でチャットAIを動作させられるのか気になったので、実際にPixel 9 ProとiPhone 16 Proで使ってみました。

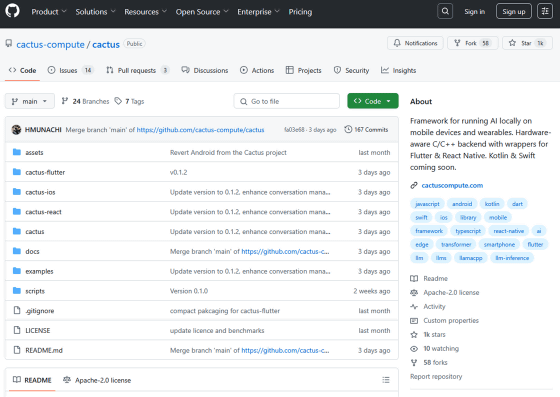

GitHub - cactus-compute/cactus: Framework for running AI locally on mobile devices and wearables. Hardware-aware C/C++ backend with wrappers for Flutter & React Native. Kotlin & Swift coming soon.

https://github.com/cactus-compute/cactus

◆Androidスマートフォンで使ってみる

Android版のCactus ChatはGoogle Playで配布されています。

Cactus Chat - Google Play のアプリ

https://play.google.com/store/apps/details?id=com.rshemetsubuser.myapp

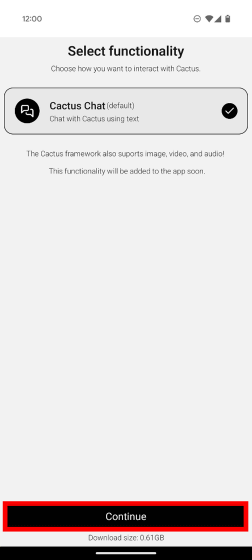

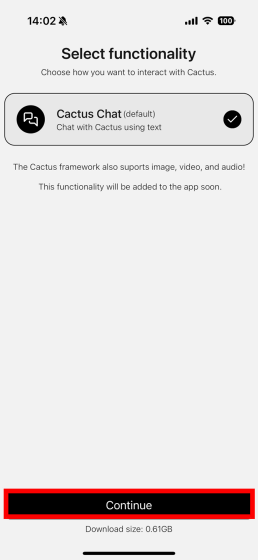

Cactus Chatをインストールして起動すると、サイズ0.61GBのAIモデルをダウンロードするように求められるので「Continue」をタップ。

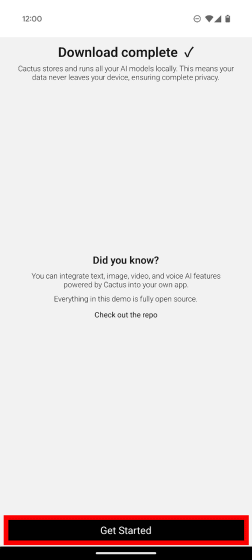

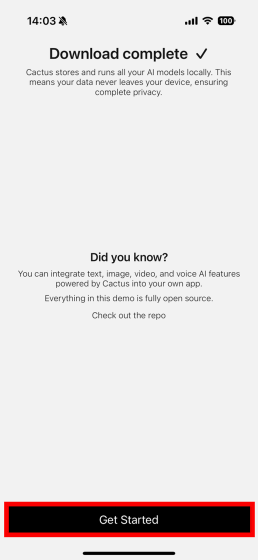

ダウンロードが完了したら「Get Started」をタップします。

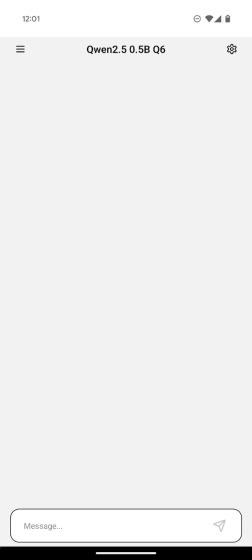

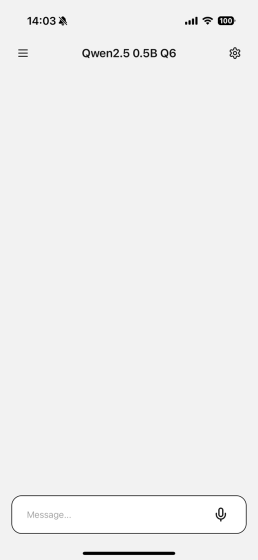

これでローカルでチャットAIを実行できるようになりました。初期状態だとAlibabaが開発した言語モデル「Qwen2.5-0.5B」を使えます。

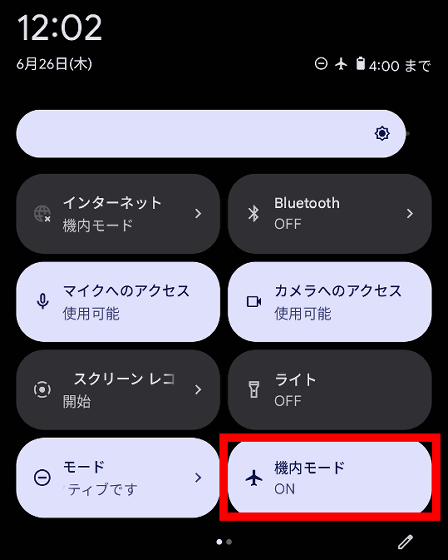

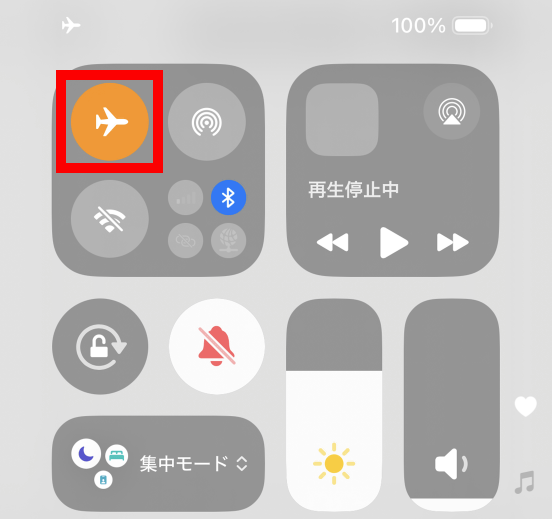

本当にローカルで処理しているのか確かめるために、デバイスを機内モードに切り替えます。

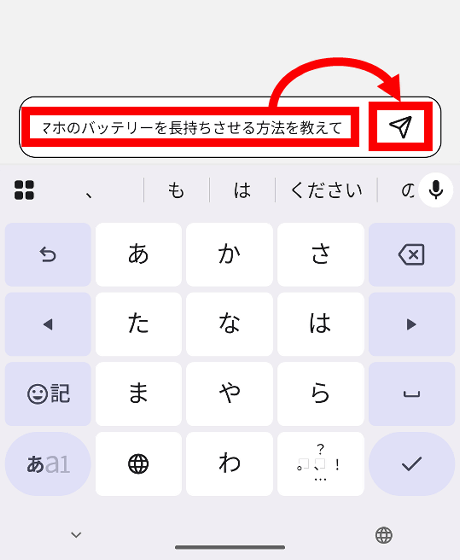

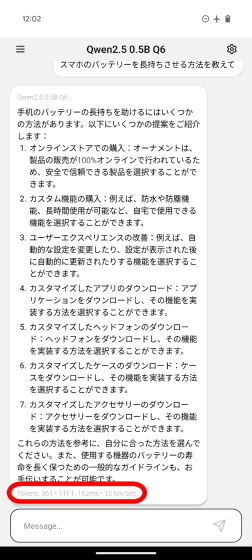

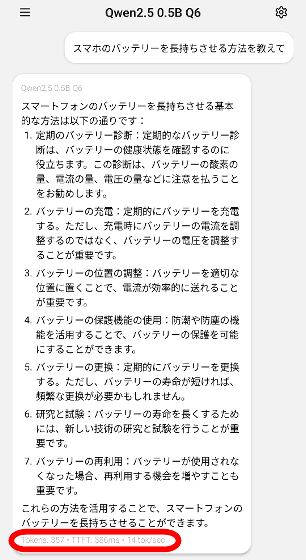

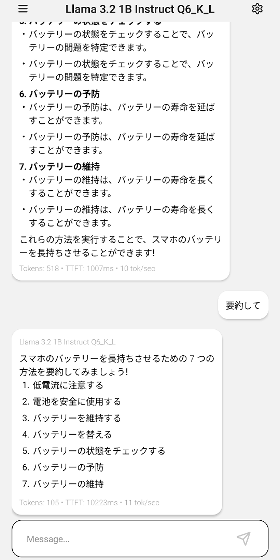

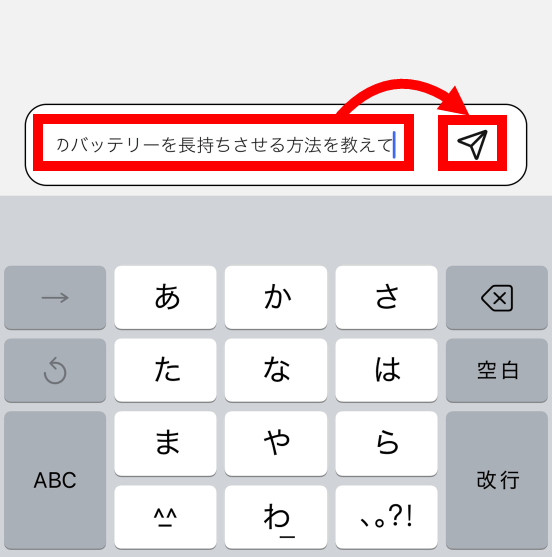

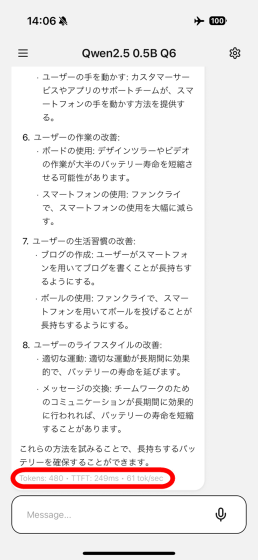

テキスト入力エリアに「スマホのバッテリーを長持ちさせる方法を教えて」と入力して送信ボタンをタップ。

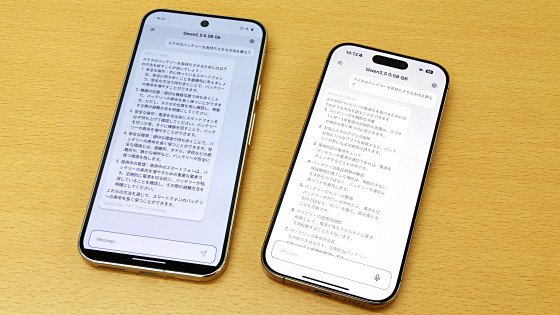

スラスラと回答が出力されました。出力の下部には出力したトークン数、テキストを送信してから最初のトークンが生成されるまでにかかった時間(TTFT)、1秒当たりの出力トークン数が記載されています。Pixel 9 Proの場合、毎秒15トークンを出力できました。

どれくらいの速さで回答を生成できるのかは、以下の動画を再生するとよく分かります。

Pixel 9 ProでチャットAIをローカル実行してみた【Cactus Chat】 - YouTube

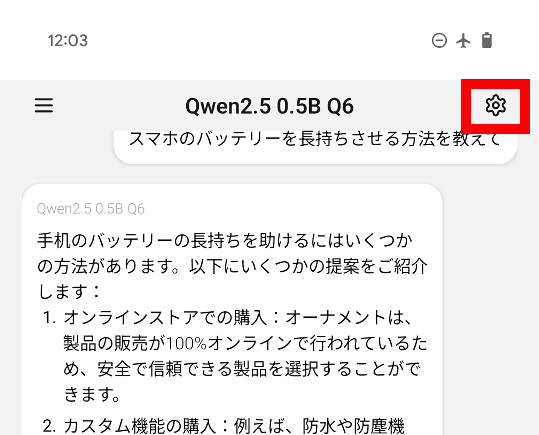

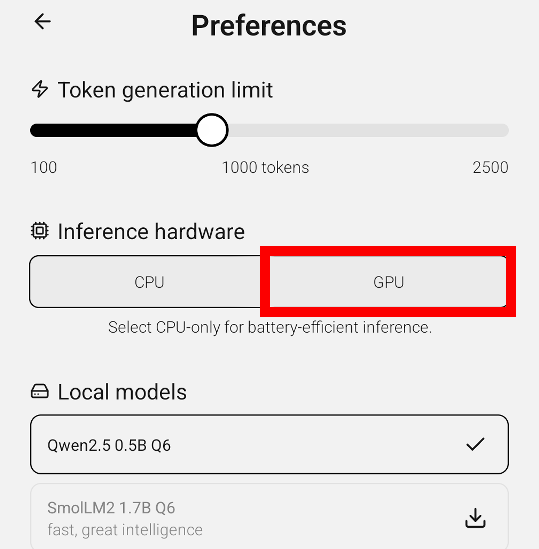

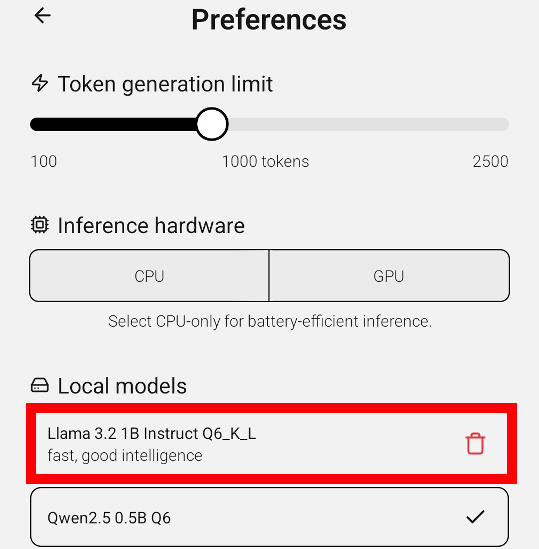

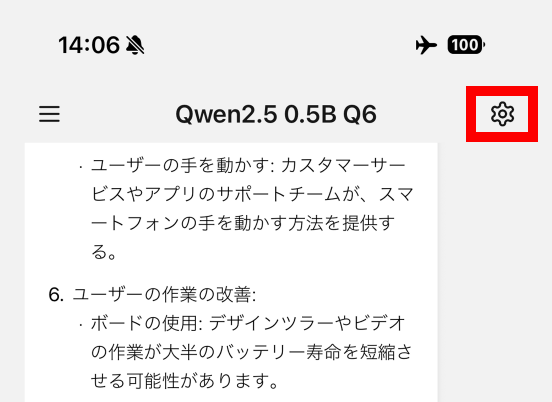

画面右上の設定ボタンをタップ。

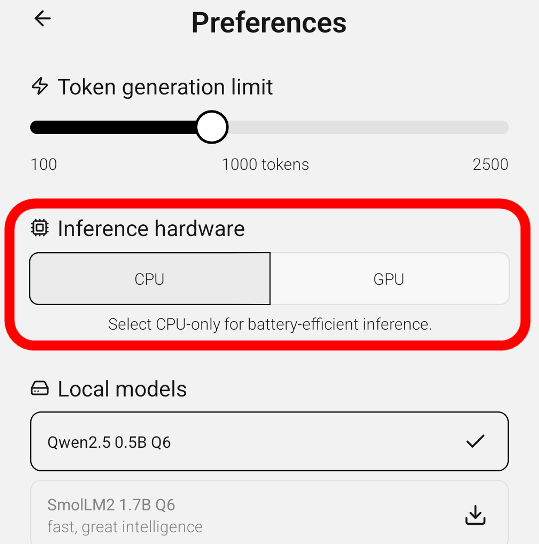

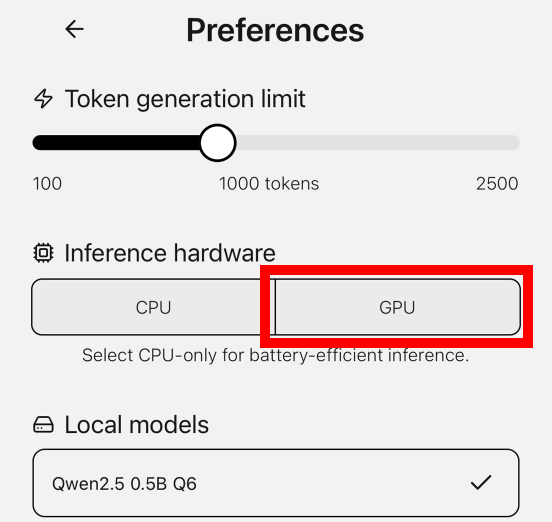

ハードウェアの欄を確認すると、CPUだけを使う設定になっていました。

「GPU」をタップしてCPUとGPUを両方とも使用するように切り替えます。

CPUとGPUを両方使用した場合、1秒当たり出力トークン数が14に減少しました。Pixel 9 ProでCactus Chatを実行する場合、GPUを使っても高速化はできないようです。

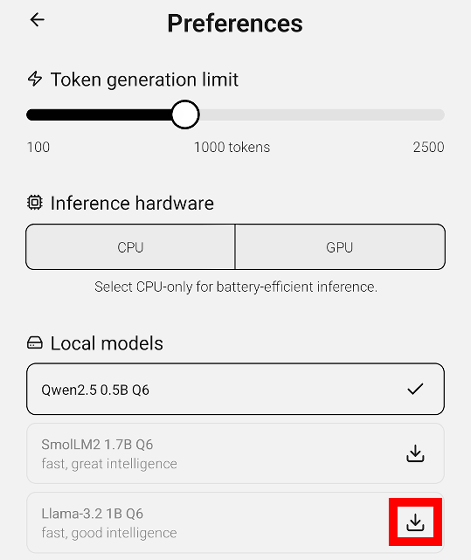

Cactus ChatではQwen以外のモデルも使えます。インターネットに接続しなおしてから、設定画面を開いて「Llama-3.2 1B Q6」の右隣に配置されたダウンロードボタンをタップ。

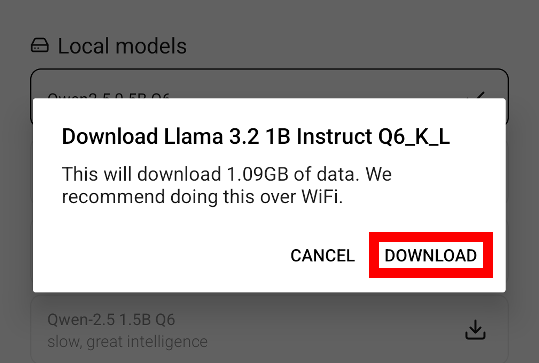

AIモデルはファイルサイズが大きいので、Wi-Fi接続を推奨する画面が表示されます。「Llama-3.2 1B Q6」の場合、ファイルサイズは1.09GBです。「DOWNLOAD」をタップしてダウンロードを続行します。

ダウンロードが完了したら「Llama 3.2 1B Instinct Q6_K_L」をタップ。

これでLlama 3.2を使ってチャットできるようになりました。

◆iPhoneで使ってみる

iOS版のCactus Chatは以下のリンク先で配布されています。

「Cactus Chat」をApp Storeで

https://apps.apple.com/jp/app/cactus-chat/id6744444212

iOS版のCactus Chatの機能や操作方法はAndroidと同一です。まず、初回起動時は「Continue」をタップして0.61GBのファイルをダウンロードします。

ダウンロードが完了したら「Get Started」をタップ。

これでiPhoneのデバイス上でチャットAIを実行できます。

機内モードに切り替えてインターネットから切断します。

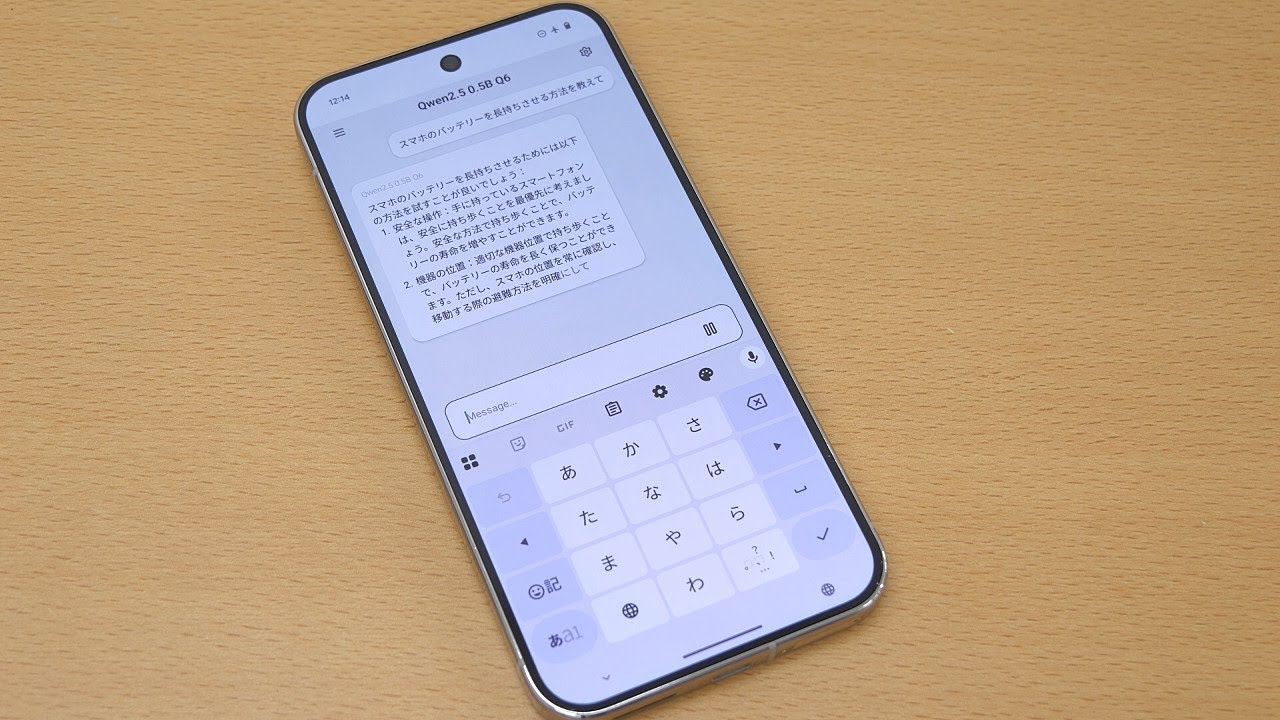

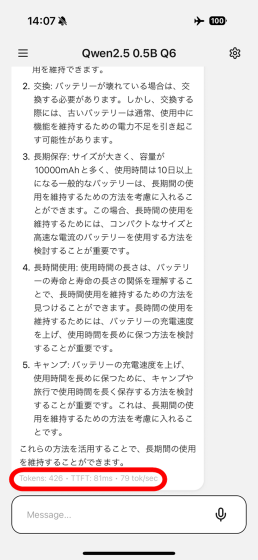

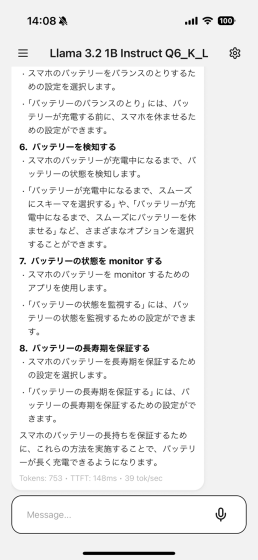

「スマホのバッテリーを長持ちさせる方法を教えて」と入力して送信ボタンをタップ。

iPhone 16 Proの場合、秒間61トークンを出力できました。

設定ボタンをタップ。

iPhone版Cactus Chatも初期状態ではCPUのみを使う設定になっていたので、「GPU」をタップしてCPUとGPUを両方使うように設定します。

CPUとGPUを使うと1秒あたり79トークンを出力できるようになりました。

以下の動画を再生すると、かなりのスピードで出力できていることが分かります。

iPhone 16 ProでチャットAIをローカル実行してみた【Cactus Chat】 - YouTube

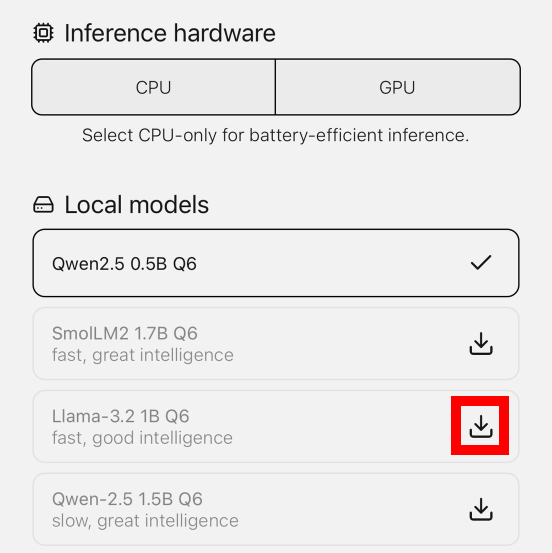

もちろん、iOS版Cactus Chatでも別のAIモデルをダウンロード可能です。「Llama-3.2 1B Q6」の右隣のダウンロードボタンをタップ。

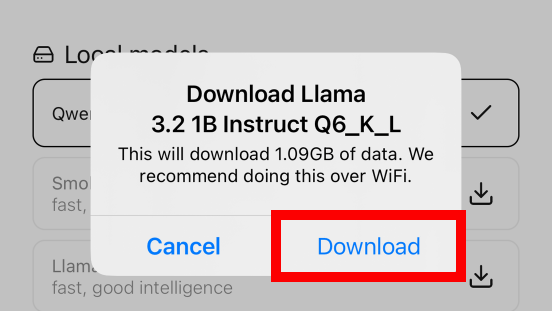

「Download」をタップ。

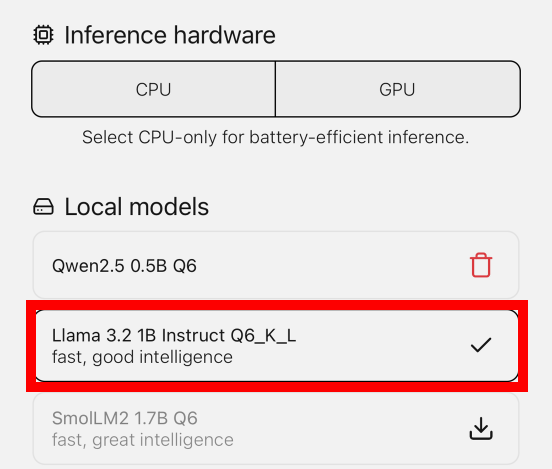

ダウンロードが完了したら「Llama 3.2 1B Instinct Q6_K_L」をタップ。

これで、iPhone 16 Proのデバイス上でLlama 3.2を動かしてチャットできます。

Cactus Chatのソースコードは以下のリンク先で公開されています。ライセンスは「Apache License, Version 2.0」です。

GitHub - cactus-compute/cactus: Framework for running AI locally on mobile devices and wearables. Hardware-aware C/C++ backend with wrappers for Flutter & React Native. Kotlin & Swift coming soon.

https://github.com/cactus-compute/cactus

・関連記事

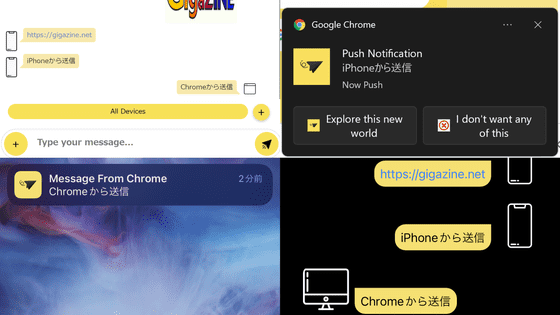

スマホでローカル動作するGoogle製オープンソースAIモデル「Gemma 3n」登場、今すぐスマホで使う方法はコレ - GIGAZINE

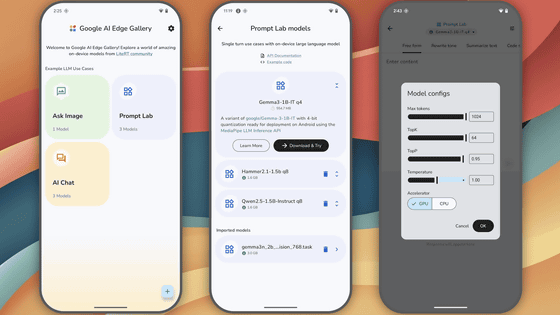

GoogleはAIモデルをスマホにダウンロードしてローカルで実行できるアプリ「Google AI Edge Gallery」をひっそりとリリースしている - GIGAZINE

スマホで録音しながらリアルタイム文字起こし&録音内容の要約もできる「Xiaomi 15」のAI機能を使ってみたよレビュー、打つのが面倒な長文の自動生成機能もあり - GIGAZINE

Apple Intelligenceの「カメラに写った物の詳細をAIに聞ける機能」や「画像内の不要物を消せる消しゴムマジックっぽい機能」を使ってみた - GIGAZINE

ついにApple Intelligenceが日本語に対応してiPhoneで「ラフな文章をビジネス用に書き換える機能」や「画像生成機能」が利用可能になったので使ってみた - GIGAZINE

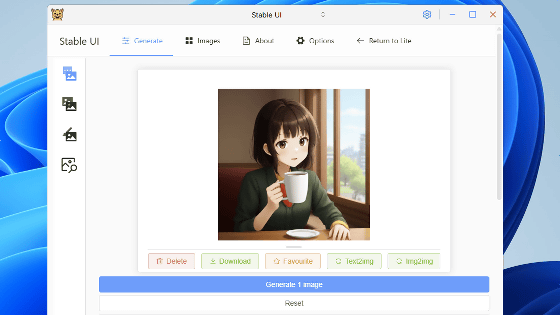

GPU非搭載ノートPCでもコマンド不要で各種言語モデルの性能を試せる実行環境「LM Studio」レビュー - GIGAZINE

ローカルやOpenAIのモデルを使ってAIの力を借りながらメモを作成できるアプリ「Reor」を使ってみた - GIGAZINE

・関連コンテンツ