Mistral AIが多言語&240億パラメータのマルチモーダル・オープンソースAIモデル「Mistral Small 3.1」発表、32GBのRAMで動作しGemma 3やGPT-4o miniよりも優れているとアピール

AI企業Mistral AIが「Mistral Small 3.1」というモデルを発表しました。128Kトークンのコンテキスト長、240億のパラメーターを備えつつ、単一のRTX 4090または32GB RAM搭載のMacで動作する軽量さが特徴とのことです。

Mistral Small 3.1 | Mistral AI

https://mistral.ai/news/mistral-small-3-1

Mistral Small 3.1はテキストと画像の理解能力を備えたマルチモーダルAIモデルで、最大128Kトークンのコンテキスト長、240億のパラメーターを備え、毎秒150トークンの推論速度を実現するほか、さらに英語や日本語など数十の言語をサポートしています。Apache 2.0ライセンスで公開されているため、商用・非商用を問わずある程度自由に利用できます。

ベースとなったモデルは、Mistral AIが2025年1月に公開した「Mistral Small 3」です。Mistral Small 3をさらに軽量化し、低レイテンシでコスト効率に優れた機能を融合することで、Googleの「Gemma 3」やOpenAIの「GPT-4o mini」のような同等のモデルをしのぐ性能が実現されました。

高速推論が可能なレイテンシ重視AIモデル「Mistral Small 3」がリリースされる - GIGAZINE

具体的なユースケースとしては、会話支援や画像理解、関数呼び出しなどが挙げられています。Mistral AIは「Mistral Small 3.1は幅広い生成AIタスクを処理するように設計された汎用(はんよう)性の高いモデルです。単一のRTX 4090または32GB RAM搭載のMacで動作するためオンデバイスのユースケースに最適です。レスポンスの速度が重視されるシーンや、自動化されたワークフローを実行するシーン、法律相談や医療診断など専門性の高いシーンで役立ちます」と述べました。

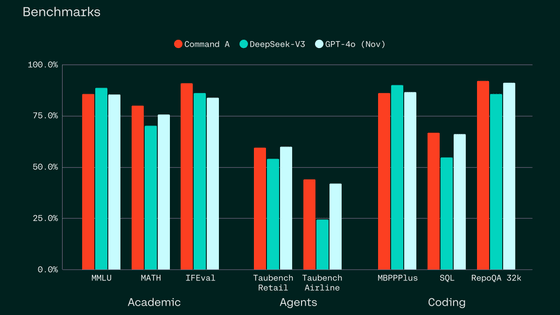

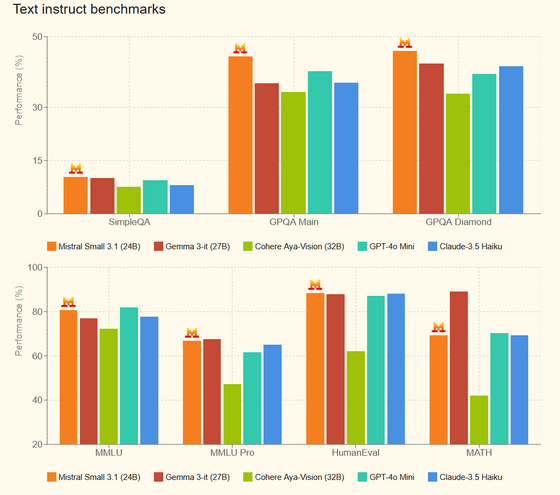

テキスト指示の応答に対するベンチマークテストでは、数学的問題解決の能力を測るMATHベンチマーク以外、Gemma 3-it (27B)、Cohere Aya-Vision (32B)、GPT-4o mini、Claude-3.5 Haikuとほぼ同等か上回る性能を発揮します。

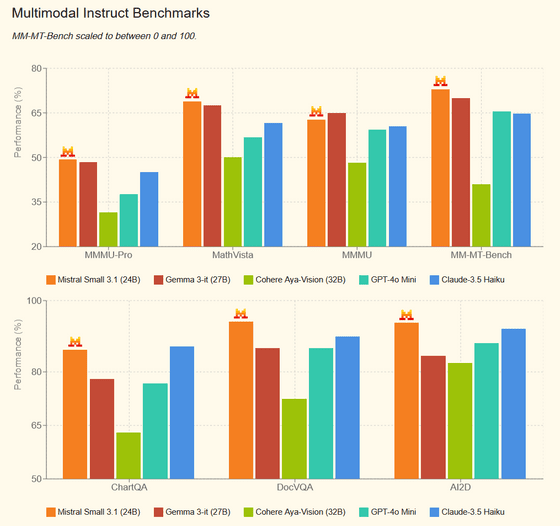

マルチモーダル処理ではこの通り。

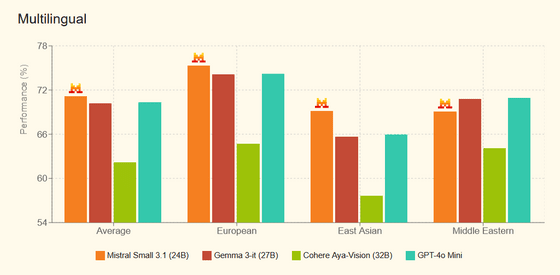

多言語理解においても、他者に引けを取らない性能があります。

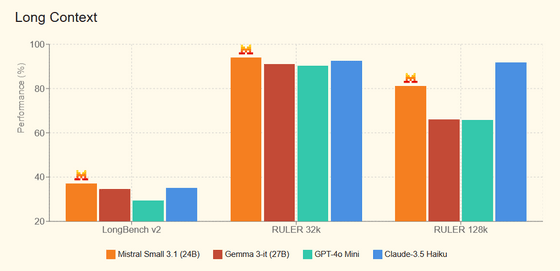

長いコンテキストにおいてはこの通り。

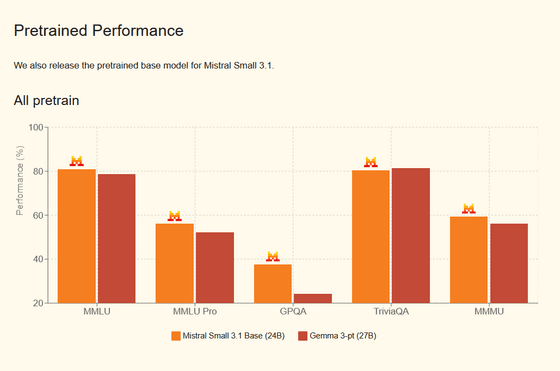

事前トレーニング済みモデルの能力比較においては、ほとんどのテストでGemma 3-it (27B)を上回りました。

Mistral Small 3.1は、Hugging Faceのウェブサイトからダウンロードできるほか、Mistral AIの開発者向けプレイグラウンド「La Plateforme」やGoogle Cloud Vertex AIでも利用可能です。

We're excited to welcome @MistralAI’s newest model, Mistral Small 3.1, to Vertex AI!

— Google Cloud Tech (@GoogleCloudTech) March 17, 2025

Mistral Small 3.1 is an #OpenSource, multimodal model designed for programming, mathematical reasoning, document understanding, visual understanding, and more → https://t.co/a4hNhrnKBH pic.twitter.com/u7htWyEWcT

・関連記事

高速かつ高精度な文字認識AIモデル「Mistral OCR」が登場、LaTeXで書かれた数式や図表入りPDFのレイアウトを崩さずマークダウン形式で出力できてJSONへのデータ抽出も簡単に - GIGAZINE

Mistral AIがチャットAI「Le Chat」のiOS版とAndroid版を公開、日本語でも使えるので試してみた - GIGAZINE

Mistral AIが124BサイズのマルチモーダルAIモデル「Pixtral Large」リリース、GPT-4oやGemini-1.5 Proなどを上回るパフォーマンス - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Mistral AI announces multilingual & ….