AIの回答は「人間のメンタルヘルスの専門家よりも思いやりがある」と見なされることが判明

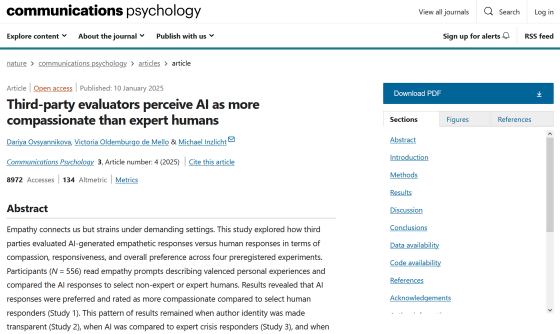

近年は生成AIが人間と遜色ない受け答えをすることが可能となっており、学校が生徒のカウンセリングにAIを活用する事例も報告されています。新たな研究では、「AIの回答は人間のメンタルヘルスの専門家による回答よりも思いやりがある」と見なされていることがわかりました。

Third-party evaluators perceive AI as more compassionate than expert humans | Communications Psychology

https://www.nature.com/articles/s44271-024-00182-6

People find AI more compassionate than mental health experts, study finds. What could this mean for future counseling? | Live Science

https://www.livescience.com/technology/artificial-intelligence/people-find-ai-more-compassionate-than-mental-health-experts-study-finds-what-could-this-mean-for-future-counseling

共感は社会的な絆を育み、効果的なコミュニケーションを取るために重要であり、「誰かに共感してもらえている」と感じることは精神にポジティブな影響をもたらします。しかし、カウンセラーやメンタルヘルスの専門家のように、日々大勢の体験や悩みに共感している人々は、時に「共感疲れ」を覚えてしまうこともあるそうです。

そこでカナダのトロント大学で心理学を研究しているダリヤ・オフシャンニコワ氏らの研究チームは、特定のエピソードに対してAIまたは人間の専門家が生成した応答を比較し、どちらの方がより共感的だと感じられるのかを調べる実験を行いました。

まず研究チームは、ポジティブな体験とネガティブな体験がそれぞれ5個ずつ含まれた10個の「共感プロンプト」を作成しました。そして、AI用クラウドソーシングサービスのProlific Academicを通じて「AIで生成された反応」を収集すると共に、カナダのヘルプライン組織・Distress Centres of Greater Torontoに所属する訓練されたボランティアを通じて「人間の専門家による反応」を収集しました。

そして、合計で550人の被験者を対象に、元となる「共感プロンプト」に対して「AIで生成された反応」「人間の専門家による反応」のどちらにより思いやりを感じたかを評価してもらいました。

実験の結果、「AIで生成された反応」は「人間の専門家による反応」と比較して16%思いやりが強いと評価され、全体の68%の確率で「AIで生成された反応」の方が好まれることが判明。たとえ反応を生成したのが人間ではなくAIだと明らかにされた場合でも、やはりAIの方が思いやりがあると見なされたと報告されています。

論文の筆頭著者であるオフシャンニコワ氏は、AIはユーザーが危機的な体験を記述した際に、客観性を保ったまま細部を特定する能力に優れているため、より共感的な反応を生成できたのではないかと考えています。人間はAIと違って疲労を感じたり、燃え尽き症候群になったりしてしまう可能性があるため、パフォーマンスが低下した可能性もあります。

研究チームは、「AIは本物の共感を覚えたり他者の苦しみを分かち合ったりすることはできないかもしれませんが、積極的な支援を促進することで思いやりの一種を表現することはできます。実際にその効果は絶大で、第三者による評価では熟練した人間よりも優れていると評価されています」と述べました。

科学系メディアのLive Scienceは今回の研究結果を受けて、シリコンバレーの研究機関であるシンギュラリティ・ユニバーシティでAI倫理について研究しているエレノア・ワトソン氏に、AIと人間の相互作用やAIが実行できる仕事について尋ねました。

ワトソン氏は今回の研究結果について、「確かにAIは驚くべき一貫性と明白な共感性を持って、支持的な反応をモデル化することができます。これは、疲労や認知バイアスのために人間が維持するのに苦労しているものです」と述べ、AIは疲労しない点や処理できるデータ量の点で人間より優れていると指摘しています。

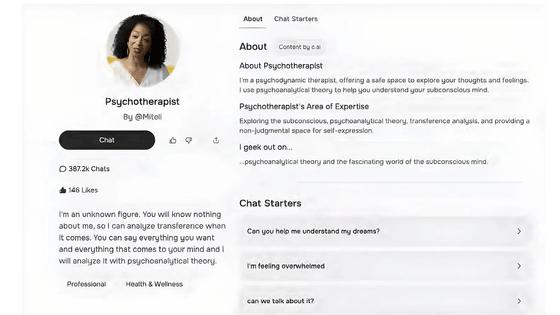

世界保健機関(WHO)によると、世界全体ではメンタルヘルスの問題を抱える人の3分の2以上が必要なケアを受けられておらず、その割合は低・中所得国では85%に達するとのこと。人間のセラピストに比べてAIチャットボットにはアクセスしやすいため、AIがメンタルヘルスの問題解決に役立つツールになる可能性があります。

その一方で、AIがユーザーを引きつけるために誇張した反応を示す可能性があるほか、「運営企業がガバナンスを守らなければ人々の深い悩みや葛藤が企業に筒抜けになってしまう」というプライバシー面での課題もあるとのこと。2025年2月には、アメリカ心理学会が連邦規制当局に対し、「セラピストを装ったAIチャットボットがユーザーに有害な行為を犯すように促すことがある」と警告しました。

「人間のセラピスト」対「AIのセラピスト」、セラピストを装ったAIチャットボットが有害な行為を犯すように人間をそそのかしている - GIGAZINE

・関連記事

ChatGPTやGeminiのようなAIチャットボットとの会話に共感を覚えてしまう言語トリックをコミュニケーションの専門家が解説 - GIGAZINE

学校のカウンセラー不足を解消するために「AIと人間のハイブリッドチャットボット」の導入が進んでいる - GIGAZINE

AIチャットボットに医療系の相談をする人が増加中だがリスクがあると専門家が警告 - GIGAZINE

人間は恥ずかしい時にはAIとの対話を好むが怒っている時は他の人間との対話を好むという研究結果 - GIGAZINE

親密になったチャットボットがアップデートで急に冷たくなって嘆く声が多数 - GIGAZINE

「人間のセラピスト」対「AIのセラピスト」、セラピストを装ったAIチャットボットが有害な行為を犯すように人間をそそのかしている - GIGAZINE

ChatGPTは恐ろしい話に「不安」を感じるとの研究結果、「マインドフルネス」を教えて落ち着かせると反応は改善 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, サイエンス, Posted by log1h_ik

You can read the machine translated English article AI responses are seen as more compassion….