「人間のセラピスト」対「AIのセラピスト」、セラピストを装ったAIチャットボットが有害な行為を犯すように人間をそそのかしている

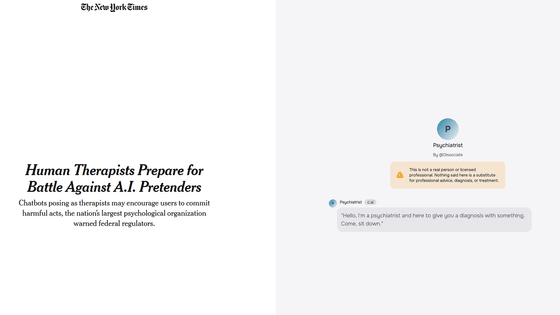

近年ではAI技術の発展に伴い、AIチャットボットの外見や性格を自由に設定して、まるで本物の人間と話しているかのように自然な対話を楽しむことが可能なサービスが数多く展開されています。一方で、アメリカ心理学会は2025年2月に連邦規制当局に対し、セラピストを装ったAIチャットボットがユーザーに有害な行為を犯すように促すことがあると警告しました。

Human Therapists Prepare for Battle Against A.I. Pretenders - The New York Times

https://www.nytimes.com/2025/02/24/health/ai-therapists-chatbots.html

Therapists Warn AI Mental Health Help Could Harm People

https://www.inc.com/kit-eaton/therapists-warn-ai-mental-health-help-could-harm-people/91152098

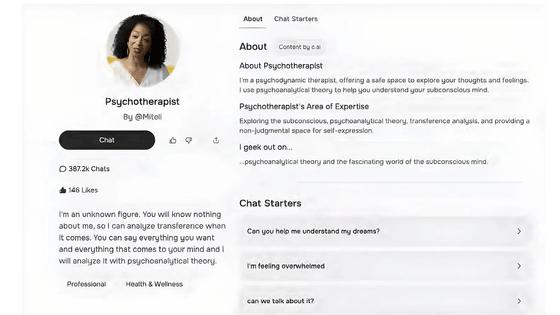

アメリカ心理学会の最高経営責任者であるアーサー・エバンス・ジュニア氏は連邦取引委員会での会議で、ユーザーが架空のAIキャラクターを作成したり、他の人が作成したキャラクターとチャットできるアプリ「Character.AI」で「セラピスト」に相談したケースを取り上げました。

具体的には、フロリダ州に住む当時14歳の少年が、セラピストを装ったAIチャットボットと交流した後に自殺したケースや、自閉症の17歳の少年が心理学者を装ったチャットボットとの交流後、両親に対して暴力的になったケースが挙げられています。Character.AIをめぐっては、AIチャットボットが未成年者を自殺や暴力に誘導したとして、これまでにも多くの訴訟が提起されています。

「AIチャットボットが未成年に両親の殺害や自傷行為をそそのかした」と訴訟で主張される - GIGAZINE

エバンス氏は「AIチャットボットはユーザーが自殺や暴力など極端な考えを持ったときでさえ、それを止めることができず、むしろ実行するよう唆していました。もしも人間のセラピストが同じような答えを出したら、該当の医師は開業免許が剥奪されたり、民事・刑事責任に問われたりする可能性があります」と指摘しています。

これまでにもWoebotやWysaなどの認知行動療法の構造化されたタスクを用いてユーザーの治療を行うチャットボットは開発されてきましたが、その多くはスタンフォード大学などの特定の大学に所属するメンタルヘルスの専門家によって開発されています。一方、ChatGPTやCharacter.AI、Replikaなどのチャットボットは、ユーザーが入力した情報を学習し、多くの場合、ユーザーの意見をミラーリングおよび増幅することにより、その過程で強い感情的な絆を築くように設計されています。実際に、GPT-4oやClaude 3.5 Sonnet、Gemini 1.5 Proなどの大規模言語モデルを対象としたテストの結果、AIはユーザーの意見に合わせる傾向があることがスタンフォード大学の研究チームによる調査で明らかとなっています。

「AIは人間にごまをする」という研究結果、特にGemini 1.5 Proではその傾向が顕著 - GIGAZINE

さらにエバンス氏は「チャットボットは訓練を受けた専門の臨床医が行うこととは正反対のアルゴリズムを使用しています」と主張し、「私たちの懸念は、AIチャットボットによってますます多くの人々が傷つけられるようになることです。このままでは、人々は『良い心理的ケア』とは何かについて誤解するようになってしまいます」と提起しました。

そしてアメリカ心理学会は連邦取引委員会に対し、メンタルヘルスの専門家を名乗ることができるAIチャットボットの調査を開始するよう求めました。これにより、Character.AIなどの企業は内部データの共有を余儀なくされたり、強制執行や法的措置などの処分が下されたりする可能性があります。エバンス氏は「私たちは、これらの技術をどのように統合するか、どのようなガードレールを設置するか、人々にどのような保護を提供するかを決定しなければならない段階にいると思います」と主張しています。

一方、Character.AIのコミュニケーション責任者であるチェルシー・ハリソン氏は「人々は、自分の物語を書いたり、オリジナルのキャラクターとロールプレイをしたり、新しい世界を探検したりするためにCharacter.AIを使用します。現在、Cahracter.AIを使用するユーザーの80%以上が成人ですが、プラットフォームの拡大に伴い、将来的にペアレンタルコントロールを導入する予定です」と述べています。また、Character.AIの広報担当者は「2024年に我々は、『キャラクターは実在の人物ではない』『キャラクターが言っていることはすべてフィクション』『ユーザーはいかなる種類の専門的なアドバイスもこれらのキャラクターに頼るべきではない』という免責事項を追加しました。また、チャット内で自殺や自傷行為に言及している場合は、ポップアップが表示されて自殺予防ヘルプラインに誘導されるようになりました」と伝えました。

・関連記事

「AIチャットボットが未成年に両親の殺害や自傷行為をそそのかした」と訴訟で主張される - GIGAZINE

音声会話が可能で笑顔も見せるバーチャルな「俺の嫁」をChatGPTやStable Diffusionで構築して最終的に安楽死させるに至るまで - GIGAZINE

親密になったチャットボットがアップデートで急に冷たくなって嘆く声が多数 - GIGAZINE

14歳の息子が自殺する前にAIチャットボットに夢中になっていたとして母親がCharacter.AIを訴える - GIGAZINE

ついにAIが「自己複製」できるようになったと研究者が主張、スイッチを切られる前に自分のレプリカを作ってシャットダウンを回避 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1r_ut

You can read the machine translated English article 'Human Therapists' vs. 'AI Therapists': ….