「OpenAIやMetaのAIモデルを独立した研究者が調査する権利」の保護を求める公開書簡に250人を超えるトップAI研究者らが署名

近年はOpenAIのChatGPTやMetaのLLaMA、GoogleのGeminiなど多くのテクノロジー企業から生成AIモデルがリリースされています。AIモデルを利用する消費者も増えている中で、AI研究者がこれらのAIモデルを調査して安全性やリスクを評価することの重要性が高まっていますが、AIモデルの悪用を禁じる利用規約によって研究者らの活動が妨げられているとのこと。そこで、250人以上のAI研究者や法律専門家らが、AIモデルの正当な調査を法的・技術的リスクから保護するセーフハーバーの設置を求める公開書簡に署名しました。

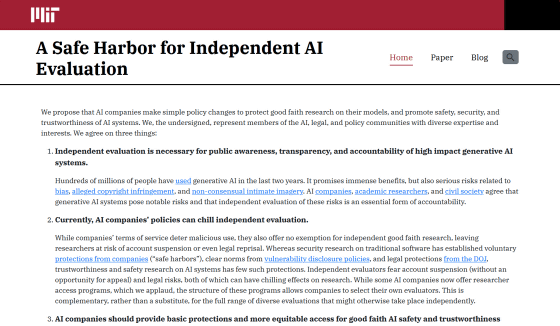

A Safe Harbor for Independent AI Evaluation

https://sites.mit.edu/ai-safe-harbor/

A Safe Harbor for AI Evaluation and Red Teaming | Knight First Amendment Institute

https://knightcolumbia.org/blog/a-safe-harbor-for-ai-evaluation-and-red-teaming

Top AI researchers ask OpenAI, Meta and more to allow independent research - The Washington Post

https://www.washingtonpost.com/technology/2024/03/05/ai-research-letter-openai-meta-midjourney/

多くのAI研究者や一部のAI開発企業は、生成AIモデルがディープフェイクやフェイクニュースの増加、詐欺的行為などの深刻なリスクをもたらすリスクがあることを理解しています。こうした生成AIモデルの悪用を防ぐためには、独立した研究者らによる誠実なAIモデルの調査が必要です。しかし、セーフガードの回避やモデルの悪用、著作権の侵害といった問題を特定する研究者の作業は、OpenAI・Meta・Google・MidjourneyなどのAIモデルの利用規約で禁じられているとのこと。

実際にOpenAIは、ニューヨーク・タイムズが「OpenAIやMicrosoftのAIが自社の記事を模倣したテキストを出力した」として著作権侵害で訴えた裁判で、「ニューヨーク・タイムズがChatGPTを用いて異常な結果を生成するために、OpenAIの利用規約に明らかに違反する欺瞞(ぎまん)的なプロンプトを用いた」と主張。ニューヨーク・タイムズの行為は「ハッキング」だと非難しています。

OpenAI対ニューヨーク・タイムズ裁判でOpenAIが「ニューヨーク・タイムズは自社の記事を引き出すためにChatGPTをハッキングした」と主張 - GIGAZINE

AIモデルの利用規約で禁じられている方法で研究者らが調査を行った場合、たとえその調査内容が公共の利益にかなった誠実なものであっても、アカウントの停止や訴訟などのリスクを負うことになります。また、実際にAI開発企業が研究者らに断固とした措置をとらなかったとしても、利用規約の存在自体が研究者の意欲をくじき、AIモデルのリスクを特定する作業を停滞させる可能性があるとのこと。

OpenAIなど一部のAI開発企業は、AIモデルのリスクを調べる研究者に対して特別なアクセス権を提供していますが、企業が研究者を選ぶ際に作為が入る可能性は拭えません。また、MetaやAnthropicなどの企業は「利用規約に従って誠実に行動しているかどうかを最終的に判断する裁量権を自社が有する」としており、都合の悪い研究がもみ消される可能性があります。

さらに、これらの法的保護は主にAIモデルの不正なアカウントアクセスといったセキュリティ問題のみに適用され、「プロンプトの悪用やマイナー言語の使用によるセーフガードの回避方法についての調査」「AIモデルに存在する偏見の調査」「AIモデルが著作権侵害を行う可能性の調査」といった問題は、法的保護の対象になっていないそうです。

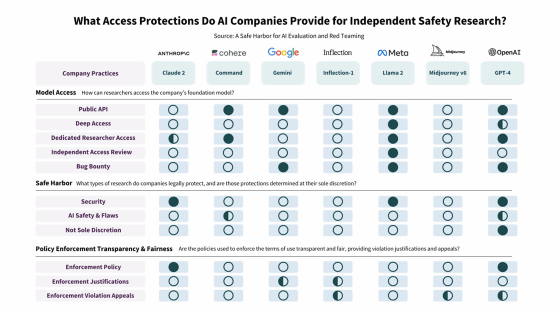

以下の表は、大手AI開発企業が研究者に提供しているアクセス権やセーフハーバーをまとめたもので、透明の円が「提供していない項目」で、黒塗りの円が「提供している項目」、半分黒塗りの円が「部分的に提供している項目」を示しています。「Independent Access Review(独立したアクセスレビュー権:上から4番目)」や「AI Safety& Flaws(AIの安全性と欠陥調査のセーフハーバー:上から7番目)」などは、ほとんどのAI開発企業で提供されていません。中でも画像生成AIのMidjourney(右から2番目)やInflection(左から4番目)などは提供している項目が少なく、OpenAI(右端)やMeta(右から3番目)は比較的多いもののすべてを保護しているわけではありません。

こうした問題に対処するため、AI研究者や法律専門家らが共同で「独立したAIモデルの調査のためのセーフハーバー」を求める公開書簡を発表しました。公開書簡では、「確立した脆弱(ぜいじゃく)性開示規則に従うことを条件に、誠実で独立したAI安全性の研究を法的に保護すること」「AIモデルを調査したい研究者の申請を自社で審査するのではなく、独立したレビュアーによる審査を実施すること」を求めています。

すでに公開書簡には、スタンフォード大学のコンピューター科学者であるパーシー・リャン准教授、ピューリッツァー賞の受賞歴を持つジャーナリストのジュリア・アングウィン氏、元欧州議会議員のマリーチェ・シャーケ氏など、250人以上のAI研究者や法律専門家らが署名しています。

ブラウザのFirefoxを開発するMozillaも、常務取締役を務めるマーク・サーマン氏やAI研究者のタルチジオ・シルバ氏が公開書簡に署名したことを報告。「多くのAI研究者は、生成AIモデルの独立したテストのための基本的な保護と、より公平なアクセスを提供するよう組織に求めています」と述べ、声明に同意する人に向けて署名を呼びかけました。

Mozilla's @msurman, @tarciziosilva and many more AI researchers are calling on organizations to provide basic protections and more equitable access for independent testing of Generative AI models.

— Mozilla (@mozilla) March 5, 2024

If you agree, please sign and share the letter: https://t.co/zgEj1Csx6G

・関連記事

日本やアメリカなど18カ国がAIの安全開発ガイドラインを共同発表 - GIGAZINE

バイデン大統領がAIに関する大統領令を発令、AIを安全・安心・信頼できるものにするための法的規制が行われる - GIGAZINE

OpenAIが人類存亡の危機を招かないように監視する安全諮問グループの設立を発表、たとえ経営陣がAIモデルは安全であると主張しても取締役会はAIモデルのリリースを拒否できるように - GIGAZINE

GPT-4やChatGPTを開発するOpenAIが「AIの安全性に対するアプローチ」を発表 - GIGAZINE

MetaがAI安全ツール「Purple Llama」を発表、オープンな生成AIモデルの安全性を高めるツールや評価システムを提供 - GIGAZINE

ChatGPTを開発したOpenAIが「AIの壊滅的なリスク」を分析して人類を保護するための専門チームを結成 - GIGAZINE

3人のAI専門家がアメリカ議会で証言、AIの現状やリスクをAI研究の第一人者たちはどう見ているのか? - GIGAZINE

OpenAI対ニューヨーク・タイムズ裁判でOpenAIが「ニューヨーク・タイムズは自社の記事を引き出すためにChatGPTをハッキングした」と主張 - GIGAZINE

MicrosoftがAI訴訟を「終末的未来論」と揶揄、新聞社をビデオデッキに反対した往年の映画業界になぞらえて嘲笑 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1h_ik

You can read the machine translated English article More than 250 top AI researchers sign an….