OpenAIが人類存亡の危機を招かないように監視する安全諮問グループの設立を発表、たとえ経営陣がAIモデルは安全であると主張しても取締役会はAIモデルのリリースを拒否できるように

OpenAIが有害なAIのリスクと脅威から守るために社内の安全プロセスを見直し、「Safety Advisory Group(安全諮問グループ)」を技術チームの上に設立することを発表しました。このSafety Advisory Groupは継続的にAIモデルに対するテストを実施し、危険性があった場合は経営陣と取締役会に勧告を行うとのことです。

Preparedness

https://openai.com/safety/preparedness

Preparedness Framework(Beta) | OpenAI

(PDFファイル)https://cdn.openai.com/openai-preparedness-framework-beta.pdf

We are systemizing our safety thinking with our Preparedness Framework, a living document (currently in beta) which details the technical and operational investments we are adopting to guide the safety of our frontier model development.https://t.co/vWvvmR9tpP

— OpenAI (@OpenAI) December 18, 2023

OpenAI buffs safety team and gives board veto power on risky AI | TechCrunch

https://techcrunch.com/2023/12/18/openai-buffs-safety-team-and-gives-board-veto-power-on-risky-ai/

OpenAIは2023年10月に、AIの壊滅的なリスクを分析して人類を保護するための「Preparedness(準備)」チームを結成したことを発表しました。このPreparednessチームは、マサチューセッツ工科大学機械学習(ML)センターの所長を務めたアレクサンダー・マドリー氏が率いており、壊滅的なリスクの追跡・評価・予測を行います。

ChatGPTを開発したOpenAIが「AIの壊滅的なリスク」を分析して人類を保護するための専門チームを結成 - GIGAZINE

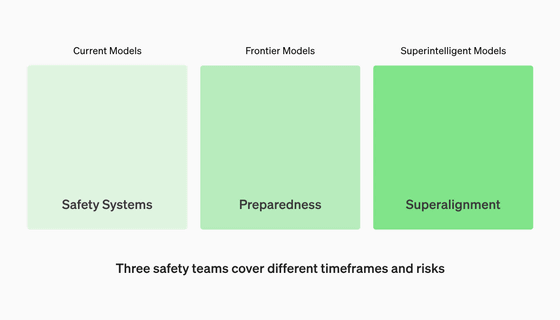

OpenAIはこのPreparednessチームについてのページを2023年12月18日付けで更新。開発中のAIモデルについて調査を行うPreparednessチームに加え、現行モデルのリスクを調査する「Safety Systems」チーム、そして将来的に実用が期待される汎用人工知能などの超知性モデルのリスクを調査する「Superalignment」チームを設け、この3チームでOpenAIの安全性を確保すると発表しました。

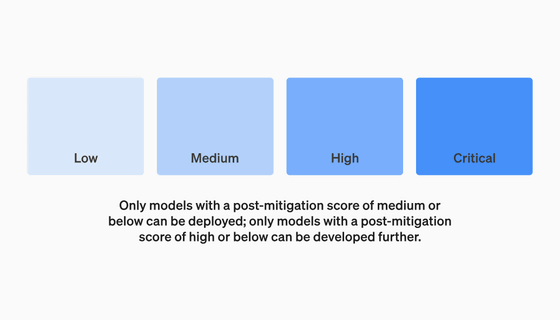

また、安全性評価のレベルを「Low」「Medium」「High」「Critical」の4段階に分け、開発中のAIのリスクがHighを超える場合は開発中止、Mediumを超える場合はリリース中止などのしきい値を設定。各レベルの評価基準については(PDFファイル)ドキュメントにまとめられています。

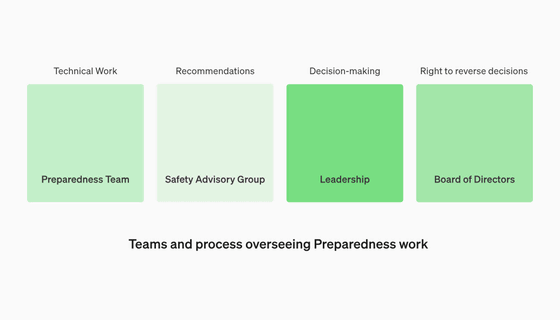

加えて、OpenAIは安全に関する意志決定のための技術的作業と運用構造を監督するための部門「Safety Advisory Group」を設立すると発表しました。このSafety Advisory Groupは、Preparednessチームなどとは別にOpenAIの技術部門を含めた各部門を横断して安全性の評価と報告を行います。

Safety Advisory GroupはOpenAIの技術開発よりも上に存在し、AIモデルに関する定期的な報告書を作成。さらに、その報告書を経営陣と取締役会の両方に提出します。経営陣はSafety Advisory Groupの報告に基づき、AIモデルをリリースするかどうかを決定できますが、取締役会は経営陣の決定に対して拒否権を発動できるとのこと。つまり、経営陣が仮にSafety Advisory Groupの報告書を無視し、高いリスクを抱えるようなAIモデルを独断でリリースしようとしても、取締役会は同じ報告書を理由にその決定を覆すことができるというわけです。

しかし、IT系ニュースサイトのTechCrunchは、2023年11月中旬に起こったサム・アルトマンCEOの電撃退任&復帰劇の結果、アルトマンCEOに反発していたメンバーが取締役会から排除されたことを指摘。その上で、「Safety Advisory Groupが勧告を出し、CEOがその情報に基づいてリリースする決断を下した場合、アルトマンCEOに有効的な取締役会はそれに対して本当にブレーキをかけられるでしょうか?もしそうなった場合、私たちはそのことをどうやって知り得るのでしょうか? 透明性については、OpenAIが独立した第三者から監査を受けるという誓い以外にはあまり触れられていません」と述べ、リスクが現実に存在した場合にSafety Advisory Groupが本当に機能するかについて懐疑的な姿勢を示しました。

◆フォーラム開設中

本記事に関連するフォーラムをGIGAZINE公式Discordサーバーに設置しました。誰でも自由に書き込めるので、どしどしコメントしてください!Discordアカウントを持っていない場合は、アカウント作成手順解説記事を参考にアカウントを作成してみてください!

• Discord | "OpenAIの安全監視部門設立で開発速度に影響は出ると思う?" | GIGAZINE(ギガジン)

https://discord.com/channels/1037961069903216680/1186604238969786408

・関連記事

OpenAIの「超知性」誕生に備える研究チームがGPT-2のような弱いAIモデルでGPT-4のように強力なAIを制御する方法を詳しく説明 - GIGAZINE

ChatGPTの性能低下はホリデーシーズンに休むことを学習したからだという「冬休み仮説」が浮上 - GIGAZINE

「AI規制派は悲観論者」と主張し規制なき市場での成長加速を志す「効果的加速主義(e/acc)」がテック業界で流行中、サム・アルトマンも賛同するe/accとは一体なんなのか? - GIGAZINE

OpenAIのサム・アルトマン追放騒動の裏には幹部から取締役会に寄せられた「従業員への心理的虐待」の苦情があったという報道 - GIGAZINE

OpenAIが開発している新型AI「Q*(キュースター)」とは一体どのようなものだと推測されているのか? - GIGAZINE

・関連コンテンツ

in メモ, ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Announces the establishment of a safety ….