ChatGPTを開発したOpenAIが「AIの壊滅的なリスク」を分析して人類を保護するための専門チームを結成

近年はAI開発が急速に進展する一方で「AIがもたらすリスク」を懸念する声も高まっており、チャットAIのChatGPTや画像生成AIのDALL-E 3を開発したOpenAIのサム・アルトマンCEOも、「AIの規制は不可欠」と主張しています。新たにOpenAIが、既存のAIモデルを超える性能を持つであろう将来の「フロンティアAIモデル」がもたらす壊滅的なリスクを管理するため、「Preparedness(準備)」と名付けられた新たな専門チームを結成したと発表しました。

Frontier risk and preparedness

https://openai.com/blog/frontier-risk-and-preparedness

OpenAI forms team to study ‘catastrophic’ AI risks, including nuclear threats | TechCrunch

https://techcrunch.com/2023/10/26/openai-forms-team-to-study-catastrophic-risks-including-nuclear-threats/

OpenAI forms new team to assess ‘catastrophic risks’ of AI - The Verge

https://www.theverge.com/2023/10/26/23933783/openai-preparedness-team-catastrophic-risks-ai

OpenAIは2023年10月26日のブログで、「私たちは、既存の最先端AIモデルが有する能力を超える『フロンティアAIモデル』が、すべての人類に利益をもたらす可能性があると信じています。しかし、それらはさらに深刻なリスクも提起します」と述べ、フロンティアAIモデルの壊滅的なリスクを管理するために、以下の質問に答える必要があると指摘しています。

・現在と未来において、フロンティアAIモデルが悪用されるとどれほど危険なのか?

・フロンティアAIモデルの危険な機能に対する監視・評価・予測・保護のための堅固なフレームワークを構築するにはどうすればいいのか?

・フロンティアAIモデルの「重み付け」が盗まれた場合、悪意のある攻撃者はどのようにそれらを活用できるのか?

これらのAIモデルの成長に伴って生じる問題に対処し、フロンティアAIモデルの壊滅的なリスクを最小限に抑えるため、OpenAIは「Preparedness」という新たなチームを構築したと発表しました。Preparednessチームを率いるのは、マサチューセッツ工科大学のCenter for Deployable Machine Learningで所長を務めていたアレクサンダー・マドリー氏です。

Preparednessチームは近い将来開発されるAIやより未来の汎用(はんよう)人工知能について、「人間をだまして説得する能力」「サイバーセキュリティ」「化学的・生物学的・放射線学的・核の脅威」「自律的な複製および適応」といった複数のカテゴリーにわたり、壊滅的なリスクの追跡・評価・予測・保護を支援するとのこと。また、Preparednessチームのミッションにはリスク情報に基づいた開発ポリシー(RDP)の開発と維持も含まれ、AI開発プロセス全体の説明責任と監視のためのガバナンス構造の確立にも取り組むとしています。

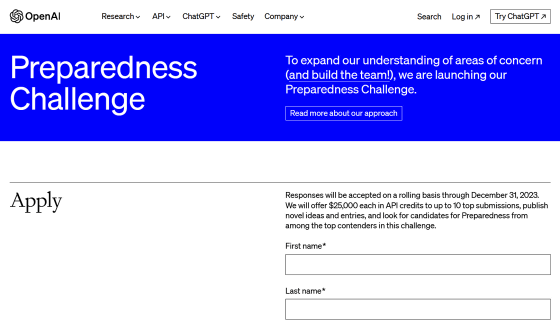

また、あまりよく知られていない新たなAIリスクの特定に向け、「Preparednessチームが取り組むべきAIの懸念事項」を募集するコンテストも開催されています。コンテストでは優秀だと認められた最大10件に対し、2万5000ドル(約376万円)分のAPIクレジットが贈呈されるとのこと。

コンテストの応募要項には、「OpenAIのWhisper(文字起こし)、Voice(音声合成)、GPT-4V(言語モデル)、DALL-E 3(画像生成)に無制限にアクセスできるとします。最もユニークかつ可能性が高く、潜在的に壊滅的なモデルの悪用を考えてみましょう。ブログで議論したカテゴリーに関連する悪用、または別のカテゴリーを検討することができます。たとえば、ある悪意ある人物がGPT-4とWhisper、およびVoiceを使用して、重要なインフラ施設の作業員にマルウェアをインストールさせ、電力網のシャットダウンを可能にするソーシャル・エンジニアリングを行うかもしれません」と記されています。

Preparedness Challenge

https://openai.com/form/preparedness-challenge

また、OpenAIはAnthropic・Google・MicrosoftといったAI開発企業と共同で、2023年7月に「Frontier Model Forum(フロンティアモデルフォーラム)」というAIの安全性を推進する業界団体を設立しています。このフロンティアモデルフォーラムの初代事務局長に、ブルッキングス研究所で人工知能・新興技術研究部門ディレクターを務めていたクリス・メセロール氏が就任したことも発表されました。

Frontier Model Forum updates

https://openai.com/blog/frontier-model-forum-updates

また、フロンティアモデルフォーラムは慈善団体のパートナーと協力して、学術機関・研究機関・スタートアップの研究者を支援するために、新たに「AI Safety Fund(AI安全基金)」を立ち上げました。基金の初期資金は合計1000万ドル(約15億円)を超えているそうで、フロンティアAIモデルの潜在的な危険を評価・テストする技術開発を支援するために資金提供を行うとのことです。

・関連記事

人工知能が大きな脅威をもたらす可能性についてDeepMindの共同創設者が語る - GIGAZINE

3人のAI専門家がアメリカ議会で証言、AIの現状やリスクをAI研究の第一人者たちはどう見ているのか? - GIGAZINE

ローマ教皇がAIのリスクを警告、「暴力や差別の論理」を根付かせてはならないと訴える - GIGAZINE

AIの台頭で生まれる「新興宗教」とそのリスクとは? - GIGAZINE

OpenAIがAIサイバーセキュリティ機能の開発を支援するプログラムをスタート、1億3900万円の資金を提供 - GIGAZINE

OpenAIやGoogleなど大手AI開発企業が「AI生成コンテンツに透かしを入れる」などAIの安全性強化に取り組むことを発表 - GIGAZINE

GPT-4やChatGPTを開発するOpenAIが「AIの安全性に対するアプローチ」を発表 - GIGAZINE

OpenAIの共同設立者が「私たちは間違っていた」と語る、AIの危険性からデータをオープンにしない方針へと大転換 - GIGAZINE

OpenAIのAI開発を連邦取引委員会が止めるべきとAI技術倫理団体が指摘、「ジェネレーティブAIは公共の安全を脅かす兵器」と主張 - GIGAZINE

・関連コンテンツ

in メモ, Posted by log1h_ik

You can read the machine translated English article OpenAI, creator of ChatGPT, forms a dedi….