MetaがAI安全ツール「Purple Llama」を発表、オープンな生成AIモデルの安全性を高めるツールや評価システムを提供

開発者がオープンな生成AIを使用して製品を構築する際に、安全性を高めるためのツールや評価のシステムを提供するプロジェクト「Purple Llama」を立ち上げるとMetaが発表しました。

Introducing Purple Llama for Safe and Responsible AI Development | Meta

https://about.fb.com/news/2023/12/purple-llama-safe-responsible-ai-development/

Announcing Purple Llama: Towards open trust and safety in the new world of generative AI

https://ai.meta.com/blog/purple-llama-open-trust-safety-generative-ai/

サイバーセキュリティの世界では、攻撃者のツールとテクニックをエミュレートしてセキュリティの有効性を確かめるチームのことをレッドチーム、実際の攻撃者やレッドチームからシステムを防御するセキュリティチームのことをブルーチームと呼びます。Metaはこの考え方を生成AIのリスク評価にもちこみ、攻撃と防御が協力してリスクを軽減するアプローチを行うことを明確にするためプロジェクトに「Purple(紫)」という名前をつけたとのこと。

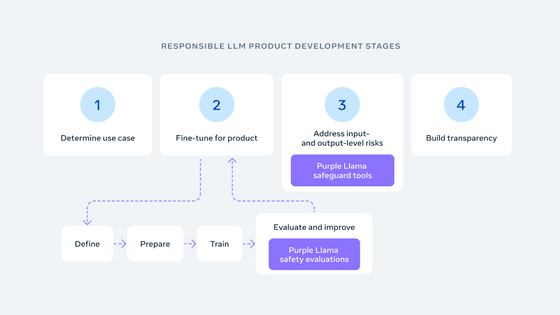

Purple Llamaの目的はMetaのResponsible Use Guideで共有されているベストプラクティスに従って、開発者が責任を持って生成AIモデルを展開できるようにする手助けを行うことです。プロジェクトの立ち上げと同時に「CyberSec Eval」と「Llama Guard」が公開されました。

CyberSec Evalは大規模言語モデルのサイバーセキュリティ安全性評価ベンチマークのセットで、「大規模言語モデルのサイバーセキュリティリスクを定量化するための指標」「安全でないコードを提案する頻度を評価するツール」「悪意のあるコードの生成やサイバー攻撃の実行を困難にするための評価ツール」が含まれており、ホワイトハウスのファクトシートで概説されているリスクの低減に役立つとされています。

また、Llama Guardは危険な可能性のあるコンテンツや完全にアウトなコンテンツを検出するツールで、大規模言語モデルへの全ての入力・出力をチェックするフィルタリングのサポートができるとのこと。

Purple Llamaはオープンなアプローチを採用しており、AI Alliance、AMD、AWS、Google Cloud、Hugging Face、IBM、Intel、Lightning AI、Microsoft、MLCommons、NVIDIA、Scale AI、その他多くの企業と連携して改善・開発を行っていくだけでなく、提供されるツールはオープンソースコミュニティで利用できると述べられています。

なお、2023年12月10日から16日にかけて開催されるNeurIPSのワークショップにてパートナーのTogether.AIとAnyscaleがデモを行い、ツールの技術的な詳細を提供する予定となっています。

・関連記事

バイデン大統領がAIに関する大統領令を発令、AIを安全・安心・信頼できるものにするための法的規制が行われる - GIGAZINE

ホワイトハウスがAIによる害や差別から市民を守り必要に応じたオプトアウトも認める「AI権利章典」を発表 - GIGAZINE

日本やアメリカなど18カ国がAIの安全開発ガイドラインを共同発表 - GIGAZINE

G7がAI開発における安全性を高めるため開発企業向けの行動規範を公表へ、本格的な規制整備までのつなぎとして機能か - GIGAZINE

GPT-4やChatGPTを開発するOpenAIが「AIの安全性に対するアプローチ」を発表 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, セキュリティ, Posted by log1d_ts

You can read the machine translated English article Meta Announces Purple Llama AI Safety To….