2026年までにAIのトレーニングに使うデータが枯渇する「データ不足問題」とは?

インターネット上には膨大なデータが存在しており、それらを学習させることで作られたAIが続々と登場するようになりました。AIの普及が爆発的に進む一方、研究者からはAIシステムを動かす燃料である学習データが枯渇する可能性があると懸念する声が上がっています。

Researchers warn we could run out of data to train AI by 2026. What then?

https://theconversation.com/researchers-warn-we-could-run-out-of-data-to-train-ai-by-2026-what-then-216741

正確で強力なAIの学習には、膨大なデータが必要です。オーストラリア・マッコーリー大学法学部の上級講師で、クリエイティブ産業のテクノロジーの法的規制に詳しいリタ・マトゥリオニテ氏によると、ChatGPTは570GB、文章量にして約3000億語ものテキストデータでトレーニングしているとのこと。

同様にDALL-E、Lensa、Midjourneyなどの画像生成AIを支えているStable Diffusionアルゴリズムは58億の画像とテキストのペアで構成されたデータセット「LIAON-5B」でトレーニングされました。こうしたアルゴリズムの学習データが不十分だと、AIが出力するデータは不正確になるか、または低品質なものになってしまいます。

学習データは量だけでなく質も重要です。例えば、ソーシャルメディアの投稿や不鮮明な写真などの低品質なデータは入手が容易ですが、高性能なAIモデルのトレーニングには不向きです。

より深刻な問題は、SNSから取得したテキストデータは偏見や差別に満ちている危険性や、偽情報や違法なコンテンツが紛れ込んでいるリスクがあるということです。

一例として、MicrosoftがX(当時はTwitter)のコンテンツを使ってAIをトレーニングしようとしたところ、AIは女性差別や人種差別にまみれた発言を生成してしまうようになりました。

Microsoftの人工知能が「クソフェミニストは地獄で焼かれろ」「ヒトラーは正しかった」など問題発言連発で炎上し活動停止 - GIGAZINE

こうした前例があるため、AI開発者は書籍や科学論文、Wikipedia、オンライン記事、フィルタリングされた特定のコンテンツのテキストなど、質の高いデータを探し求めるようになりました。例えば、GoogleはGoogleアシスタントの会話機能を改善するため、自費出版サイト・Smashwordsの恋愛小説1万1000冊を利用しています。

ChatGPTやDALL-E 3のような高性能なモデルは、こうした高品質かつ膨大なデータセットのトレーニングにより作られましたが、その成長には限界が見えつつあります。プレプリントサーバー・arXivで2022年に発表した論文では、「今の調子でAIがトレーニングされれば、2026年までに高品質なテキストデータが枯渇し、低品質なテキストデータは2030~2050年の間に、低品質な画像データは2030~2060年の間に枯渇する」と予測されました。

コンサルティング会社・PwCによると、AIは2030年までに世界経済に最大15.7兆ドル(約2363兆8860億円)の経済効果をもたらすようになる可能性があるとのこと。しかし、2030年までにAIに学習させるデータが底を突けば、AIの発展は遅れてしまうことになります。

とはいえ、マトゥリオニテ氏は「状況は見かけほど悪くはないかもしれません」と話します。というのも、AIモデルの発展については未知数な部分が多いからです。

また、データ不足のリスクに対処する方法の模索も行われています。その方法の1つは、アルゴリズムを改良して既存のデータをより効率的に使えるようにすることです。使用するデータを節約できるようになれば、少ない演算能力でより高性能なAIシステムをトレーニングすることが可能になるため、AI開発の過程で排出される二酸化炭素の削減にもつながります。

もう1つの手法として、AIを使ってトレーニング用のデータを合成するというものがあります。これにより、AI開発者は特定のAIモデルに合わせて必要なデータを合成することができるようになります。すでに、いくつかのプロジェクトがAIモデル用合成データ作成企業・MOSTLY AIから入手した合成コンテンツを活用しており、この手法は今後より一般的になっていくとマトゥリオニテ氏は考えています。

AI開発者はまた、大手出版社やオフラインのリポジトリが所有するコンテンツのような、無料のインターネット以外の場所にも活路を見いだそうとしています。世界最大級のニュースコンテンツの保有者であるNews Corpは2023年9月に、AI開発者とコンテンツ取引についての交渉を進めていると発表しました。このように、これまで無料のコンテンツを半ば無断で使ってきたAI開発は、有料コンテンツにお金を払う方向へとシフトしつつあります。

こうした流れについて、マトゥリオニテ氏は「クリエイターたちは、AIモデルのトレーニングに自分たちのコンテンツが無許可で使用されることに抗議しており、MicrosoftやOpenAI、Stability AIといったAI企業を訴える人もいます。彼らの仕事に対して報酬が支払われるようになることは、クリエイターとAI企業の間に存在する力の不均衡を改善させることにもなるかもしれません」と述べました。

・関連記事

大規模言語モデルが「幻覚」を引き起こすリスクを客観的に検証できるオープンソースの評価モデルをVectaraがリリース - GIGAZINE

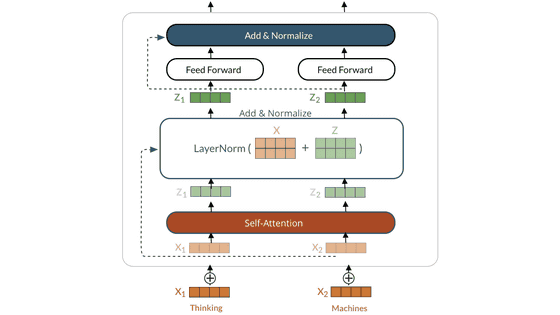

ChatGPTなどの大規模言語モデルはどんな理論で成立したのか?重要論文24個まとめ - GIGAZINE

Googleが「大規模言語モデルに視覚を与える仕組み」について解説、メルカリと協力して作成したデモも公開 - GIGAZINE

OpenAIがGPT-4のアップグレード版大規模言語モデル「GPT-4 Turbo」を発表、2023年4月までの知識を持ちコンテキストウィンドウは128Kで価格は控えめ - GIGAZINE

大規模言語モデルで「無限の入力」を受け付けることを可能にする手法「StreamingLLM」が開発される - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1l_ks

You can read the machine translated English article What is the 'data shortage problem' that….