大規模言語モデルが「幻覚」を引き起こすリスクを客観的に検証できるオープンソースの評価モデルをVectaraがリリース

AIが入力された内容に対して、いかにもそれっぽいように見えるいい加減な内容を出力してしまう現象を「幻覚」と呼びます。AI企業のVectaraが、オープンソースの幻覚評価モデル(HEM)を発表しました。

Measuring Hallucinations in RAG Systems - Vectara

https://vectara.com/measuring-hallucinations-in-rag-systems/

大規模言語モデルは質問に対して的確に答えることもあれば、時として学習データに含まれたいい加減な情報を出力することがあります。大規模言語モデルはあくまでも統計的に言葉を出力しているだけで、出力している内容の意味を理解しているわけではないので、何を言っているのかさっぱり分からないような回答を返してしまう可能性があり、「ユーザーの質問内容に対して、完全にありもしない内容をでっち上げて答えてしまう」「学習データによる特定のバイアスが出力される」など、大規模言語モデルのような生成AIの導入を検討している企業にとって「幻覚」によるエラーは最も懸念するリスクの1つといえます。

多くの企業がこの幻覚リスクによって生成AIの導入を見送ってきたものの、幻覚によるリスクが定量化されていないため、懸念点でありながらも具体的なリスク検討ができていないのが現状です。

Vectaraは、企業における大規模言語モデルの真の力は「検索強化生成(RAG)」によってもたらされると主張しています。RAGは大規模言語モデルが持つ知識の内部表現を補うために、外部の知識ソースにAIを触れさせるもので、幻覚を軽減させる効果があるとのこと。

今回Vectaraが開発したHEMは、銀行の信用格付けが金融リスクを考慮する上で機能するように、大規模言語モデルの正確性や幻覚率を評価することが可能です。Vectaraは、OpenAIのGPTやMetaのLlamaなどといった大規模言語モデルの幻覚率を評価した結果がGitHubで公開しています。

GitHub - vectara/hallucination-leaderboard: Leaderboard Comparing LLM Performance at Producing Hallucinations when Summarizing Short Documents

https://github.com/vectara/hallucination-leaderboard

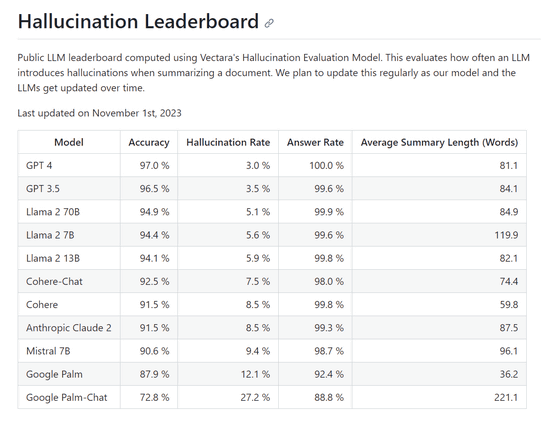

Vectaraによる評価では、1000件の短いドキュメントを大規模言語モデルに公開API経由で入力し、そのドキュメント内に書かれている内容のみを使ってそれぞれのドキュメントを要約するように指示したとのこと。そして、すべての大規模言語モデルが要約に成功した1000件中831件を対象に、要約の「正確性(Accuracy)」と、幻覚で要約が不正確になった「幻覚率(Hallucination Rate)」を算出しました。また、1000件のドキュメントのうちで要約した割合を「解答率(Answer Rate)」、要約した文章の単語数の平均を「要約の平均長(Average Summary Length)」でまとめています。

記事作成時点で最も幻覚を起こしにくかったのはOpenAIのGPT-4で、幻覚率は3.0%でした。一方、幻覚率が最も高かったのはGoogleのPalm-Chatで、27.2%でした。

VectaraがリリースしたHEMはAI関連ライブラリプラットフォームのHugging Faceで、オープンソースで公開されています。

vectara/hallucination_evaluation_model · Hugging Face

https://huggingface.co/vectara/hallucination_evaluation_model

Vectaraのエンジニアであるサイモン・ヒューズ氏は「組織がチャットボットを含む生成AIを効果的に導入するには、リスクと潜在的なマイナス面を明確に把握する必要があります。VectaraのHEMによって、大規模言語モデルによって生成される幻覚のリスクを誰でも測定できます。業界の透明性に対するVectaraの取り組みの一環として、誰もがこの評価を行えるように、私たちはこのHEMをオープンソースとして公開し、誰でもアクセスできるリーダーボードを提供します」とコメントしました。

・関連記事

1600以上のAPIを適切に呼び出してAIに付き物の「幻覚」を大幅に減らす言語モデル「Gorilla」が公開される - GIGAZINE

Googleが「大規模言語モデルに視覚を与える仕組み」について解説、メルカリと協力して作成したデモも公開 - GIGAZINE

「言語を一般化する人間のような能力を持つニューラルネットワーク」の登場によりAIに革新が起こる可能性 - GIGAZINE

ChatGPTが「個人についての不名誉で誤解を招く虚偽の説明」を生成したとしてアメリカ当局がOpenAIの調査を開始 - GIGAZINE

ChatGPTなどの対話型AIは「正解を探す検索エンジン」ではなく「単語の計算機」と考えるべきだという指摘 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Vectara releases open source evaluation ….