「言語を一般化する人間のような能力を持つニューラルネットワーク」の登場によりAIに革新が起こる可能性

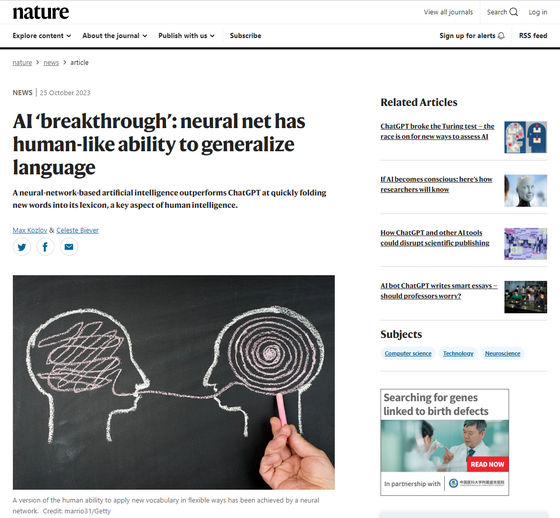

言語における「一般化」を人間のように行えるニューラルネットワークの開発に成功したことが、2023年10月25日に科学誌のNatureに掲載された論文で報告されました。ChatGPTのような人間と自然に対話可能なチャットボットでも、言語の一般化は非常に難しいため、このニューラルネットワークの登場により対話型AIのさらなる進化が見込めると科学誌のNatureが指摘しました。

AI ‘breakthrough’: neural net has human-like ability to generalize language

https://www.nature.com/articles/d41586-023-03272-3

Chatbots shouldn’t use emojis

https://www.nature.com/articles/d41586-023-00758-y

人間は言語を扱う上で、「新しく学習した単語を既存の語彙に組み込み、新しい文脈で使用する」という、一般化として知られるタスクを実施します。一般化は、人々が新しい環境で新しく獲得した単語を難なく使用できる能力によって実証されます。例えば「フォトボム(悪ふざけで写真に写りこむ行為)」という言葉の意味を理解すれば、「フォトボムを2回行う」や「Zoom通話中にフォトボムされた」といった具合に、さまざまな場面で「フォトボム」という単語を使えるようになります。同様に、「ネコがイヌを追いかける」という文を理解できる人は、特に考えなくても「イヌがネコを追いかける」という文を理解できるはずです。

しかし、この言語における一般化能力は、AI研究を支配してきた「人間の認知をエミュレートする」方法であるニューラルネットワークに生まれつき備わっているものではないことが、ニューヨーク大学の認知計算科学者であるブレンダン・レイク氏らによる研究で明らかになっています。人間とは異なり、ニューラルネットワークは単語を使用するサンプルテキストを複数学習するまで、一般化に苦労するそうです。

レイク氏ら研究チームは25人の被験者を対象に、新しく学んだ単語をさまざまな状況でどれだけうまく活用できるかをテストしました。研究チームは2つのカテゴリの無意味な単語で構成される疑似言語を使うことで、被験者の一般化能力を検証しています。

テストでは「dax」「wif」「lug」といった原始的単語を、スキップやジャンプのような基本的な動作を表す単語に設定。そして、より抽象的な機能的単語として「blicket」「kiki」「fep」といった単語を設定しました。原始的単語と機能的単語を組み合わせることで、「3回ジャンプする」や「後ろ向きにスキップする」といった表現ができるようにしています。

次に、被験者は原始的単語を特定の色の円と結びつけるよう訓練されます。具体的には「dax」が赤い円、「lug」が青い円を表すといった具合にです。そして、原始的単語と機能的単語を組み合わせることで、どのような円ができるかを被験者に回答してもらいました。例えば、「dax fep」では「赤色の円が3つ」、「lug fep」では「青色の円が3つ」といった具合に、2種類のカテゴリの単語を一般化する能力を測定したわけです。

テストの結果、人間の被験者は言語の一般化タスクで優れた成果を発揮することが明らかになっています。被験者は平均80%の割合で正しい数の色付きの円を表す単語の組み合わせを回答することに成功したそうです。

次に、研究者は人間の被験者に実施したテストと同じ内容のタスクを実行するようにニューラルネットワークを訓練しました。ニューラルネットワークをトレーニングするための標準的なアプローチである静的データセットを使用するのではなく、AIが各タスクを完了しながらトレーニングできるようにしています。ニューラルネットワークを人間らしくするために、研究チームは人間のテスト結果で観察されたエラーのパターンを再現するようにニューラルネットワークをトレーニングしています。その後、同じルールで新しくテストを作成し、トレーニング後のニューラルネットワークにテストを実施させたところ、正答率は人間とほぼ同一で、場合によっては人間のパフォーマンスを上回ったそうです。

一方で、ChatGPTのベースとなっているGPT-4は同様のテストに苦戦しました。ChatGPTは人間のように流ちょうな会話ができるにもかかわらず、誤答率は人間や前述のニューラルネットワークより低い平均42~86%だったそうです。

レイク氏は「これは魔法ではありません。練習により習得されたものです。子どもが母国語を学ぶときに練習するのと同じように、AIモデルは一連の構成学習課題を通じて構成スキルを向上させます」と言及。また、ジョンズ・ホプキンズ大学で言語専門の認知科学者として働くポール・スモレンスキー氏は、ニューラルネットワークがみせる人間のようなパフォーマンスについて、「ネットワークを体系的に訓練する能力に画期的な進歩があったことを示唆しています」と述べました。

ニューメキシコ州にあるサンタフェ研究所の認知科学者であるメラニー・ミッチェル氏は、「この研究は興味深い原理の証明ですが、トレーニング方法がより大規模なデータセット全体で一般化できるかどうかはまだわかりません」と述べました。一方で、レイク氏は「人間が幼いころから系統的に一般化するコツをどのように身につけて行くかを研究し、その発見を組み込んでより堅牢なニューラルネットワークを構築することで、この問題に取り組みたいと考えています」と語っています。

ドイツのオスナブリュック大学の自然言語処理専門家であるエリア・ブルーニ氏は、この研究によりニューラルネットワークの学習効率が向上する可能性があると言及。さらに、ChatGPTなどのトレーニングに必要な膨大な量のデータが削減され、AIが存在しないパターンを認識して不正確な出力を作成するときに発生する「幻覚」が最小限に抑えられるとも述べました。

・関連記事

ニューラルネットワークの中身を分割してAIの動作を分析・制御する試みが成功、ニューロン単位ではなく「特徴」単位にまとめるのがポイント - GIGAZINE

機械学習の新しいアプローチに線虫の神経系をベースにしたニューラルネットワークが用いられる - GIGAZINE

画像や文章の生成などを行う「ジェネレーティブAI」はなぜ急に発展したのか? - GIGAZINE

畳み込みニューラルネットワークの処理についてアニメーションで解説する「Animated AI」 - GIGAZINE

・関連コンテンツ

in AI, サイエンス, Posted by logu_ii

You can read the machine translated English article Possibility of innovation in AI with the….