Appleが1枚の画像を3Dシーンに変換できる手法「SHARP」を発表、標準的なGPUで1秒未満で処理可能

Appleが、たった1枚の画像から高精度な3Dシーンを生成する手法「SHARP」を発表しました。SHARPはニューラルネットワークを利用し、標準的なGPUでも1秒未満で実行可能とのことです。

[2512.10685] Sharp Monocular View Synthesis in Less Than a Second

https://arxiv.org/abs/2512.10685

SHARP

https://apple.github.io/ml-sharp/

GitHub - apple/ml-sharp: Sharp Monocular View Synthesis in Less Than a Second

https://github.com/apple/ml-sharp

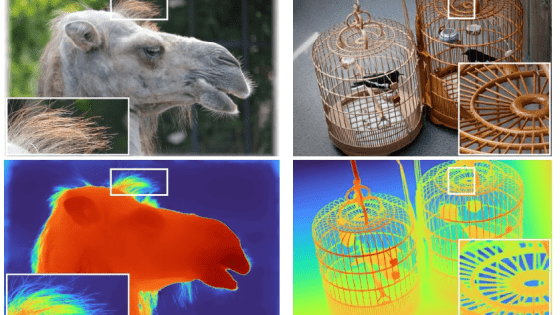

SHARPは1枚の画像を与えられると、描写されたシーンの3Dガウス表現のパラメータを返します。これはニューラルネットワークを介した単一のフィードフォワードパスを介して行われ、標準的なGPUでも1秒未満で実行できるとのこと。

SHARPによって出力された3Dガウス表現は、出力フォルダに3D Gaussian Splatting(3DGS)として保存されます。3DGSは画像や映像から特徴を抽出し、点群(ポイントクラウド)と呼ばれる点の集まりを作り、それぞれの点について周囲の色情報をガウス関数で平均化します。そして3D空間上に色を配置していくことで、非常にリアルな3D空間を構築することが可能です。

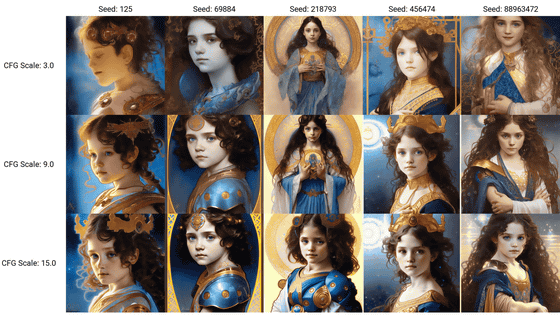

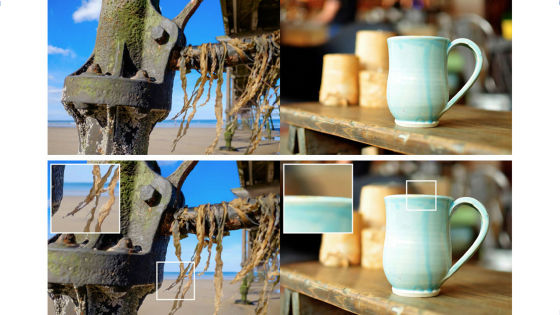

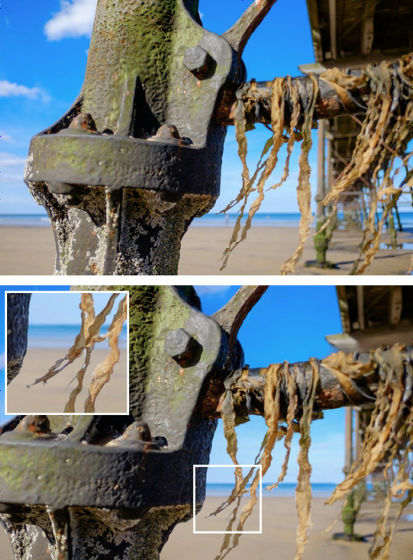

上がSHARPに入力した画像、下がSHARPが生成した3Dシーンを動かして、別の角度から見てみたものです。元の画像とは違う角度になっても、細部が精細に表現されているのがわかります。

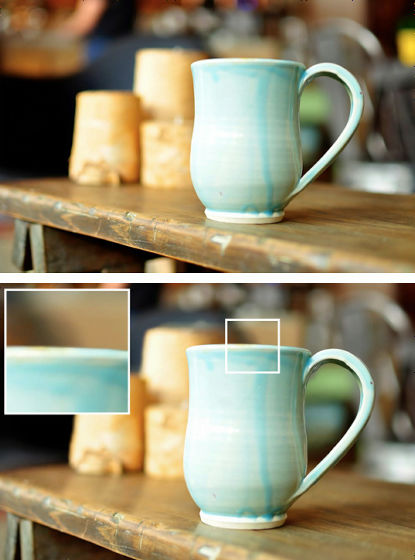

別の画像を入力し、3Dシーンを生成したものがこれ。Appleの研究チームは、SHARPは従来のモデルと比較して、画像評価ベンチマークのLPIPSのスコアが25~34%、DISTSのスコアが21~43%改善されたと報告しています。

なお、今回発表されたSHARPとの関係は不明ですが、Appleはすでに3Dシーン生成技術を「空間シーン」という名前で製品化しています。空間シーンは2025年9月にリリースされたiOS 26から利用可能になっており、Appleデバイスに搭載されているAI専用プロセッサのNeural Engineを利用し、2Dの画像から立体的な画像(空間シーン)を生成できます。

実際に2D写真から空間シーンを生成した様子は、以下の動画で確認できます。

iOS 26の「空間シーン」機能を使って写真を立体的にしてみた - YouTube

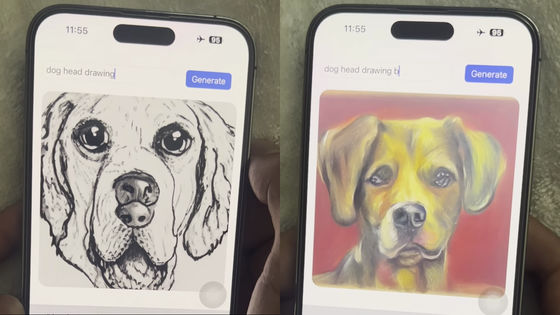

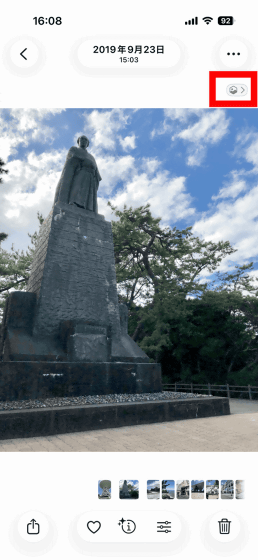

iPhoneのライブラリを開き、画像右上のアイコンをタップ。

すると画像の処理が始まり、ほんの数秒で空間シーンが生成されました。iPhone本体を傾けると写真が立体的に動きます。画像に写っていなかった「枝葉の裏側の空」などが新たに描写されているのが特徴的です。

・関連記事

テキスト・画像・動画から3Dワールドを生成するマルチモーダルワールドモデル「Marble」が一般公開される - GIGAZINE

たった1枚の画像から高解像度の360度画像を生成する「Era3D」 - GIGAZINE

1枚の画像から高品質な3Dメッシュを高速で生成できる「Unique3D」を試してみた - GIGAZINE

テキストや画像から多用途かつ高品質な3Dアセットを自動生成できる3D生成AIモデル「TRELLIS」 - GIGAZINE

Google DeepMindが1枚の画像からプレイ可能な3D世界を生成できるAIモデル「Genie 2」を発表 - GIGAZINE

「iOS 26」配信開始、対応iPhone一覧はコレ - GIGAZINE

iOS 26で「Androidで撮影した写真を拡大表示するとなぜか真っ赤になる」というバグの報告が上がる - GIGAZINE

Appleが「iOS 26.1」を配信開始、Liquid Glassの不透明度を高めるオプションが登場 - GIGAZINE

Apple Vision Proの「visionOS 26」が空間コンピューティングでのウィジェット表示やPlayStation VR2 Senseコントローラーなどの外部アクセサリ入力に対応 - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, スマホ, レビュー, Posted by log1h_ik

You can read the machine translated English article Apple unveils 'SHARP,' a method that can….