AIデータセンターの1万5000個のGPUを相互接続する技術をAlibaba Cloudの研究者が発表、NVIDIA技術を捨ててイーサネットを採用

Alibaba Cloudのエンジニア兼研究者であるEnnan Zhai氏が、LLMトレーニング向けデータセンターのGPUをイーサネットで相互接続する方法に関する研究論文を発表しました。この技術は特に、NVIDIAのGPU相互接続プロトコルであるNVLinkではなくイーサネットを採用している点で斬新とされています。

Alibaba HPN: A Data Center Network for Large Language Model Training

(PDFファイル)https://ennanzhai.github.io/pub/sigcomm24-hpn.pdf

Alibaba Cloud ditches Nvidia's interconnect in favor of Ethernet — tech giant uses own High Performance Network to connect 15,000 GPUs inside data center | Tom's Hardware

https://www.tomshardware.com/tech-industry/alibaba-cloud-ditches-nvidias-interconnect-in-favor-of-ethernet-tech-giant-uses-own-high-performance-network-to-connect-15000-gpus-inside-data-center

Alibaba Cloud reveals datacenter design and homebrew network • The Register

https://www.theregister.com/2024/06/27/alibaba_network_datacenter_designs_revealed/

Zhai氏らの研究チームが発表した論文によると、一般的なクラウドコンピューティングでは10Gbps以下のデータフローが継続的に生成されるとのこと。

一方、AIワークロードでは最大400Gbpsに達するデータバーストが定期的に発生しますが、これによって一般的なデータセンターの負荷分散方式であるECMP(Equal-Cost Multi-Path)でハッシュ分極化、つまり負荷が分散できず利用可能な帯域幅が大幅に減少する問題が発生するおそれがあります。

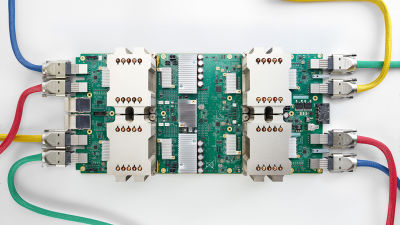

この問題を回避するために、Zhai氏らはAlibabaのデータセンターで独自のハイパフォーマンスネットワーク(HPN)を構築しました。このHPNについて、研究チームは「2層デュアルプレーンアーキテクチャを採用することで、ECMPの発生を抑制してハッシュ分極化を回避し、エレファントフロー(巨大なデータのトラフィック)を保持できるネットワークパスを正確に選択させることが可能になります」と説明しています。

このHPNにより、AlibabaのAIデータセンターでは8個のGPUと9個のネットワークインターフェイスカード(NIC)を搭載した1875台のホストが各400Gbps、合計3.2Tbpsの帯域幅で通信することが可能になりました。GPUを8個搭載したホストが1875台あるということは、このデータセンターでは1万5000個のGPUが相互接続されていることになります。

Alibabaの研究発表で特に注目されている点は大きく分けて2つあります。1つ目は、ホスト間の相互接続にNVIDIAのNVlinkではなくイーサネットを用いている点です。

イーサネットを選んだ理由について研究チームは「ベンダーロックインを避けてEthernet Alliance全体の力を活用し、より速い進化を遂げたいから」と説明していますが、これはNVIDIA脱却を掲げるベンダーらの主張を裏付けるものであると、IT系ニュースサイトのThe Registerは指摘しています。

この選択はまた、データセンター分野でNVIDIAに追いつくことを目指しているAMDなどの競合企業にとっても都合がよく、さらにNVIDIAのテクノロジーの使用を回避したり、データセンターの設置コストを圧縮したりすることにもつながります。

by EdTech Stanford University School of Medicine

2点目は、スイッチにマルチチップではなく51.2Tbpsのシングルチップスイッチを選んだことです。これは、マルチチップスイッチの不安定さと故障率を嫌ったためですが、シングルチップスイッチには動作温度が高温になってしまい、105度を超えるとシャットダウンしてしまうという別の欠点があります。

そこで、Alibabaは独自の「ベーパーチャンバー(VC)ヒートシンク」でチップが105度を超えないようにする冷却システムを開発しました。これにより、ベーパーチャンバー内にあるウィック構造を最適化し、チップの中央により多くのウィック構造の柱を配置することで、さらに効率的に熱を逃がすことが可能になったと論文は説明しています。

AlibabaのHPNは、論文が発表された時点で既に8カ月の運用実績があるとのこと。Zhai氏らの研究チームは、2024年8月にシドニーで開催されるカンファレンスのSpecial Interest Group on Data Communications(SIGCOMM)でこの技術を発表する予定です。

・関連記事

Intelが光でデータ伝送の距離を100倍にする「光コンピューティング相互接続」チップレットを発表 - GIGAZINE

AMD・Intel・Google・Microsoft・MetaなどがNVIDIA対抗のAIアクセラレータ相互接続規格の開発に向けて業界団体を設立 - GIGAZINE

NVIDIAがAIアクセラレータのアップグレード計画を発表、2025年にBlackwell Ultraが登場し2026年にはRubinがデビュー - GIGAZINE

サーバーチップのパフォーマンスとエネルギー効率が2倍に向上する「Grace CPU スーパーチップ」をNVIDIAが発表 - GIGAZINE

NVIDIAが次世代「Ampere」アーキテクチャのデータセンター向けGPU「NVIDIA A100」を発表 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1l_ks

You can read the machine translated English article Alibaba Cloud researchers unveil technol….