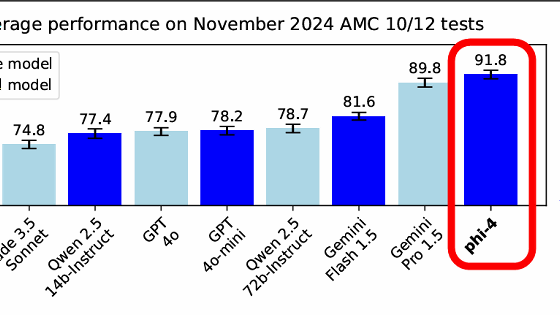

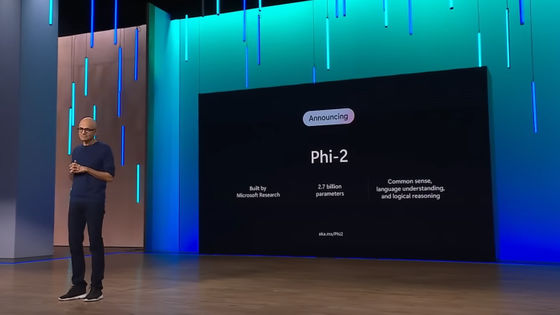

Microsoftが小規模言語モデル「Phi-2」をリリース、小規模なのに最大25倍サイズのモデルと同等以上の性能

2023年11月のイベント「Microsoft Ignite 2023」で発表された言語モデルの「Phi-2」がリリースされました。パラメーター数は27億で小規模なモデルとなっているものの、最大で25倍のモデルと同等の性能を発揮できます。

Phi-2: The surprising power of small language models - Microsoft Research

https://www.microsoft.com/en-us/research/blog/phi-2-the-surprising-power-of-small-language-models/

Today, we share our teams’ latest contributions, Phi-2 and promptbase.

— Microsoft Research (@MSFTResearch) 2023年12月12日

Phi-2 outperforms other existing small language models, yet it’s small enough to run on a laptop or mobile device. https://t.co/wLhUeRsByL

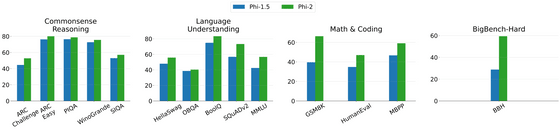

「Phi」はMicrosoft Researchの機械学習基盤チームが開発しているTransformerベースの小規模言語モデルシリーズです。最初のモデルである「Phi-1」は13億パラメーターで、既存の小規模言語モデルの中でPythonコーディングにおいて最先端のパフォーマンスを達成しました。Phi-1を起点に一般的な推論と言語理解の能力を向上させたモデルが「Phi-1.5」で、パラメーター数が13億と小さいながらも5倍大きいモデルと同等のパフォーマンスを発揮しています。

今回リリースされたPhi-2は27億パラメーターのモデルで、パラメーター数が130億未満の基本言語モデルの中で最先端のパフォーマンスを達成できたとのこと。そのほか、さまざまなベンチマークを計測すると最大でサイズが25倍大きいモデルと同等以上の性能を発揮しました。モデルのサイズが小さいためトレーニングや推論などのコストを抑えることができ、言語モデルを研究するのに適しているとのこと。

小さいモデルで大きいモデルに匹敵する性能を出すために、Microsoftはトレーニングのデータと方法に焦点を当てました。トレーニングデータとしては科学や日常生活、心理などの常識・一般知識を教えるためのデータセットと、教育的価値やコンテンツの品質に基づいて慎重にフィルタリングしたウェブのデータセットを使用したとのこと。また、最初にPhi-1.5をトレーニングしてその知識をPhi-2へ移転するという方法を用いることでトレーニングの収束を加速しつつベンチマークスコアを向上させることに成功しました。トレーニングデータの量は1.4兆トークンで、96個のNVIDIA A100 GPUを使用して14日かけてトレーニングを行ったとのこと。

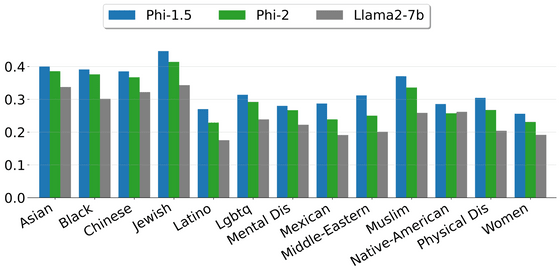

下図はToxiGenに基づいて安全性スコアを算出したもので、スコアが高いほど無害な文を生成しやすいことを示しています。Phi-2はRLHFやファインチューニングによる調整を行っていないベースモデルであるにもかかわらず、毒性やバイアスに関して既存の調整済みモデルであるLlama2-7bよりも優れた結果を出しました。

他のモデルと比較したベンチマーク結果は以下の通り。Phi-2は特にプログラミングや数学など複数のステップが必要な推論タスクにおいて優れたパフォーマンスを発揮しています。

| モデル | サイズ | BBH | 常識的推論 | 言語理解 | 数学 | プログラミング |

|---|---|---|---|---|---|---|

| Llama-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| Mistral | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| Phi-2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

2023年12月6日に登場したGeminiのうち、一番小さいモデルである「Gemini Nano 2」との比較は下図の通り。Phi-2はGemini Nano 2と同等以上の性能を持っていることが確認できます。

| Model | Size | BBH | BoolQ | MBPP | MMLU |

|---|---|---|---|---|---|

| Gemini Nano 2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| Phi-2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

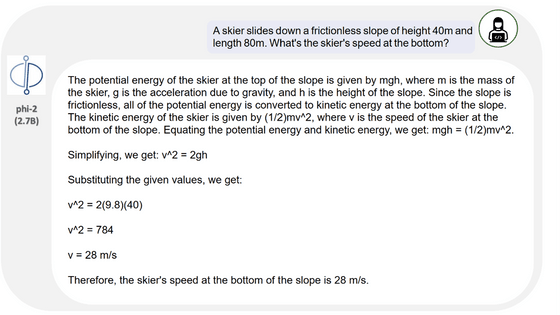

ベンチマーク通り、単純な物理問題であれば難なく解ける模様。平方根の計算についてもほぼ正確に行うことができました。

なお、Phi-2は研究用途のみのライセンスで提供されているため、商用利用は不可能となっている点に注意が必要です。

・関連記事

無料で商用利用可能な大規模言語モデル「Mixtral 8x7B」が登場、低い推論コストでGPT-3.5と同等以上の性能を発揮可能 - GIGAZINE

わずか4GBの実行ファイル1つで大規模言語モデルによるAIを超お手軽に配布・実行できる仕組み「llamafile」をWindowsとLinuxで簡単に実行してみる方法 - GIGAZINE

大規模言語モデルの構造を3Dで視覚化してどんな計算が行われているのかを見やすく表示してくれるサイト「LLM Visualization」 - GIGAZINE

文字・音声・画像を同時に処理して人間以上に自然なやりとりができるGPT-4を超える性能のマルチモーダルAI「Gemini」がリリースされる - GIGAZINE

ChatGPTのような高性能言語モデルを生み出した技術はどんな仕組みなのか?をAI企業のエンジニアが多数の図解でゼロから解説 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1d_ts

You can read the machine translated English article Microsoft releases small language model ….