画像や文章の生成などを行う「ジェネレーティブAI」はなぜ急に発展したのか?

文章(プロンプト)を入力するだけで高精度な画像を生成できる「Stable Diffusion」や対話形式で高精度な文章を作成する「ChatGPT」などのいわゆる「ジェネレーティブAI」がしばしば話題になっています。近年急速に発展したように見えるジェネレーティブAIはどのような仕組みで、なぜ急速に広まっているのか、投資家・起業家のハオミャオ・ファン氏が解説しています。

I got interested in how Generative AI actually works, and where the tech came from, so I wrote an article about it. Tl;dr - we are at another of those inflection points where model+data+compute come together to make an ML revolution.https://t.co/JzKSJY51DC

— Haomiao Huang (@haomiaoh)

The generative AI revolution has begun—how did we get here? | Ars Technica

https://arstechnica.com/gadgets/2023/01/the-generative-ai-revolution-has-begun-how-did-we-get-here/

人工知能(AI)を動かすコンピューターは「集積回路上のトランジスタ数が1.5年ごとに2倍になる」という傾向を指したムーアの法則に従って進歩する一方で、NVIDIAの元エンジニアは「実際にはムーアの法則の5倍から100倍のペースでAIは進歩しています」と指摘するほど、驚異的なペースで発展しています。

人工知能はムーアの法則の何十倍も早いペースで成長している - GIGAZINE

そのようなAIの発展の中で、近年では特に画像生成AIや文章・プログラム生成AIなどのジェネレーティブAIが数多く話題に挙がっています。ファン氏は、研究分野にとどまらず実用的なツールとしてジェネレーティブAIが急速に広まった要因として、大規模言語モデル(LLM)の重要性を指摘しています。LLMは「基礎モデル」と呼ばれるほど非常に柔軟で適応性があり、AIシステムの商用化へのブレイクスルーとして機能しました。

その基礎モデルがどこから生まれたかをさらにさかのぼると、ディープラーニングの発展による爆発的なAIの広がりと、回帰型ニューラルネットワーク(RNN)や長・短期記憶(LSTM)などのモデルでデータの処理や分析をしていたことに端を発します。プログラミング言語としてのトレーニングから、自然言語処理(NLP)を用いた「コードではなく言語を理解」する学習法に推移していく段階でRNNやLSTMが用いられていましたが、近年まで「言語の処理では単語の順序が重要な違いを生む」点や、「適切なトレーニングデータを取得するのが難しい」という点で、長い文章の処理を行えなかったとファン氏は説明しています。

そこで突破口となったのがGoogleの「Transformer」で、RNNよりも言語理解タスクに秀でたニューラルネットワークアーキテクチャとして質の高い翻訳に成功しました。翻訳には言語ごとの語順が重要で、それがTransformerには当然に組み込まれていたため、Transformerが用いた「位置エンコーディング」「マルチヘッドアテンション」という処理法が言語処理のブレイクスルーとして機能したそうです。

より高い品質の翻訳を実現するGoogleの「Transformer」がRNNやCNNをしのぐレベルに - GIGAZINE

ファン氏はTransformerが起こしたブレイクスルーについて、「言語モデルにおける大きな転換点は、翻訳のために作られた驚くべきモデルを利用する事で、言語処理タスクが抱えていた問題を翻訳の問題に変換する方法を見つけ出したことです」と表現しています。

OpenAI は翻訳モデルを基軸にしたアプローチを推し進め、2019年にあまりにも高度な文章が作成できることから「危険すぎる」とすら言われた文章生成ツール「GPT-2」を公開しました。GPT-2は驚くほどリアルな人間らしいテキストを生成できましたが、テキストが長くなるにつれてシステムがすぐに壊れてしまったり、プロンプトがあまり柔軟ではなかったりと、いくつかの問題を抱えていました。

「危険すぎる」と言われたAIの自動文章作成ツール「GPT-2」のモデルが新たに公開へ - GIGAZINE

by duallogic

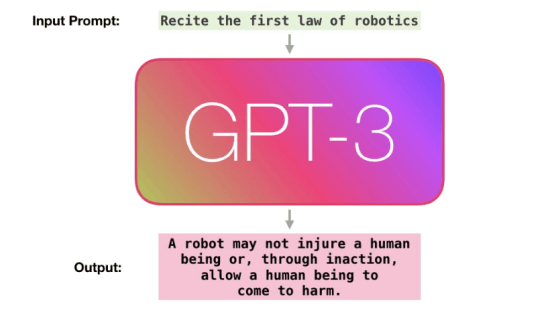

そして2020年にはGPT-2の後継である「GPT-3」が登場しましたが、ファン氏は「GPT-2からGPT-3への革新が、最大のブレイクスルーです」と指摘しています。GPT-2には約15億のパラメータがあるとされていましたが、GPT-3は100倍以上の約1750億のパラメータを持っており、人間の文章とほとんど見分けが付かないブログやニュースを一貫性のある文章で書くことができると話題になりました。

さらにGPT-3が優れていた点は、膨大なモデルを使用することで、平易な文章で「次の段落を要約してください」「この段落をヘミングウェイの文体で書き直してください」というように命令するだけで、個別のトレーニングが必要なく新しい動作を学習することにありました。そして、このモデルはすぐに言語処理の分野を超えて、他の分野に広がっていきます。

原初のコンピュータービジョンの研究では、例えば「人の顔」を認識するために、実際に私たちが行うような「目や口、鼻を見て、その形や配置パターンを認識する」というプロセスを再現しようと試みることで、人の顔を認識していました。ディープラーニングはこれを大きく変え、手動で画像の特徴をパラメータとして操作する代わりに、AIモデルが特徴を学習して「人の顔」「車」「動物」などのオブジェクトに該当するか判断できるようにしました。ディープラーニングは大規模なデータを処理できる強力なモデルでしたが、「ネコの特徴と一致しているからネコの画像」とシンプルな定型句としての判断ができるものにとどまり、「画像の特徴」と「言語」の間の翻訳方法を正しく理解できていなかったとファン氏は述べています。

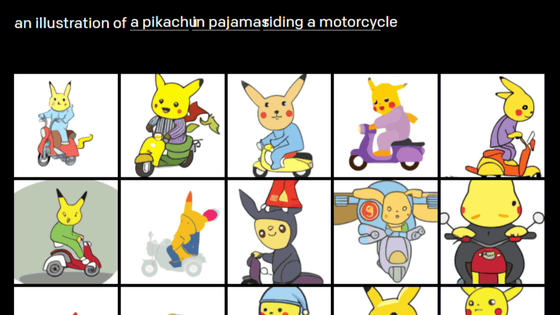

Transformerはある言語から別の言語に変換する翻訳モデルとして発明されましたが、画像など他のパラメータを言語と同様の方法で表現する方法を理解できれば、そこにあるルールを見つけ出して別の言語にマッピングするTransformerの能力を訓練して、翻訳を行うことができます。こうして「画像から特徴を抽出し、潜在表現と呼ばれる低次元表現に圧縮し、細かいポイントを軸として座標に表す」といったアプローチが可能になりました。OpenAIは「画像の言語」とそれを翻訳するツール(Transformer)に加えて、画像とテキストを変換するための膨大なデータセットを構築することで、GPT-3のパラメータを利用して自然言語処理と画像生成を組み合わせたAI「DALL・E」を生み出しました。

「バイクに乗るピカチュウ」「アボカドの椅子」など言葉から自動でイラストや写真を生成するAI「DALL・E」 - GIGAZINE

まとめると、画像生成AIは「画像を表現するための言語を学習するディープラーニング」と「テキストの世界と画像の世界を切替える翻訳機能」という2つのAIの進歩が組み合わせとして発展しました。そして、これらのAIモデルはデータ依存性、予測不能性、確率的であるという特徴もありますが、かなり強力で柔軟性があることで、ほぼ普遍的でさまざまなケースに適用できるため、日常的な使用に広がったとファン氏は説明しています。

ファン氏は最後に、「私たちが言える唯一のことはおそらく、これらのAIツールがより強力になり、使いやすくなり、安価になるということです。私たちは、ムーアの法則と同じくらい重要な革命の初期段階にあり、私は今後何が起こるかについて興奮しているのと同時に、何が起こるか恐れています」とAIの発展への期待と不安について述べています。

・関連記事

人工知能はムーアの法則の何十倍も早いペースで成長している - GIGAZINE

ChatGPTやStable Diffusionを生み出した「機械学習ソフトウェア」の10年間の流れを専門家が解説 - GIGAZINE

AI戦争に勝利する方法とは? - GIGAZINE

より高い品質の翻訳を実現するGoogleの「Transformer」がRNNやCNNをしのぐレベルに - GIGAZINE

「危険すぎる」と言われたAIの自動文章作成ツール「GPT-2」のモデルが新たに公開へ - GIGAZINE

あまりに高精度のテキストを作り出してしまうため「危険すぎる」と問題視された文章生成言語モデルの最新版「GPT-3」公開 - GIGAZINE

自然なブログを書いてしまうほど超高精度な言語モデル「GPT-3」はどのように言葉を紡いでいるのか? - GIGAZINE

「バイクに乗るピカチュウ」「アボカドの椅子」など言葉から自動でイラストや写真を生成するAI「DALL・E」 - GIGAZINE

・関連コンテンツ