「ハサミを箱に入れる」「布を折る」など言葉で指示した多様なタスクをロボットアームで遂行するAIが登場

ロボットアームで特定のオブジェクトを正確に操作するだけでなく、自然言語でオブジェクトの抽象的な概念を理解する機械学習フレームワーク「CLIPort」を、半導体メーカーでありAI技術の開発も行うNVIDIAとワシントン大学の研究チームが発表しました。

CLIPort

https://cliport.github.io/

近年の研究から、エンドツーエンドのネットワークによって、AIが空間的な推論を必要とする器用な操作スキルを習得できることが示されています。しかし、従来の方法では一度習得したスキルを一般化して新たなスキルに適用したり、同じ概念を別のスキルに転用できないことが多いと研究チームは指摘。また、大規模なデータトレーニングによって、視覚と言語の一般化可能な意味学習が大幅な進歩を遂げましたが、これは正確な操作に必要な空間的理解を欠いているとのこと。

研究チームは視覚ベースの操作を実現するために、空間論的な正確さを持つTransporter Networksアーキテクチャと、言語に基づいて広範な画像の意味を理解するCLIPアーキテクチャを組み合わせた「CLIPort」というフレームワークを開発しました。

なお、ロボットアームを操作するために2つのアーキテクチャを組み合わせるという発想は、視覚皮質に到達した視覚情報が、対象の色や形の情報処理を行う経路(腹側経路)と、位置や運動の情報処理を行う経路(腹側経路)の2つで処理されているという「Two-streams hypothesis(2つの視覚経路仮説)」に触発されたものだそうです。

CLIPortはオブジェクトの向きや状態、インスタンスの分割、構文構造といった明示的な表現をしなくとも、自然言語によって指示されたさまざまなタスクを実行できるとのこと。実際に研究チームが行ったCLIPortのデモンストレーションは、以下のムービーで確認できます。

CLIPort (CoRL 2021) - YouTube

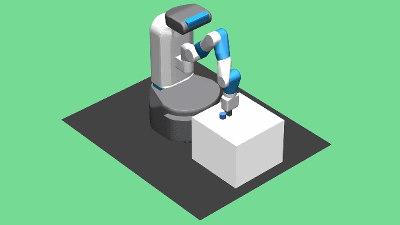

研究チームは、このロボットアームでさまざまなタスクを実行することでCLIPortのデモンストレーションを行いました。

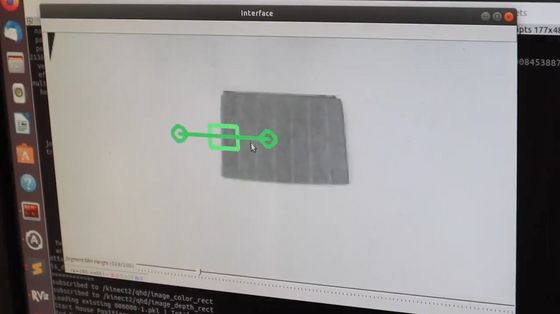

まずは人の手でロボットアームを操作し……

個別のタスクについて訓練します。

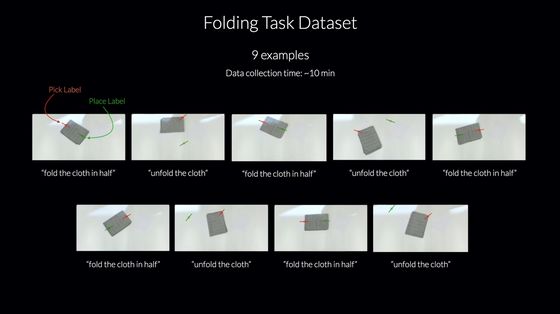

「布を折る/広げる」というタスクについては、合計で9個のデータセットで訓練したとのこと。

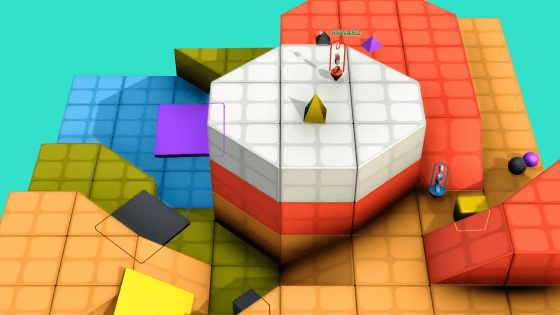

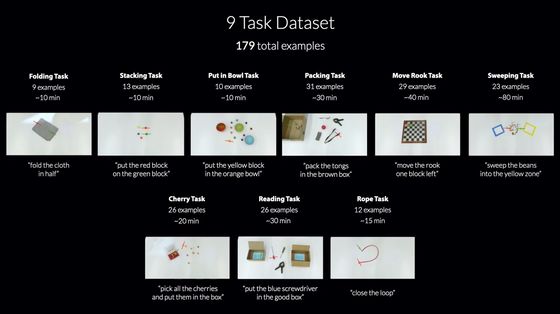

研究チームは今回のデモンストレーションで、「布を折る/開く」「ブロックを指示した場所に配置する」「指示した物体をボウルの中に入れる」「指示した物体を箱に入れる」「チェスのコマを動かす」「散らばった物体を掃き集める」「サクランボを拾って箱に入れる」「箱の中に入った文字を読み取り、物体を指示した箱に入れる」「ロープを指示した通りに動かす」など合計で9つのタスクを用意しましたが、データセットの総数はわずか179個だったと述べています。

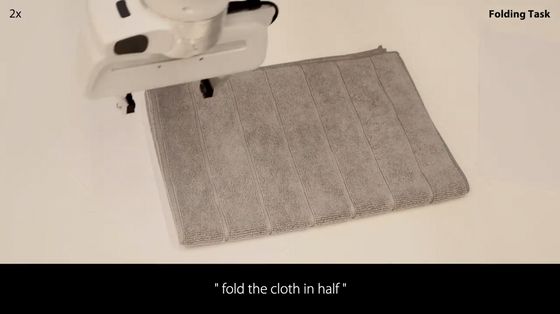

「fold the cloth in half(布を半分に折れ)」と指示を出すと、ロボットアームが布の端をつかみ……

半分に折りました。

「unfold the cloth(布を広げろ)」と指示すると、さっきとは逆に畳まれていた布を広げました。

今度は色とりどりのブロックをランダムで配置し、「put the orange block on the blue block(オレンジのブロックを青いブロックの上にのせろ)」と指示します。

すると、ロボットアームは正確にオレンジ色のブロックを見つけ出し、青いブロックの上にのせることができました。

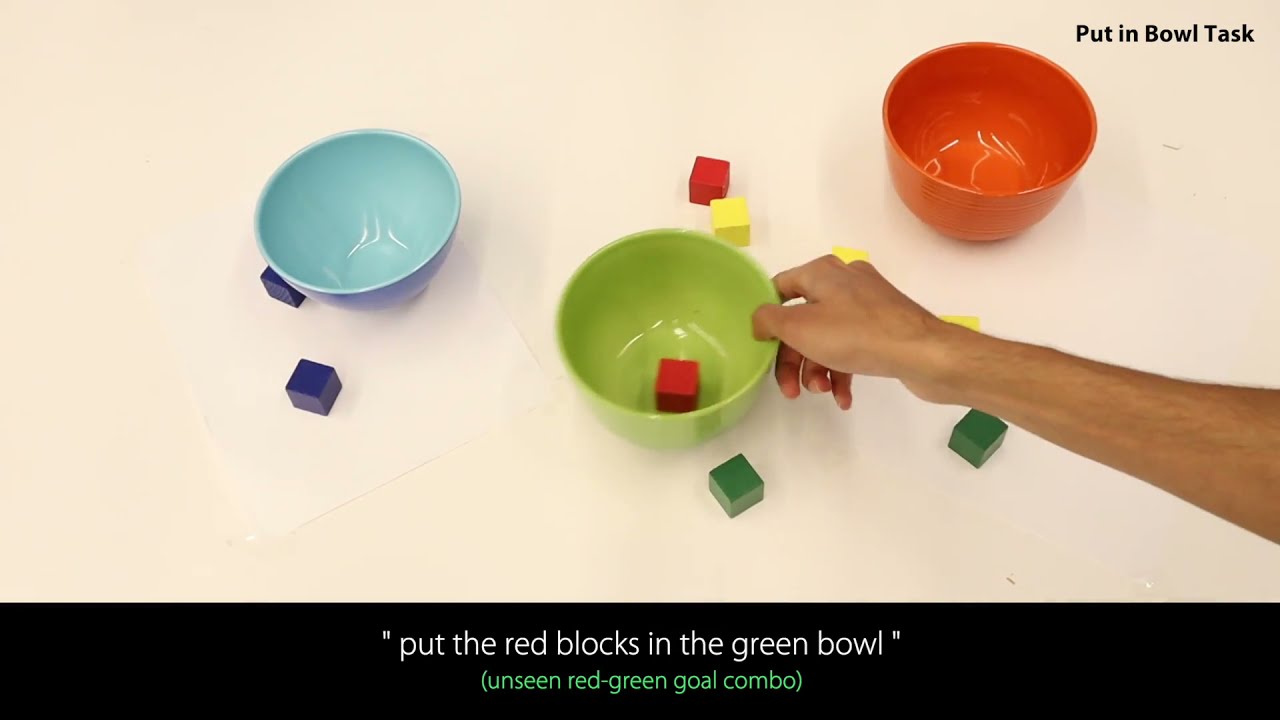

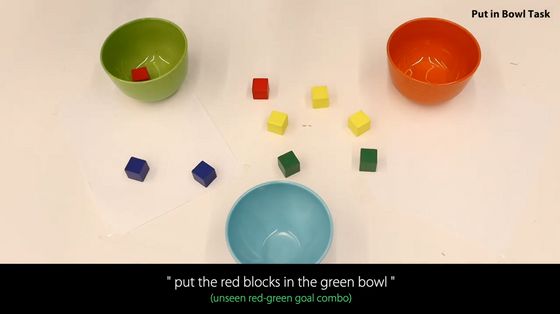

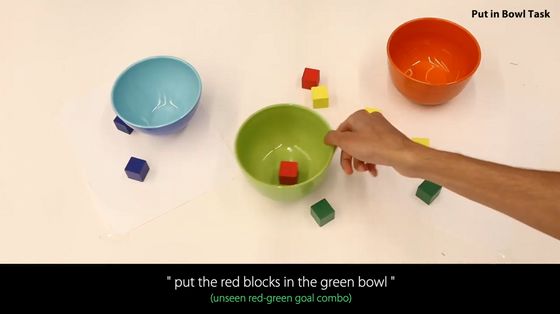

また、「put the red blocks in the green bowl(赤いブロックを緑色のボウルに入れろ)」という指示の途中で……

ボウルの位置を動かして妨害するテストも行われました。

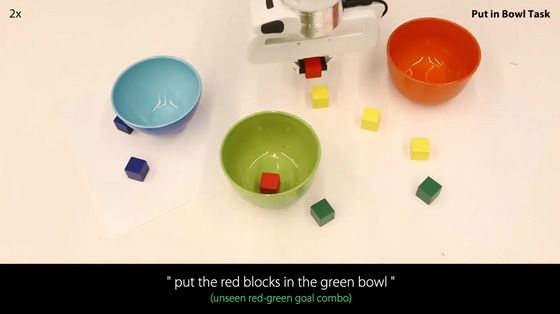

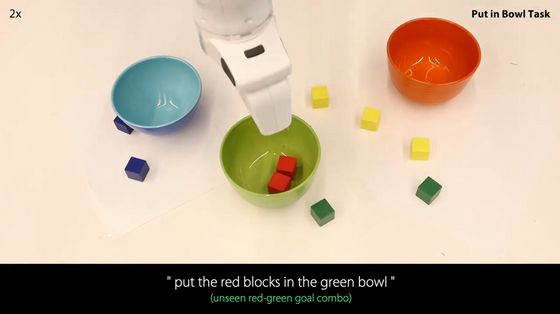

ロボットアームが赤いブロックをつかむと……

1回目からボウルの位置が移動していたにもかかわらず、正確に緑色のボウルにブロックを入れることに成功しました。

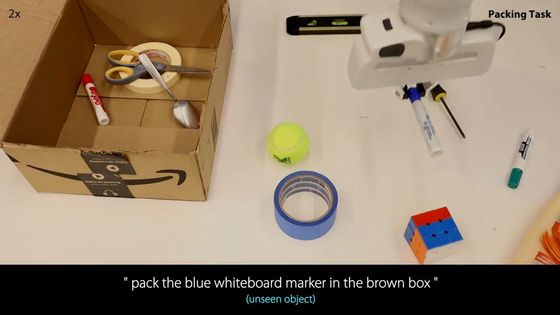

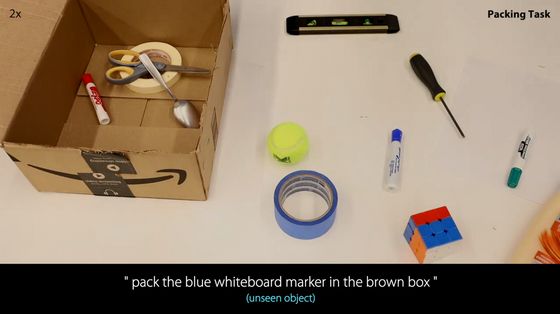

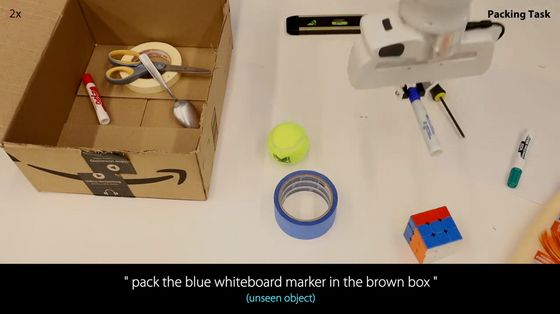

また、CLIPortが物体を認識するために使用する画像認識アルゴリズムのCLIPは、事前にトレーニングしていた物体だけでなく初めて見る物体を識別することも可能です。指示した物体を箱に入れるテストで、これまでCLIPが見たことがない「青いホワイトボードマーカー」を入れるように指示したところ……

ロボットアームは正確に青いホワイトボードマーカーをつかみました。

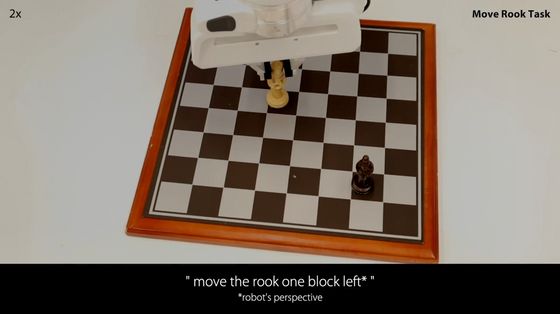

CLIPortはその他にも、チェスのコマを指示通りに動かしたり……

特定の物体を指定された箱に入れたり

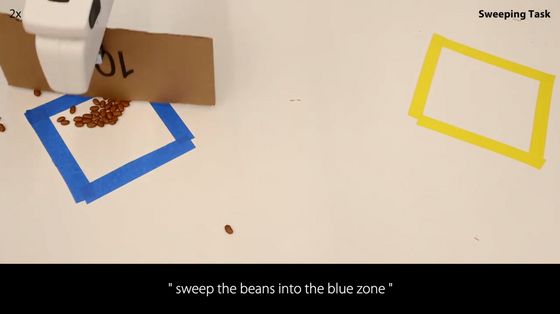

コーヒー豆を掃き集めたりと、さまざまなタスクを完了できたとのことです。

・関連記事

Googleが機械学習を用いて「物を投げること」を理解するロボット「TossingBot」を開発 - GIGAZINE

まるで人間の手のような器用過ぎる動作を見せつけるロボットアーム「Dactyl」 - GIGAZINE

ドローンが自機めがけて飛んでくるボールを瞬時に自動回避できる新技術が開発される - GIGAZINE

自画像を描くAI搭載ロボットの作品がついに美術館で展示されることに - GIGAZINE

「ルービックキューブが解ける」高機能なロボットハンド駆動システムの開発が進んでいる - GIGAZINE

ロボットに仮想空間で「現実世界とは何か」を学ばせることで学習を高速化する「Habitat 2.0」をFacebookが発表 - GIGAZINE

人間の指示なしにロボットが自分で動いて学習できるアルゴリズム「Grasp2Vec」をGoogleが発表 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ハードウェア, サイエンス, 動画, Posted by log1h_ik

You can read the machine translated English article Introducing AI that uses a robot arm to ….