OpenがAIチップメーカー「Cerebras」と1.5兆円規模の複数年契約を締結、Cerebrasの低遅延推論システム導入でリアルタイムAIを拡張

現地時間の2026年1月14日、OpenAIがCerebrasとの提携を発表しました。CerebrasはAIモデルからの長時間出力を高速化するため、専用のAIシステムを構築している企業です。

OpenAI partners with Cerebras | OpenAI

https://openai.com/index/cerebras-partnership/

OpenAI Partners with Cerebras to Bring High-Speed Inference to the Mainstream

https://www.cerebras.ai/blog/openai-partners-with-cerebras-to-bring-high-speed-inference-to-the-mainstream

OpenAI signs deal, worth $10B, for compute from Cerebras | TechCrunch

https://techcrunch.com/2026/01/14/openai-signs-deal-reportedly-worth-10-billion-for-compute-from-cerebras/

OpenAIとCerebrasの提携により、OpenAIのコンピューティングソリューションにCerebrasのAIシステムを統合することとなります。これにより、「AIの応答速度が大幅に向上することになる」とOpenAIは説明しました。

テクノロジーメディアのTechCrunchが情報筋から得た情報によると、OpenAIとCerebrasの取引規模は100億ドル(約1兆5800億円)を超えるそうです。

OpenAIは「Cerebrasの低レイテンシシステムを段階的に推論スタックに統合することで、ワークロード全体に拡大していく予定」と説明。具体的には、「750MWの超低遅延AIコンピューティングをOpenAIのプラットフォームに追加する予定」と説明しています。

OpenAIとCerebrasは2017年以来、頻繁に会合を開き、研究成果や初期段階の取り組みを共有し、「AIモデルのスケールにはハードウェアアーキテクチャが融合しなければいけない」という共通の信念を共有してきたそうです。今回の提携は、まさにこれを実現するためのものというわけ。

OpenAIのサチン・カッティ氏は、「OpenAIのコンピューティング戦略は、適切なシステムを適切なワークロードにマッチングさせ、回復力の高いポートフォリオを構築することです。Cerebrasは、当社のプラットフォームに専用の低レイテンシ推論ソリューションを追加します。これは、より高速な応答、より自然なインタラクション、そしてより多くの人々にリアルタイムAIを拡張するための強固な基盤となります」と語りました。

Cerebrasの共同創業者でありCEOでもあるアンドリュー・フェルドマン氏は、「OpenAIとの提携により、世界をリードするAIモデルを世界最速のAIプロセッサに搭載できることを大変嬉しく思います。ブロードバンドがインターネットを変革したように、リアルタイム推論はAIを変革し、AIモデルの構築とインタラクションに全く新しい方法をもたらすでしょう」と語っています。

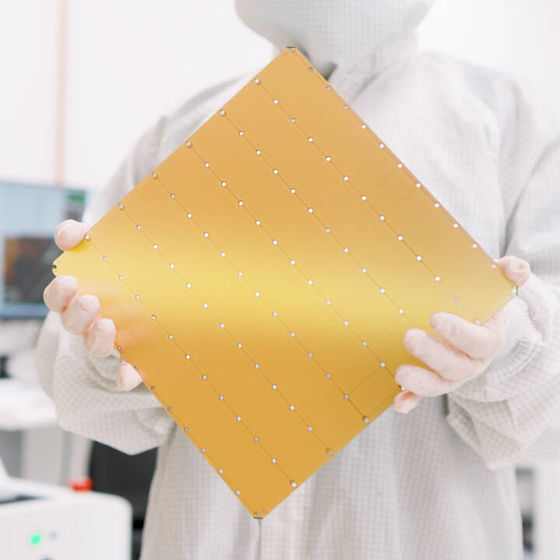

Cerebrasによると、同社の低レイテンシ推論システム上で動作する大規模言語モデル(LLM)は、GPUベースのシステム上で動作するLLMと比べて応答速度が最大15倍も高速になるそうです。これは消費者にとってエンゲージメントの向上と斬新なアプリケーション活用につながる大きな利点であると、Cerebrasは説明しています。

なお、Cerebrasの低レイテンシ推論ソリューションについて、OpenAIは「2028年までに複数回に分けて稼働する予定」と説明。Cerebrasは「Cerebrasの750MWのウエハスケールシステムを導入する複数年契約を締結しました。この導入は2026年から段階的に展開され、世界最大規模の高速AI推論システムの導入となります」と説明しました。

・関連記事

半導体チップのグレードはどのように決まり、どうすれば高グレードの製品の生産量を高められるのか - GIGAZINE

「地球上で最速のAIチップ」をうたうWSE-3の開発元であるAIチップスタートアップの「Cerebras」が上場へ、OpenAIのサム・アルトマンも出資 - GIGAZINE

CerebrasがNVIDIA H100の22倍高速な爆速AI推論サービスを発表、デモページも公開されたので使ってみた - GIGAZINE

4兆個のトランジスタを搭載した世界最速のAIチップ「WSE-3」をCerebrasが発表 - GIGAZINE

1億6300万のコアで120兆個のAIパラメーターをトレーニング可能なモンスターマシン「Cerebras CS-2」が発表される - GIGAZINE

・関連コンテンツ

in AI, Posted by logu_ii

You can read the machine translated English article Open signs multi-year contract with AI c….