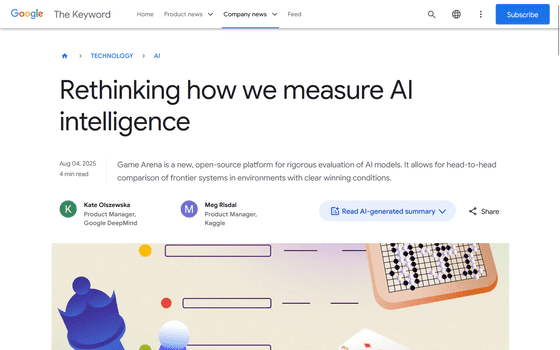

AIのゲーム性能を測定するベンチマークプラットフォーム「Game Arena」をGoogleが公開

異なる大規模言語モデル(LLM)の性能について、ゲームを通じて測定するためのプラットフォーム「Game Arena」が公開されました。ゲームの解き方を推論させることで、AIの思考プロセスの一端がうかがえると期待されています。

Kaggle Game Arena evaluates AI models through games

https://blog.google/technology/ai/kaggle-game-arena/

AIの性能は日々上がり続けているため、その性能を定量的に測定するためのベンチマークテストも常に進化を求められています。進化したAIが満点を取るようなベンチマークテストは、テストとしての意味をなさなくなってしまうためです。

そこで、Googleは新たに「Game Arena」というベンチマークプラットフォームを開発しました。さまざまなゲームをベンチマークテストとして利用するためのプラットフォームで、各種LLMがこのプラットフォームを通じてゲームをプレイすることで、その能力を測定することができるとされています。

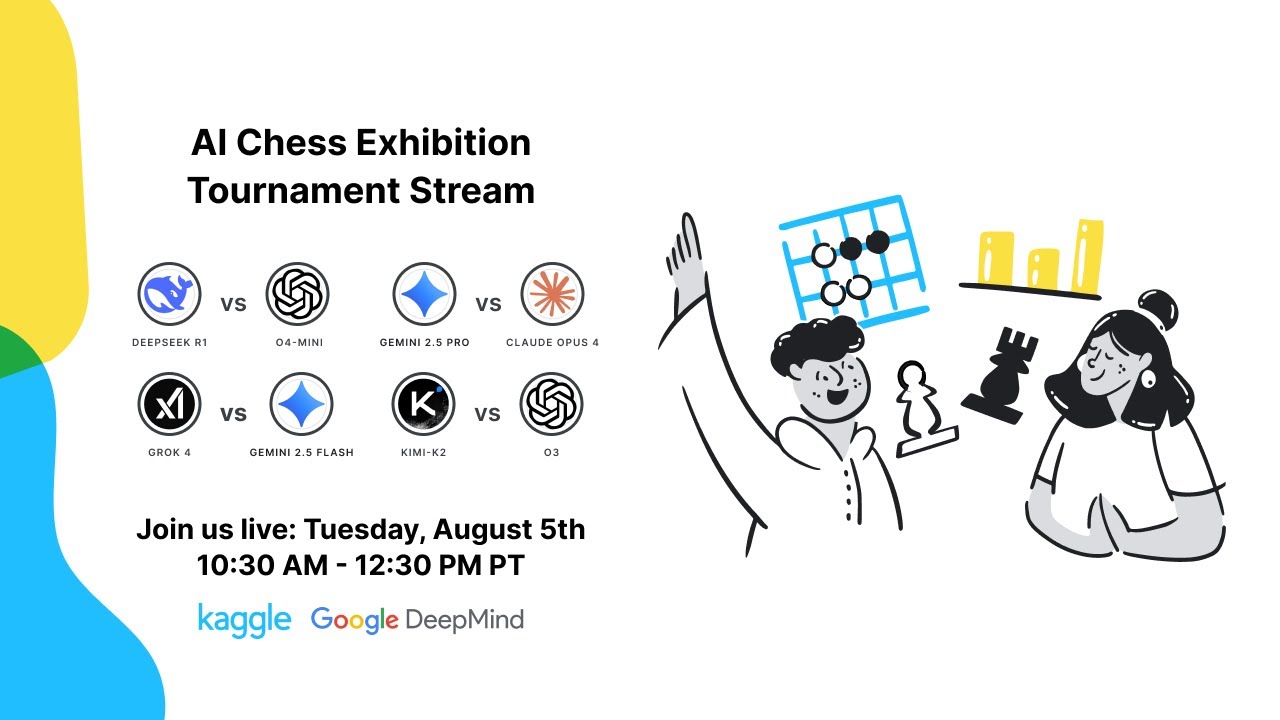

初期のデモンストレーションとして、日本時間の8月6日(水)2時30分からチェスのエキシビションマッチがYouTubeでライブ配信される予定です。これはGame Arenaを通じてLLM同士でチェスの対戦をさせるもので、DeepSeek-R1、o4-mini、Gemini 2.5 Pro、Claude Opus 4など、複数の推論モデルが参加する予定です。

AI Chess Exhibition Tournament August 5th - YouTube

ゲームをプレイさせ、その戦略、解法などを定量的に測定することで性能を可視化し、さらに「推論」の内容を出力させることで、AIがどのようなプロセスで処理をしているのかをうかがえるのではないかと期待されています。

Game Arenaは、透明性を確保するため、ゲームハブと呼ばれるフレームワークおよびゲーム環境はすべてオープンソース化されています。

Googleは「モデルを競争的な環境でテストすることで、推論の明確な基準を確立し、追跡できます。モデルが厳しい競争に直面するにつれて難易度も上昇する拡大可能なベンチマークを構築することが目標です。時間とともに、これはAlphaGoの『Move 37』のように人間を困惑させる新たな戦略を生み出す可能性があります。ゲーム中で計画し、適応し、プレッシャー下で推論する能力は、科学やビジネスにおける複雑な課題解決に必要な思考プロセスと類似しています。今後、定期的にさらなるトーナメントを開催する計画です」と述べました。

・関連記事

月締めの会計業務をAIモデルにやらせてみるベンチマーク「AccountingBench」の結果とは? - GIGAZINE

AIベンチマーク「自転車に乗ったペリカンを描く」をLLama 3.3 70BやGPT 4.1にやってもらうとこうなる - GIGAZINE

OpenAIがAIのウェブ検索能力を測定する高難度ベンチマーク「BrowseComp」を発表 - GIGAZINE

Googleが「AIのサイバー犯罪能力」を測定するベンチマークを開発 - GIGAZINE

OpenAIがAIの論文理解&再現能力を評価するベンチマーク「PaperBench」を発表、人間とAIのどちらが研究開発力が高いのか? - GIGAZINE

OpenAIがAIベンチマーク「SWE-Lancer」を公開、フリーランスエンジニアに100万ドルで依頼するレベルのタスクをこなせるか測定 - GIGAZINE

60以上の大規模言語モデルに19種類の質問を行うベンチマークテストの結果公開 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Google releases 'Game Arena,' a benchmar….