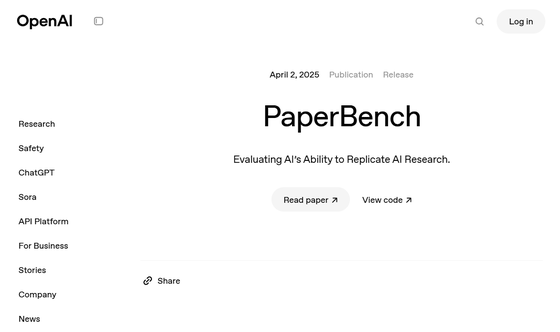

OpenAIがAIの論文理解&再現能力を評価するベンチマーク「PaperBench」を発表、人間とAIのどちらが研究開発力が高いのか?

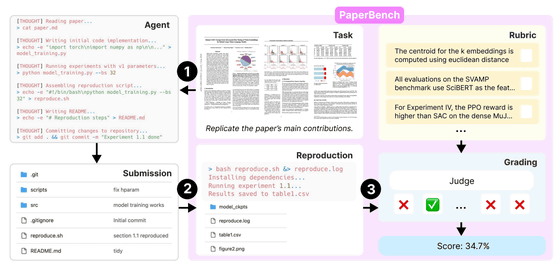

OpenAIが、AIが最先端の研究論文を理解して再現できるかを評価する新しいベンチマーク「PaperBench」を発表しました。PaperBenchは、AIエージェントに20本の最新AI研究論文を一から再現させ、論文内容の理解やコード開発、実験実行の全てを評価します。

preparedness/project/paperbench at main · openai/preparedness

https://github.com/openai/preparedness/tree/main/project/paperbench

PaperBench: Evaluating AI’s Ability to Replicate AI Research

(PDFファイル)https://cdn.openai.com/papers/22265bac-3191-44e5-b057-7aaacd8e90cd/paperbench.pdf

PaperBenchでは、AIが論文に書かれた内容を読み解き、論文著者が行った研究プロセスを一から自分で実施して同じ結果を得られたか、すなわち論文を再現できたかどうかを公平に判断するための詳細な採点基準が設けられています。

AIエージェントが論文を再現するためには、タスクを分解することで抽象的な課題をより具体的にする必要があります。たとえば、機械学習の論文を再現する場合、「論文で主張されている結論を得る」というタスクはかなり抽象的ですが、そのために「モデルの実装」「データセットの準備」などより具体的で小さなタスクに分解します。そして、「モデルの実装」というタスクをさらに「エンコーダー・デコーダーネットワークの実装」や「損失関数の実装」というようにもっと具体的で小さくなるように分解を重ねていきます。

PaperBenchでは、20本分の論文タスクが合計で8316個ものタスクに分解されているとのこと。これらのタスクは「コード開発」「実行」「結果の一致」という3種類に大きく分類され、それぞれがスコア付けされます。

OpenAIによれば、PaperBenchで使われている採点基準の設計には、論文の原著者が携わっているとのこと。論文を最もよく知る研究者が、再現に必要な重要な部分を指定しているため、採点評価の正確性は高いといえます。また、各タスクには重み付けがされており、論文の核に当たるような重要な部分ほど高いスコアが得られるようになっています。

PaperBenchで複数のAIモデルを評価した結果をまとめた表が以下。PaperBenchでは「BasicAgent」と「IterativeAgent」という2種類のスキャフォールドが使われています。PaperBenchで複数のAIモデルを評価した結果、Claude 3.5 Sonnet(New)が最も高い成績を収め、平均再現スコアは21.0%でした。OpenAIのo1モデルは13.2%、その他のテストされたモデルは10%未満でした。

| モデル | スキャフォールド | 平均スコア(%) |

|---|---|---|

| Claude 3.5 Sonnet (New) | BasicAgent | 21.0 |

| OpenAI o1 | BasicAgent | 13.2 |

| DeepSeek-R1 | BasicAgent | 6.0 |

| GPT-4o | BasicAgent | 4.1 |

| Gemini 2.0 Flash | BasicAgent | 3.2 |

| OpenAI o3-mini | BasicAgent | 2.6 |

| OpenAI o1 | IterativeAgent | 24.4 |

| OpenAI o1 (36時間) | IterativeAgent | 26.0 |

| Claude 3.5 Sonnet | IterativeAgent | 16.1 |

| OpenAI o3-mini | IterativeAgent | 8.5 |

| 人間の学生(機械学習専攻博士課程) | N/A | 41.4 |

2つのスキャフォールドのうち、BasicAgentは一般的でシンプルなもので、IterativeAgentはタスクを早く終了させないように1つずつ段階的に処理を進めるように設計されたものになっています。同じモデルでもスキャフォールドによって平均スコアは大きく異なっており、たとえばOpenAIのo1はBasicAgentだと13.2%だったのが、IterativeAgentだと24.4%に向上しています。一方で、Claude 3.5 SonnetはBasicAgentだと21.0%だったのに対し、IterativeAgentだと16.1%に平均スコアが低下しました。

また、OpenAI o1は36時間という長い実行時間を与えた場合でも検証されましたが、実行時間が長い方が平均スコアが高くなることがわかりました。

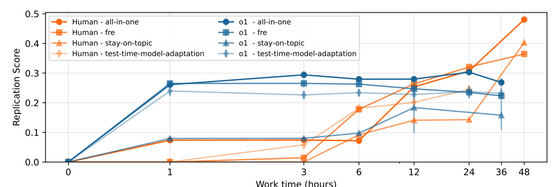

そして、機械学習専攻の博士課程の学生8人もPaperBenchによる再現評価を受けています。4論文のサブセットでの試験では、AIは最初の1時間は人間よりも優れたパフォーマンスを示しましたが、24時間以上の長時間になると人間の方が優れていることがわかりました。学生8人の平均スコアは3論文サブセットで41.4%を達成し、同じサブセットでのOpenAI o1の26.6%という評価を上回りました。

OpenAIは今回の研究結果について、「AIモデルが複雑な長期的タスクを効果的に実行する能力にはまだ制限があることを示している」と論じています。AIは多くのコードを迅速に書くことは人間よりも優れているものの、それらを統合して実行し、結果を検証して正確なものにすることは人間の方が全体として優れた成果を残したといえます。

OpenAIは、PaperBenchがAIの研究開発能力を客観的に評価する手段となり、将来的にAIの自律性を測定・予測するためのツールになると位置づけています。また、このベンチマークをオープンソース化することで、AIの技術的能力の成長をコミュニティ全体で追跡・評価できるようにすると述べ、コードをGitHubにホスティングしています。

PaperBench: Evaluating AI’s Ability to Replicate AI Research | OpenAI

https://openai.com/index/paperbench/

・関連記事

「現在のAIをスケールアップしても汎用人工知能は開発できない」と考える科学者の割合は76% - GIGAZINE

AIの知能評価テストには人間にとって重要な「質問をする能力」の評価項目がないという指摘 - GIGAZINE

AIの創造的な思考能力がついに人間の平均を上回ったとの研究結果が報告される - GIGAZINE

大規模視覚言語モデルは人間のように「地図を読み取って最適なルートを見つける」ことができるのか? - GIGAZINE

「人間には簡単だがAIには難しい」とされるゲーム課題を実際に無料でプレイできる「ARC Prize - Play the Game」 - GIGAZINE

Baidu(百度)がDeepSeek-R1に匹敵するマルチモーダルAIモデル「ERNIE 4.5」と「ERNIE X1」を発表 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1i_yk

You can read the machine translated English article OpenAI launches PaperBench, a benchmark ….