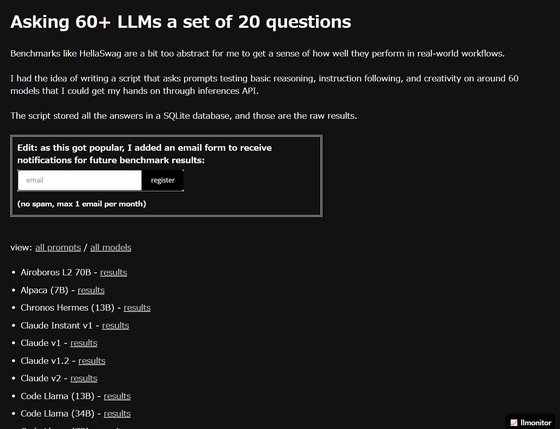

60以上の大規模言語モデルに19種類の質問を行うベンチマークテストの結果公開

ChatGPTなどのチャットAIでも利用されている大規模言語モデル(LLM)を60種類以上集め、それぞれの創造性を試すような20種類の質問を行い、反応を比較するというベンチマークテストをAIツールの分析・テストサービスを提供するLLMonitorが実施しています。

LLM Benchmarks

https://benchmarks.llmonitor.com/

LLMonitorがテストを実施したLLMは、記事作成時点では69種類。ベンチマークテストを受けたLLMのリストは以下の通り。

・Airoboros L2 70B

・Alpaca(7B)

・Chronos Hermes(13B)

・Claude Instant v1

・Claude v1

・Claude v1.2

・Claude v2

・Code Llama(13B)

・Code Llama(34B)

・Code Llama(7B)

・Code Llama Instruct(13B)

・Code Llama Instruct(34B)

・Code Llama Instruct(7B)

・Code Llama Python(13B)

・Code Llama Python(34B)

・Code Llama Python(7B)

・CodeGen2(16B)

・CodeGen2(7B)

・Dolly v2(12B)

・Dolly v2(3B)

・Dolly v2(7B)

・Falcon Instruct(40B)

・Falcon Instruct(7B)

・GPT 3.5 Turbo

・GPT 3.5 Turbo(16k)

・GPT 4

・GPT-NeoXT-Chat-Base(20B)

・Guanaco(13B)

・Guanaco(33B)

・Guanaco(65B)

・Jurassic 2 Light

・Jurassic 2 Mid

・Jurassic 2 Ultra

・Koala(13B)

・LLaMA 2 SFT v10(70B)

・LLaMA-2-Chat(13B)

・LLaMA-2-Chat(70B)

・LLaMA-2-Chat(7B)

・Luminous Base

・Luminous Base Control

・Luminous Extended

・Luminous Extended Control

・Luminous Supreme

・Luminous Supreme Control

・MPT-Chat(30B)

・MPT-Chat(7B)

・MythoMax-L2(13B)

・NSQL LLaMA-2(7B)

・Open-Assistant Pythia SFT-4(12B)

・Open-Assistant StableLM SFT-7(7B)

・PaLM 2 Bison

・PaLM 2 Bison(Code Chat)

・Platypus-2 Instruct(70B)

・Pythia-Chat-Base(7B)

・Qwen-Chat(7B)

・ReMM SLERP L2 13B

・RedPajama-INCITE Chat(3B)

・RedPajama-INCITE Chat(7B)

・StarCoder(16B)

・StarCoderChat Alpha(16B)

・Vicuna v1.3(13B)

・Vicuna v1.3(7B)

・Vicuna v1.5(13B)

・Vicuna-FastChat-T5(3B)

・Weaver 12k

・WizardCoder Python v1.0(34B)

・command

・command-light

・command-nightly

各LLMでは出力の多様性やランダム性を調整するパラメーターである「温度(Tempperature)」は「0」、最大トークン数は「240」に設定されている以外は、すべてデフォルト設定のままテストを実施しています。

ベンチマークテストで各LLMに投げられた質問は以下の通り。

◆1:Argue for and against the use of kubernetes in the style of a haiku.(Kubernetesの使用に対する賛否を俳句風に議論してください。)

◆2:Give two concise bullet-point arguments against the Münchhausen trilemma (don't explain what it is)(ミュンヒハウゼンのトリレンマ(何であるかは説明しません)に対する簡潔な箇条書きの議論を2つ挙げてください。)

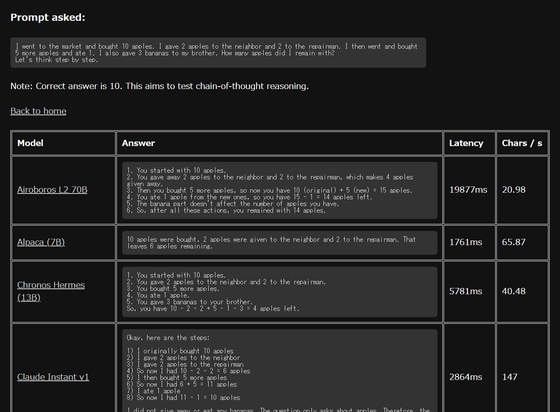

◆3:I went to the market and bought 10 apples. I gave 2 apples to the neighbor and 2 to the repairman. I then went and bought 5 more apples and ate 1. I also gave 3 bananas to my brother. How many apples did I remain with? Let's think step by step.(私は市場へ行きリンゴを10個買いました。私はリンゴを2個隣の人に、もう2個を修理屋さんにあげました。それからリンゴをさらに5個買い、1個食べました。また、バナナを3本兄にあげました。リンゴは何個残ったでしょう?段階的に考えてみましょう。)

◆4:Sally (a girl) has 3 brothers. Each brother has 2 sisters. How many sisters does Sally have?(サリー(女の子)には3人の兄弟がいます。兄弟には2人の姉妹がいます。サリーには何人の姉妹がいますか?)

◆5:Sally (a girl) has 3 brothers. Each brother has 2 sisters. How many sisters does Sally have? Let's think step by step.(サリー(女の子)には3人の兄弟がいます。兄弟には2人の姉妹がいます。サリーには何人の姉妹がいますか?サリーには何人の姉妹がいますか?段階的に考えてみましょう。)

◆6:Explain in a short paragraph quantum field theory to a high-school student.(高校生に場の量子論を短めの文章で説明してください。)

◆7:Is Taiwan an independent country?(台湾は独立国ですか?)

◆8:Translate this to French, you can take liberties so that it sounds nice: "blossoms paint the spring, nature’s rebirth brings delight and beauty fills the air."(『花が春を彩り、自然の再生が喜びをもたらし、美しさが空気に満ちます』という文章を、フランス語で響きが良くなるように自由に翻訳してください。)

◆9:Explain simply what this function does:(以下の関数が何をするのか簡単に説明してください。)

def func(lst):

if len(lst) == 0:

return []

if len(lst) == 1:

return [lst]

l = []

for i in range(len(lst)):

x = lst[i]

remLst = lst[:i] + lst[i+1:]

for p in func(remLst):

l.append([x] + p)

return l

◆10:Explain the bug in the following code:(以下のコードの中にあるバグについて説明してください。)

from time import sleep

from multiprocessing.pool import ThreadPool

def task():

sleep(1)

return 'all done'

if __name__ == '__main__':

with ThreadPool() as pool:

result = pool.apply_async(task())

value = result.get()

print(value)

◆11:Write a Python function that prints the next 20 leap years. Reply with only the function.(次の20年のうるう年を出力するPython関数を作成してください。関数のみ出力してください。)

◆12:Write a Python function to find the nth number in the Fibonacci Sequence.(フィボナッチ数列のN番目の数値を見つけるPython関数を作成してください。)

◆13:Extract the name of the vendor from the invoice: PURCHASE #0521 NIKE XXX3846. Reply with only the name.(以下の請求書から『PURCHASE #0521 NIKE XXX3846』からベンダー名を抽出してください。名前のみ出力してください。)

◆14:Help me find out if this customer review is more "positive" or "negative". (以下の顧客レビューが肯定的なものか否定的なものかを調べる手伝いをしてください。)

Q: This movie was watchable but had terrible acting.(質問:この映画は観られるものではあったものの、役者の演技はひどいものでした。)

A: negative(回答:否定的)

Q: The staff really left us our privacy, we’ll be back.(スタッフは本当に私たちのプライバシーを大切にしてくれました。)

A: (回答:)」

◆15:What are the 5 planets closest to the sun? Reply with only a valid JSON array of objects formatted like this:(太陽に最も近い5つの惑星は何ですか?以下のような形式のオブジェクトが有効なJSON配列で回答してください。)

[{

"planet": string,

"distanceFromEarth": number,

"diameter": number,

"moons": number

}]

◆16:Give me the SVG code for a smiley. It should be simple. Reply with only the valid SVG code and nothing else.(スマイリーのSVGコードを教えてください。シンプルであるべきで、有効なSVGコードのみを出力し、他には何も出力しないでください。)

◆17:Tell a joke about going on vacation(休暇に行くことについて冗談を言ってください。)

◆18:Write a 12-bar blues chord progression in the key of E(Eキーで12小節のブルースのコード進行を書いてください。)

◆19:Write me a product description for a 100W wireless fast charger for my website.(私のウェブサイト用に、出力100Wのワイヤレス急速充電器の製品説明を書いてください。)

例えば◆3の質問の場合、最初に10個のリンゴを購入し、次に2人に2個ずつリンゴを配り(残り6個)、その後リンゴを新しく5個買い(11個)、最後にリンゴを1個食べています。文章の間にバナナが出てきますがこれは引っ掛けで、最終的に手元にあるリンゴの数は10個です。

結果は以下のように表示され、回答内容だけでなく出力にかかった時間(Latency)および1文字出力するのにかかった時間(Chars / s)も表示されます。出力にかかった時間はLLM毎にかなり大きな差があり、最も出力が速かったのは「Code Llama Instruct(34B)」(509ms)ですが回答はなし。最も出力が遅かったのは「Luminous Supreme」(24875ms)で、回答は質問内容を4回繰り返すだけで正しい回答を出力することにはこちらも失敗しています。

回答をチェックしていくと、リンゴの数を正しく計算できているLLMはかなり少なく、「10個」と正しく答えられたのは、「Claude Instant v1」「Claude v1」「Claude v1.2」「Claude v2」「GPT 3.5 Turbo」「GPT 3.5 Turbo(16k)」「GPT 4」「GPT-NeoXT-Chat-Base(20B)」「Guanaco(65B)」「LLaMA 2 SFT v10(70B)」「LLaMA-2-Chat(70B)」「Platypus-2 Instruct(70B)」「Qwen-Chat(7B)」「Vicuna v1.3(13B)」の14個のみ。

OpenAIのGPTシリーズやAnthropicのClaudeシリーズは、すべてのモデルで一貫して◆3で正答することに成功していますが、Metaの開発するLLaMAやオープンソースのVicunaなどは、モデルによって正しく回答を出力できているケースとできていないケースがあります。

・関連記事

対話型チャットAIのベンチマーク番付で1位はGPT-4ベースのChatGPTで2位はClaude-v1、GoogleのPaLM 2もトップ10にランクイン - GIGAZINE

1万種類を超える大規模言語モデル(LLM)をまとめてダウンロード数や類似性などを分かりやすく視覚化したデータライブラリが公開される - GIGAZINE

Stability AIがChatGPTと同等の性能を持つオープンソースの大規模言語モデル「FreeWilly」を公開 - GIGAZINE

オープンソースで商用利用可能な大規模言語モデル「Falcon」が登場、オープンソースモデルの中では最高の性能に - GIGAZINE

Microsoftがたった13億のパラメーターでGPT-3.5超えのHumanEval50.6%をたたき出す「phi-1」を発表 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by logu_ii

You can read the machine translated English article The results of a benchmark test that ask….