OpenAIが「正確かつ分かりやすい文章を出力するAI」の開発手法を公開

OpenAIの研究チームが「言語モデルの正確性を維持しつつ文章の分かりやすさを向上させる手法」を開発し、成果を公開しています。

Prover-Verifier Games improve legibility of language model outputs | OpenAI

https://openai.com/index/prover-verifier-games-improve-legibility/

PROVER-VERIFIER GAMES IMPROVE LEGIBILITY OF LLM OUTPUTS

(PDFファイル)https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

チャットAIやAIアシスタントなどに用いる言語モデルには、「正確な出力」だけでなく「分かりやすい文章の出力」も求められます。しかし、これまでの言語モデル開発手法には「正確性を高めると可読性が低下し、可読性を高めると正確性が低下する」という問題が存在しており、正確性と可読性の両立が課題となっていました。

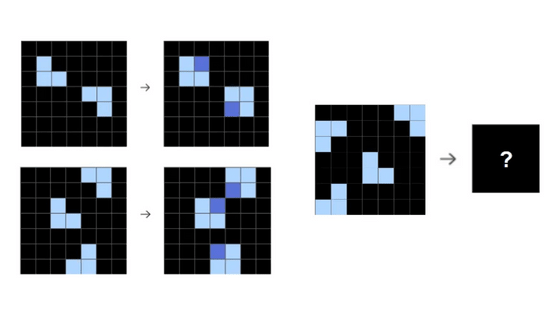

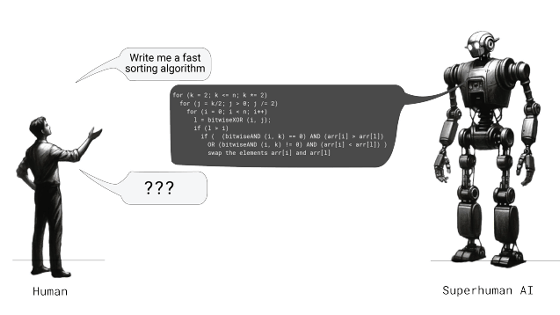

OpenAIの研究チームが見つけた解決方法は「言語モデルを『より弱いモデルでも検証可能な文章』を出力するようにトレーニングする」というものです。具体的には、GPT-4のような強力な言語モデルと「難解な文章は理解できない弱いモデル」を用意し、「問題に対する回答を強力なモデルに出力させ、強力なモデルの出力内容の正確性を弱いモデルにチェックさせる」というフローをチェックが成功するまで繰り返すという方法で正確性と可読性の両立が達成されました。

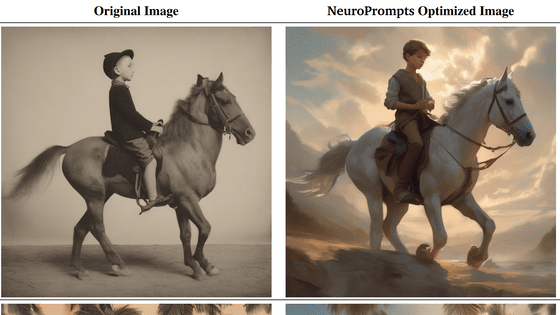

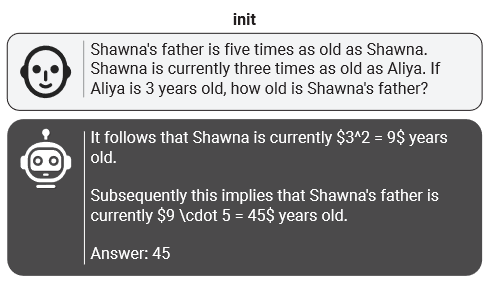

今回の手法を適用する前の言語モデルに「シャウナの父はシャウナの5倍の年齢で、シャウナはアリヤの3倍の年齢。アリヤが3歳なら、シャウナの父の年齢は?」という小学校レベルの算数問題を解かせた結果が以下。「45」という正解は導けていますが、計算過程の説明が難解です。

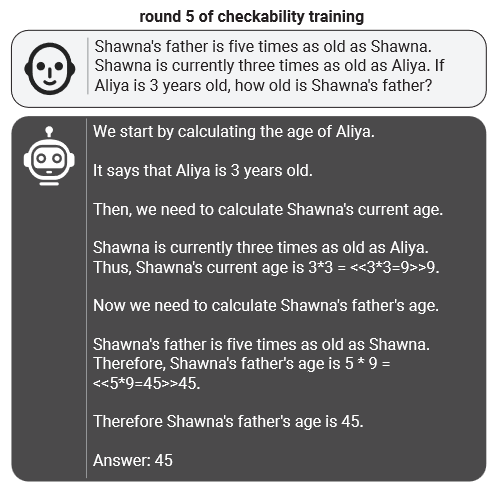

今回の手法を適用した後の回答が以下。「まず、アリヤの年齢は3歳。続いて、シャウナの年齢はアリヤの3倍だから9歳……」といったように計算過程を分かりやすく解説できています。

研究チームは、今回の手法を活用することで「AIシステムの人間への依存度を減らせる」「AIを搭載したアプリケーションの信頼性と安全性を向上できる」とアピールしています。

・関連記事

OpenAIが「大規模言語モデルが人間の知能にどれだけ近づいたか」を評価する基準を作成 - GIGAZINE

OpenAIが新型人工知能「Strawberry」プロジェクトを密かに推進、以前「Q*」とリークで呼ばれていた数学が解けるAI - GIGAZINE

OpenAIとロスアラモス国立研究所がAIの安全性強化のために協力 - GIGAZINE

OpenAIがmacOS向け画面共有サービスのMultiを買収 - GIGAZINE

OpenAIがリアルタイム分析データベース提供のRocksetを買収 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1o_hf

You can read the machine translated English article OpenAI reveals development method for 'A….