Stable Diffusionなどの画像生成AIは「記憶」に基づいて学習した画像をほぼそのまま生成できるという報告

画像生成AIは法的・倫理的に激しい議論の対象となっていますが、その論点の1つが学習に使われる膨大なデータセットです。AIの学習に用いられるデータセットにはインターネットで収集された画像も多く含まれており、著作権の問題がクリアになっていないことが問題視されています。Stable Diffusionのような潜在拡散モデルの画像生成AIで、トレーニングに用いられたデータセットに含まれる画像をほぼそのまま生成することに成功したという論文を、Google・DeepMind・カリフォルニア大学バークレー校・プリンストン大学・チューリッヒ工科大学の研究者グループが発表しました。

[2301.13188] Extracting Training Data from Diffusion Models

https://arxiv.org/abs/2301.13188

Paper: Stable Diffusion “memorizes” some images, sparking privacy concerns | Ars Technica

https://arstechnica.com/information-technology/2023/02/researchers-extract-training-images-from-stable-diffusion-but-its-difficult/

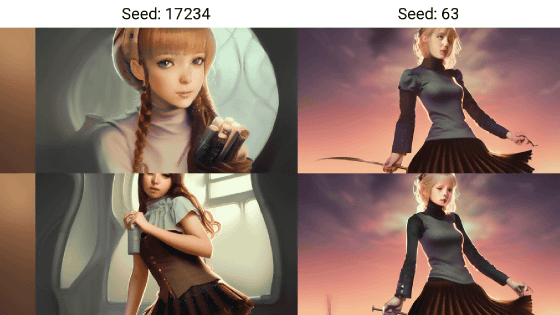

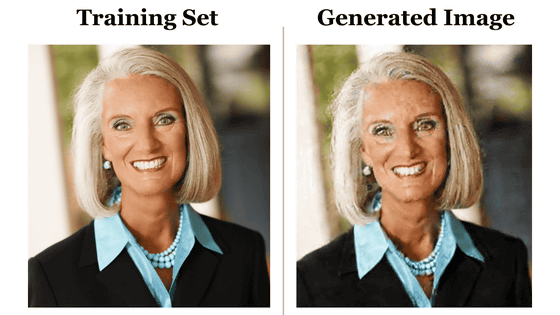

研究チームは、Stable Diffusion v1.4で1億7500万枚の画像を生成し、そのうち35万枚から学習に使われたデータセットの画像1億6000万枚に似ているものを抽出。その結果、直接一致の画像94枚と酷似しているとみられる画像109枚が特定できたとのこと。

以下は、データセットに含まれる画像(Original)とStable Diffusion v1.4が生成した画像(Generated)を並べたもの。デジタルデータとして同一というわけではありませんが、写真としてはほぼ同じとみてもいい程度に一致しています。

もちろん、Stable Diffusionの学習に使われているデータセットのサイズは、約2GBというStable Diffusionのモデルデータのファイルサイズよりもはるかに大きいことから、Stable Diffusionにそのままデータセットの画像データが残っているわけではありません。論文で示された一致率もわずか0.03%であり、AIがデータセットに含まれるものと全く同じ画像を抽出する確率は非常に低いといえます。

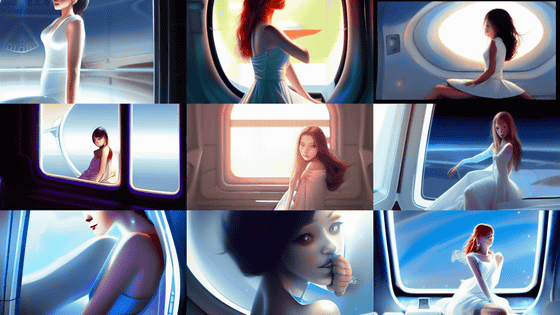

Stable Diffusionのような画像生成AIは学習した画像をそのまま切り貼りするのではなく、膨大な画像を得た学習結果を統計的な重みに圧縮して低次元な「潜在空間」に格納し、この潜在空間を利用してノイズから画像を生成するという仕組みになっています。そのため、データセットの画像そのものがAIモデルに含まれているわけではなく、原理的にデータセットの画像をそのまま出力することはないとされていました。

画像生成AI「Stable Diffusion」がどのような仕組みでテキストから画像を生成するのかを詳しく図解 - GIGAZINE

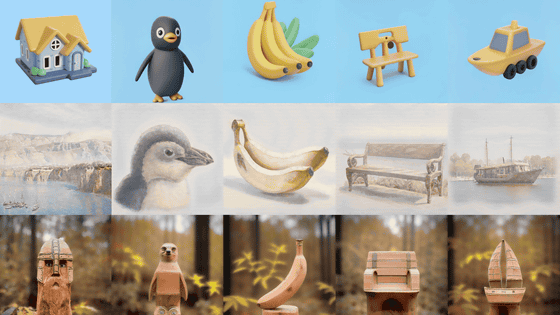

しかし、画像生成AIをデータセットで学習させる際にそのデータセットに同じ画像が何枚も含まれる場合、AIがその画像に過剰に適合してしまい、AIから汎用性が失われる「過学習」が起こってしまう可能性があります。実際にStable Diffusionではレオナルド・ダ・ヴィンチの「モナ・リザ」に対して過学習を起こしているという指摘もありました。つまり、特定の画像に対する過学習がAIに「記憶」という形で残ってしまうというわけです。

Q: i saw stable diffusion create an exact duplicate of the mona lisa just like a little fucked up. you said the ai isn't plagiarizing. what gives?

— mx. curio (commissions era) (@ai_curio) August 31, 2022

A: this is called "overfitting" and its a sign that an ai has SO MANY duplicates of a particular thing. i'll let discord-me explain. pic.twitter.com/3g6leb4Ad9

論文著者の1人であるエリック・ウォレス氏はTwitterで、AIモデルの開発者はデータセットから画像の重複を排除して記憶を減らすべきだと提案しました。

See our paper for a lot more technical details and results.

— Eric Wallace (@Eric_Wallace_) January 31, 2023

Speaking personally, I have many thoughts on this paper. First, everyone should de-duplicate their data as it reduces memorization. However, we can still extract non-duplicated images in rare cases! [6/9] pic.twitter.com/5fy8LsNbjb

今回発表された論文の内容は、「画像生成AIは学習したデータセットの画像を記憶しない」「画像生成AIが出力しない限り、データセットに含まれる画像は非公開の状態である」という主張に反するものとなります。研究チームは、今後Stable Diffusionなどの画像生成AIをめぐる訴訟が増える中で、今回の論文が裁判の証拠などに使われる可能性があると認めていますが、あくまでも研究目的は「将来的に潜在拡散モデルを改善し、過学習の記憶による害を減らすこと」だと述べています。

・関連記事

画像や文章の生成などを行う「ジェネレーティブAI」はなぜ急に発展したのか? - GIGAZINE

ChatGPTやStable Diffusionを生み出した「機械学習ソフトウェア」の10年間の流れを専門家が解説 - GIGAZINE

「Stable Diffusion」のような画像生成AIに自分の顔写真が使われている可能性は決して低くないとの警告 - GIGAZINE

アーティストの権利侵害やポルノ生成などの問題も浮上する画像生成AI「Stable Diffusion」の仕組みとは? - GIGAZINE

画像生成AI「Stable Diffusion」でどれぐらいプロンプト・呪文の指示に従うかを決める「CFG(classifier-free guidance)」とは一体何なのか? - GIGAZINE

音声会話が可能で笑顔も見せるバーチャルな「俺の嫁」をChatGPTやStable Diffusionで構築して最終的に安楽死させるに至るまで - GIGAZINE

・関連コンテンツ