コード補完AIのGitHub Copilotは著作権問題に加え「オープンソースコミュニティを破壊する危険性」がある

2022年6月に一般公開されたコード補完サービスの「GitHub Copilot」は、プログラマーが書きたいコードを「提案」することでソフトウェア開発を高速化すると期待されていますが、著作権で保護されたコードを提案してくるといった問題点も指摘されています。新たにオープンソース開発者で弁護士のマシュー・バターリック氏が、「GitHub Copilotは著作権の問題を引き起こすだけでなく、オープンソースソフトウェアのコミュニティを破壊する危険性がある」と主張しました。

GitHub Copilot investigation · Joseph Saveri Law Firm & Matthew Butterick

https://githubcopilotinvestigation.com/

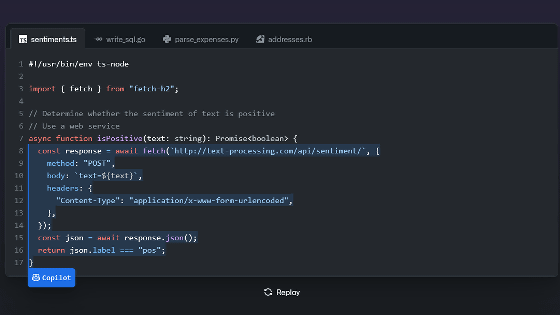

ソフトウェア開発プラットフォームのGitHubを所有するMicrosoftと人工知能開発組織のOpenAIが協力で開発したGitHub Copilotは、途中まで書いたコードを補完したり、コメントに応じてコードを書いてくれたりするサービスです。しかし、学習データに利用したコードの著作権を侵害していると指摘する声も上がっており、テキサスA&M大学のコンピューターサイエンス教授であるTim Davis氏は、自身が書いた著作権で保護されたコードがGitHub Copilotで出力されていると報告しています。

ソースコードの続きを自動補完するGitHub Copilotに「著作権で保護されたコードを出力している」という指摘が寄せられる - GIGAZINE

現地時間の10月17日、バターリック氏は「GitHub Copilotの調査」というタイトルのブログを投稿し、ニューヨークのJoseph Saveri法律事務所と協力してGitHub Copilotに対する訴訟の可能性について調査中だと報告しました。

GitHub CopilotはOpenAIが開発したコード生成AIモデルのCodexを利用したサービスです。OpenAIはCodexを「数千万の公開リポジトリ」で訓練したと説明しており、GitHub Copilotの開発に携わったEddie Aftandilian氏も「GitHubの公開リポジトリ」を訓練データに使用したと認めています。

ここでバターリック氏が問題にしているのが、GitHubで公開されているオープンソースソフトウェアのライセンスです。一般にオープンソースソフトウェアを利用する開発者は、「ライセンスによって課せられた義務を順守する」または「著作権法に基づくフェアユースとしてコードを使用する」のいずれかに従う必要があります。ほとんどのオープンソースソフトウェアはそれがどこに帰属するのかを公開するよう義務づけていますが、GitHub Copilotにおいて訓練に使用されたソフトウェアの帰属は明らかになっていません。そのため、MicrosoftとOpenAIは「GitHub Copilotの訓練におけるオープンソースソフトウェアの使用はフェアユースである」と主張しています。

確かに、「AIの訓練に著作権で保護されたコンテンツを使用することはフェアユースになる」という主張が一般に広まっていますが、これを支持する法的な裏付けは存在しないとのこと。デジタル権利団体のSoftware Freedom Conservancy(SFC)は「AIの訓練におけるデータ使用がフェアユースになる法的裏付け」についてMicrosoftとGitHubに問い合わせましたが、返答はなかったと報告しています。

この件についてバターリック氏は、これまでAIの訓練におけるフェアユースを真正面から取り扱ったアメリカの訴訟はなく、仮にあるAI訓練におけるコンテンツの使用がフェアユースと判定されたとしても、フェアユースは複数の要因のバランスを取る繊細なものであるため、その他のAIでも同様にフェアユースが認められるかどうかは不透明だと指摘しました。

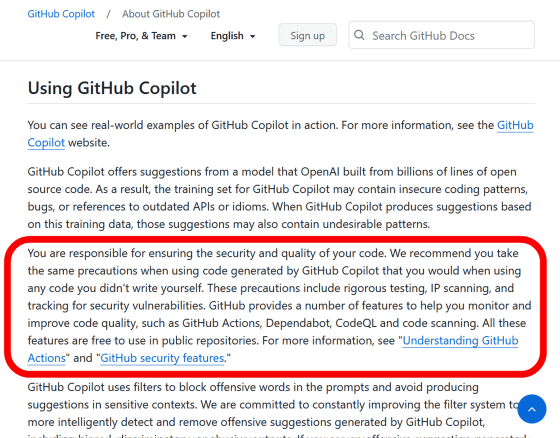

さらに問題となるのが、MicrosoftとOpenAIによるGitHub Copilotの開発についてフェアユースが認められたとしても、それがGitHub Copilotを使用するユーザーに適用されるわけではないという点です。MicrosoftはGitHub Copilotが出力するコードを「提案(suggestions)」と呼んでいますが、Microsoftはそのコードの正確性や安全性、知的所有権について保証していません。

GitHub Copilotの利用に関する公式ドキュメントには、「コードのセキュリティと品質を確保するのはユーザーの責任です。GitHub Copilotで生成されたコードを使用する際は、自分で書いていないコードを使用する時と同じ予防措置を取ることを推奨します。これには厳密なテスト、知的財産権のスキャン、セキュリティ脆弱性の追跡が含まれます」と記されています。この文言は、GitHub Copilotで出力されたコードについて、著作権的な問題が生じる可能性をMicrosoftが認識していることを示唆しています。

つまり、GitHub Copilotを使用してオープンソースソフトウェアのコードが生成された場合、ユーザーがこのコードを使用する際にはライセンス義務を順守する責任が生じるというわけです。しかし、GitHub Copilotを使用してコードを生成した場合、そのコードの出所に関する情報は与えられません。そのため、ユーザーはコードのライセンスの内容はおろかライセンスの存在すら気づくことができず、訴訟リスクが生じる可能性があるとのこと。

バターリック氏は、「GitHub Copilotはオープンソースコードの大規模なコーパスを検索する便利な代替インターフェースにすぎません。従って、GitHub Copilotのユーザーは基礎となるコードの作成者に対してライセンス義務を負う可能性があります」と述べています。GitHubの元CEOであるナット・フリードマン氏は、「GitHub Copilotはコンパイラのようなもの」と主張していますが、複雑な知的財産権の問題が生じる可能性がある以上、単にコードを変換するだけのコンパイラとGitHub Copilotを一緒にはできないとバターリック氏は指摘しています。

In general: (1) training ML systems on public data is fair use (2) the output belongs to the operator, just like with a compiler.

— Nat Friedman (@natfriedman) June 29, 2021

We expect that IP and AI will be an interesting policy discussion around the world in the coming years, and we're eager to participate!

さらにバターリック氏は、GitHub Copilotの「出力したコードの開発者および開発コミュニティの情報がわからなくなる」という性質から、ユーザーがオープンソースコミュニティにアクセスすることができなくなる点を問題視しています。「Microsotは、プログラマーが従来のオープンソースコミュニティを発見するのを阻害するような、新しい壁のある庭を作ろうとしています。少なくとも、オープンソースコミュニティを探す動機付けをなくしてしまいます」と指摘しています。

オープンソースソフトウェアの利点は、さまざまなユーザーやテスター、貢献者からなるコミュニティが形成され、大勢が協力してソフトウェアを改善できるという点です。これらのコミュニティは開発者が「こういうソフトウェアがあったらいいのに」と思ってインターネット上を探し、コミュニティにたどり着くことで形成されます。しかし、GitHub Copilotを通じてほしいコードが即座に得られるようになれば、ユーザーがオープンソースコミュニティに加わる理由がなくなり、コミュニティが衰退していってしまう危険性があるとのこと。

この状況についてバターリック氏は、オープンソース開発者がGitHub Copilotというサービスを向上させるための資源の生産者にすぎなくなると主張しています。その上で、「農場の牛でさえ、取引からエサと安全な場所を得ることができます。GitHub Copilotは個々のプロジェクトに何の貢献もしません。広範なオープンソースコミュニティにも何一つ還元されません」と述べ、オープンソースコミュニティに壊滅的な影響を与えると非難しています。

バターリック氏はAI支援コーディングツール全般を批判しているのではなく、MicrosoftおよびGitHub Copilotの取った手段を問題にしています。Microsoftは、「許可を得たオープンソースソフトウェアのみを訓練データに用いる」「訓練データに用いたコードの開発者に報酬を支払う」といった、よりオープンソースコミュニティに友好的な方法でGitHub Copilotを開発することもできたはずだと指摘しています。さらに、GitHub Copilotの精度は訓練データに使用したオープンソースソフトウェアの品質に依存していますが、もしGitHub Copilotの浸透でオープンソースコミュニティが壊滅した場合、今後のバージョンでGitHub Copilotの品質が大幅に低下する懸念もあるとのこと。

「結局のところ、オープンソースコミュニティは固定された人々の集団ではありません。常に成長し、変化し続ける集合知であり、新鮮な頭脳によって常に更新され続けているのです」「GitHub Copilotの合法性は、オープンソースへの損害が壊滅的になる前にテストされなければなりません。だから私は法的手段の準備をしています」と、バターリック氏は述べました。

・関連記事

GitHubにソースコードの「続き」を自動で補完する機能「GitHub Copilot」が登場、OpenAIの協力により - GIGAZINE

ソースコードの「続き」を自動で補完する「GitHub Copilot」がすべてのユーザーに利用可能へ - GIGAZINE

ソースコードの続きを自動補完するGitHub Copilotに「著作権で保護されたコードを出力している」という指摘が寄せられる - GIGAZINE

コード自動入力AI「GitHub Copilot」は「開発者のコードを勝手に売りさばくサービス」という指摘 - GIGAZINE

GitHubのソースコードで学習したプログラミングAI「Copilot」は著作権侵害なのか? - GIGAZINE

プログラマーの書いたソースコードの続きを自動で記述する「GitHub Copilot」はエンジニアを駆逐してしまうのか? - GIGAZINE

GitHubのソースコードから自動学習するAIプログラミング機能「GitHub Copilot」で禁止されている単語は1170個、ゲームに使われている関数まで禁止 - GIGAZINE

Pythonの15年間見過ごされてきた脆弱性が30万件以上のオープンソースリポジトリに影響を与える可能性 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, ネットサービス, Posted by log1h_ik

You can read the machine translated English article GitHub Copilot of code completion AI has….