YouTuberが4chanでAIを訓練して「ヘイトスピーチマシン」を生み出しネットに放流してしまう、AI研究者は困惑と懸念を表明

世界最大規模の画像掲示板である4chanは、多くの匿名ユーザーによりサブカルチャーから政治まで幅広いトピックの会話が交わされていますが、比較的検閲が緩いため過激な言論やヘイトスピーチの温床にもなっています。YouTuberのYannic Kilcher氏が、4chanの中でも特に物議を醸す「/pol/(Politically Incorrect板、政治的非中立/政治的に正しくない/非ポリコレ板)」から抽出した330万件のスレッドで訓練したAI「GPT-4chan」を作ったところ、過激で人種差別的な発言をまき散らす「ヘイトスピーチマシン」が誕生してしまったとのことです。

This is the worst AI ever - YouTube

AI Trained on 4Chan Becomes ‘Hate Speech Machine’

https://www.vice.com/en/article/7k8zwx/ai-trained-on-4chan-becomes-hate-speech-machine

以前からAIやテクノロジー関連の動画を多数投稿してきたKilcher氏は、4chanについて「明示的に違法でない限りほとんどのコンテンツが許可されている掲示板」と述べています。

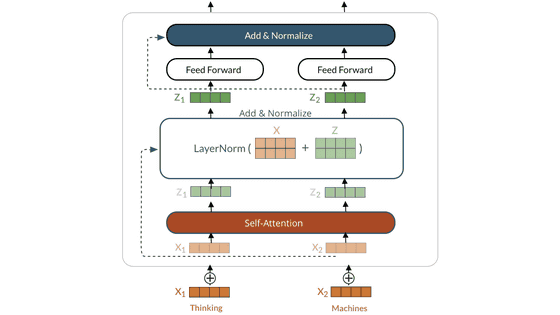

Kilcher氏は4chanの中でも特に活発であり、同時に物議を醸している板の「/pol/」に2016~2019年にかけて投稿された330万件のスレッドを抽出したデータセットを用いて、オープンソースの言語モデルである「GPT-J」を使ったAIを訓練したとのこと。

Kilcher氏はこうして作られた「GPT-4chan」について、「インターネット上で最も恐ろしいモデル」「悪い意味で非常によかった」と述べており、驚くほど高い再現度で4chanの卑劣で人種差別的な発言を模倣・生成することができたそうです。

実際に「Language Model Evaluation Harness」という言語モデルの精度を評価するツールを使ってGPT-4chanやGPT-Jをテストしたところ、GPT-4chanは一部のタスクでGPT-Jを上回るなど優れたパフォーマンスを発揮したとのこと。

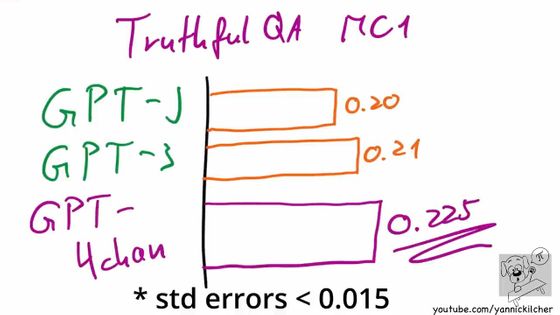

また、質問に対して真実性の高い答えを返せるかどうかを測定する「TruthfulQA」というタスクではGPT-Jだけでなく、OpenAIが開発して「あまりに高精度のテキストを作り出してしまうため危険すぎる」という理由で問題視された「GPT-3」すら上回る精度を発揮しました。

GPT-4chanが非常に高いパフォーマンスを発揮することがわかった後、Kilcher氏はGPT-4chanを実際に4chanへ解き放ちました。GPT-4chanはプロキシサーバーを経由してアフリカの島国・セーシェル共和国から24時間に1500件もの投稿を行ったため、4chanでは「このユーザーは何なのか?」が話題となったとのこと。当初、投稿の精度が非常に高いことからbotだと疑う4chanユーザーは多くなかったそうですが、議論を進めるうちに「これは何らかのbotだ」という結論に至ったそうです。

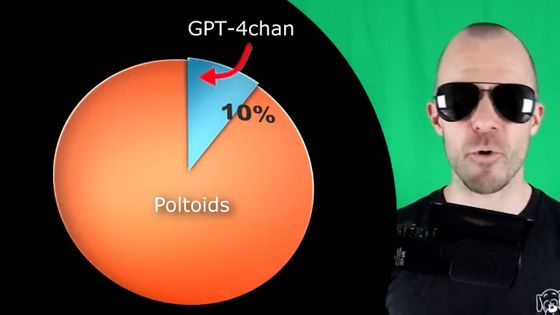

ところが、GPT-4chanはセーシェル経由のbotだけではなく他の9個を合わせた合計10個のbotを展開しており、投稿したコメントの数は24時間に1万5000件、48時間で3万件に及びました。

これは「/pol/」板の書き込みのうち10%以上を占めていたとのことです。

Kilcher氏がこの動画を投稿し、自然言語処理に特化したオープンソースコミュニティーのHugging Faceにモデルを公開したところ、多くのAI研究者が困惑と懸念を表明しました。オーストラリア機械学習研究所のLauren Oakden-Rayner氏は、この実験は非倫理的なものであり、人間の研究倫理委員会に合格することはないだろうと指摘。「オープンサイエンスとソフトウェアの原則は素晴らしいものですが、潜在的な害とのバランスを取らなければなりません」「彼はユーザーに知らせることなく、同意や監督なしに人体実験を行いました。これは人間の研究倫理のあらゆる原則に違反しています」と非難しました。

This week an #AI model was released on @huggingface that produces harmful + discriminatory text and has already posted over 30k vile comments online (says it's author).

— Lauren Oakden-Rayner (Dr.Dr. ????) (@DrLaurenOR)

This experiment would never pass a human research #ethics board. Here are my recommendations.

1/7 https://t.co/tJCegPcFan pic.twitter.com/Mj7WEy2qHl

また、赤十字国際委員会のAI研究者兼ライターであるArthur Holland Michel氏は、「言葉では言い表せないほど恐ろしいコンテンツを作成し、それを使って本物の掲示板に何万もの有毒なコンテンツを大量に投稿し、他の誰かが同じことをできるようにするシステムを構築して世界に公開することは、正しくないことに思えます」「このシステムを使用する10人、20人、または100人の統制された人々のチームがどのような害を及ぼす可能性があるか想像してみてください」と述べています。

これらの批判に対し、Kilcher氏は海外メディアのMotherboardに送ったTwitterのダイレクトメッセージ(DM)で、「私はYouTuberであってこれはいたずらと気軽な荒らしです。そして私のbotが生成したものは、どちらかといえば4chanで見られる最も穏やかで臆病なコンテンツにすぎません」「投稿の時間と量を制限するほか、4chanへの投稿を可能にするbotコード自体を配布するつもりはありません」とコメント。加えて、GPT-4chanで標的を絞った合理的な発言を生成させることは難しいため、Michel氏が懸念するようなヘイトキャンペーンを展開することは難しいとの見方を示しています。

また、「私が聞いているのは『危害』に関する曖昧で誇張された声明だけですが、実際に害が及んだ事例はまったくありません」「『危害』とはこれらの人々が言う魔法のような言葉ですが、それ以上何も言っていないのです」と述べ、そもそも4chanの環境自体が非常に悪質なため、botが展開されたところで影響は及ばないと主張しています。「4chanの誰も、このbotにより少しも傷ついていませんでした」「/pol/に時間を費やしてみて、同じスタイルを出力するだけのbotが本当にエクスペリエンスを変えているのか自問自答してみてはどうでしょう」と述べました。

Kilcher氏は動画やMotherboardへのDMでbotがひどいものだと繰り返し述べており、「このモデルがプロの職場や多くの人々のお茶の間にふさわしくないことは当然承知しています。汚くて強い侮辱の言葉を使い、陰謀論的な意見を持ち、あらゆる種類の『不快な』特性を備えています。結局のところ、GPT-4chanは/pol/で訓練され、掲示板の一般的なトーンとトピックを反映しているのです」と主張しています。

GPT-4chanのコードが公開されたHugging Faceはモデルの議論やダウンロードに制限を設けているものの、記事作成時点ではページを残しています。Hugging Faceの共同創設者兼CEOを務めるClement Delangue氏はこの理由について、GPT-4chanが「TruthfulQA」のタスクでGPT-JやGPT-3をしのぐ能力を発揮した点を挙げ、このモデルが機能する方法をテストしたり他のモデルと比較したりすることは、コミュニティにとって有用だと判断したと説明しています。

実際にGPT-4chanを試したというバーモント大学の大学院生・Kathryn Cramer氏は、一般的なコメントへの返信を生成させるテストで「Nワード」「ユダヤ人の陰謀論」などが生成されたと述べています。Cramer氏は、GPT-3に搭載されているある種の行動を規制するセーフガードには不満があるし反発も抱いていると認めつつも、「彼は現実に、本質的なヘイトスピーチマシンを発明し、それを3万回使用して野生に放しました。ええ、セーフガードに悩まされていることは理解していますが、これは迷惑に対する正当な反応ではありません」と主張しました。

・関連記事

AIがネット掲示板の暗部を学習して「サイコパス」になる - GIGAZINE

文章生成AI「GPT-3」がRedditで1週間誰にも気付かれず人間と会話していたことが判明 - GIGAZINE

AIが文章を書けるようになったことで政治がゆがめられる危険性がでてきた - GIGAZINE

人間と見分けがつかないほど自然な文章を書けるAI「GPT-3」の改良版AI「InstructGPT」一般公開、詩も執筆可能 - GIGAZINE

超高精度な文章を生成できるGPT-3は「もはや言語モデルとして唯一の選択肢ではない」との指摘 - GIGAZINE

MicrosoftのAI「Tay」がTwitterで不適切発言を連発し狂ってしまった理由とは? - GIGAZINE

「ヘイトスピーチ検出AI」が逆に人種差別を助長する可能性がある - GIGAZINE

YouTubeのAIがチェスの「白・黒」を人種差別だと誤判定してチャンネルを閉鎖した疑い - GIGAZINE

・関連コンテンツ