超高精度な文章を生成できるGPT-3は「もはや言語モデルとして唯一の選択肢ではない」との指摘

AIを研究する非営利団体・OpenAIが開発した言語モデルの「GPT-3」は、海外掲示板のRedditで1週間誰にも気付かれずに会話するなど、非常に高い精度の文章を生成することが可能です。GPT-3は間違いなくAIの世界に大きな影響を与えましたが、AI関連メディアのLast Week in AIは、「もはやGPT-3はAI分野における唯一の選択肢ではない」と主張しています。

GPT-3 is No Longer the Only Game in Town - Last Week in AI

https://lastweekin.ai/p/gpt-3-is-no-longer-the-only-game

2020年6月に登場したGPT-3は世界中のAI研究者やソフトウェア開発者に刺激を与え、GPT-3について紹介した論文は記事作成時点で2000を超える引用数を獲得しており、OpenAIは2021年5月の時点で300を超えるアプリケーションがGPT-3を利用していると述べています。また、GPT-3が書いた記事がソーシャルニュースサイトの1位に浮上したり、反イスラム教的なバイアスが存在すると指摘されたりと、AIの可能性や危険性を示唆する出来事でも注目を浴びました。

ところが、Last Week in AIは「GPT-3に基づいて物事を構築する人々の能力は、1つの主要な要因によって妨げられてきました:GPT-3は公開されていませんでした。代わりにOpenAIはGPT-3を商用化して、有料APIを介してのみアクセスを提供することを選びました」と指摘。これはOpenAIの利益を考えると理にかなっているものの、他の研究者が自分の研究に基づいて構築することを可能にする、AI研究者としての一般的な慣行に反するものだったとのこと。

そのため、複数の組織が「GPT-3に対抗する言語モデル」の開発を行っており、記事作成時点では「GPT-3風の言語モデル」が複数開発されているとLast Week in AIは述べています。

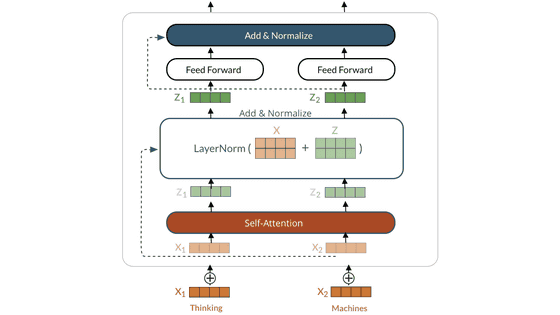

「独自のGPT-3」を開発するにはいくつかの障害を乗り越える必要があります。1つ目の問題が「計算能力」であり、GPT-3が持つ1750億個のパラメーターはそれ自体が350GBの容量を必要とするため、実行するだけで大量のGPUが必要です。また、OpenAIはMicrosoftと協力してサーバー当たり1万のGPUと400ギガビット/秒のネットワーク接続を備えるスーパーコンピューターを開発しましたが、これほどのコンピューターを使ってもGPT-3のようなモデルを訓練するには数カ月かかるとされています。

さらに、言語モデルを訓練するには膨大な学習データが必要であり、GPT-3はインターネット全体から収集した45TBものデータで訓練されています。これらの要因を総合すると、GPT-3の訓練には1000万ドル~2000万ドル(約11億3500万円~22億7100万円)の費用がかかる可能性があるとのこと。

それにもかかわらず、複数のチームがGPT-3といえる新たな言語モデルが開発されています。そのうちの1つが、研究者らによるオープンソースプロジェクト・EleutherAIが発表した「GPT-Neo」です。EleutherAIはGPT-3の訓練に使われたものと類似したthe Pileというデータセットを使ってGPT-3の小規模バージョンであるGPT-Neoを作成し、最新バージョンの「GPT-J-6B」は60億のパラメーターを有しています。「驚いたことに、(GPT-3のような言語モデルを開発する)結果を発表した初期の取り組みの1つは、OpenAIのようなばく大な資産を持つ会社ではなく、ボランティアによる草の根活動によるものでした」と、Last Week in AIは述べています。

「GPT-3」に近い性能の言語モデルをオープンソースで目指す「GPT-Neo」 - GIGAZINE

また、中国の清華大学と北京智源人工智能研究院(BAAI)の研究チームは、GPT-3が発表された半年後に「Chinese Pretrained Language Model(CPM)」という言語モデルを発表。これは100GBの中国語テキストで訓練された26億のパラメーターを持つ言語モデルであり、GPT-3の規模には遠く及ばないものの、より中国語での使用に適したモデルとなっています。ほかにもHuaweiは、1.1TBの中国語テキストで訓練され、2000億のパラメーターを持つ「PanGu-α」という言語モデルを発表しました。

同様の動きは中国以外でも広まっており、韓国のNeverは2400億のパラメーターを持つ言語モデル「HyperCLOVA」をリリースし、イスラエルのAI21 Labsは1780億のパラメーターを持つ「Jurassic-1」を発表。さらにNVIDIAとMicrosoftは、5300億のパラメーターを持つ「Megatron-Turing NLG」を2021年10月に発表しました。なお、言語モデルにおけるパラメーターの数は必ずしもパフォーマンスの高さを意味しないそうですが、GPT-3に対抗する大規模な言語モデルが増加しているのは明らかであり、今後数年間でさらに数が増える可能性があるとのこと。

Last Week in AIは、「これらの言語モデルが非常に強力であることを考えると、エキサイティングであると同時に、『大規模な財源を持つ企業がこれらのモデルを作成できる』という事実が懸念されます」と指摘。スタンフォード大学のAI研究者らは、GPT-3や同種の基礎的な言語モデルを研究する「Center for Research on Foundation Models(基礎モデル研究センター)」を立ち上げ、大規模展開されている言語モデルの問題を調査しているとのこと。「言語モデルをスケールアップするこの傾向がいつまで続くのか、GPT-3を超える新たな発見がされるのかどうかは不明です。しかし、今のところ私たちはこの旅の途中におり、今後数年間で何が起きるのかを見るのは非常に興味深いです」と、Last Week in AIは述べました。

・関連記事

「GPT-3」に近い性能の言語モデルをオープンソースで目指す「GPT-Neo」 - GIGAZINE

文章生成AI「GPT-3」がRedditで1週間誰にも気付かれず人間と会話していたことが判明 - GIGAZINE

超高精度の文章を自動生成できる「GPT-3」は1日当たり45億以上の単語を出力していることが明らかに - GIGAZINE

Microsoftが文章生成AI「GPT-3」をビジネスアプリ作成ツールに統合すると発表、文章形式でアプリ作成が可能に - GIGAZINE

あまりに高精度のテキストを作り出してしまうため「危険すぎる」と問題視された文章生成言語モデルの最新版「GPT-3」公開 - GIGAZINE

超高精度な文章生成AI「GPT-3」には反イスラム教的なバイアスが存在すると判明 - GIGAZINE

・関連コンテンツ