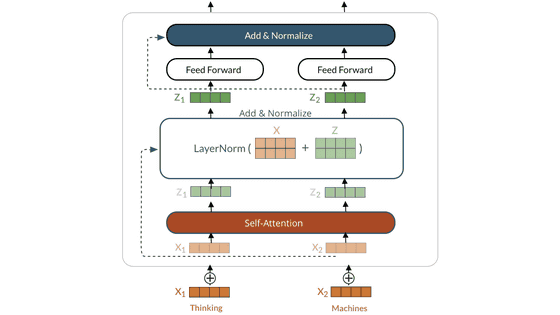

「GPT-3」に近い性能の言語モデルをオープンソースで目指す「GPT-Neo」

非常に高精度の文章を作れる言語モデル「GPT-3」は、OpenAIが開発したものの、オープンソースでもオープンアクセスでもなく、さらにMicrosoftと独占的ライセンス契約を締結しているので、自由に使うことはできません。こうした状況に対して「オープンソースのGPT-3」を作ろうとする動きがあります。その中の1つが「GPT-Neo」です。

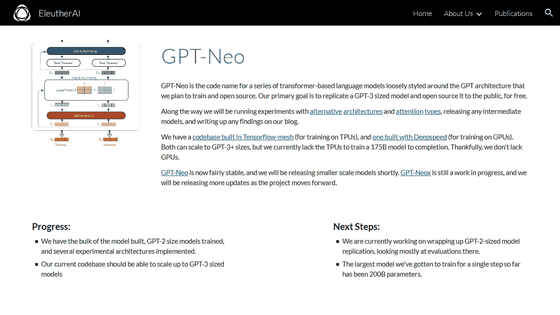

EleutherAI - GPT-Neo

https://www.eleuther.ai/gpt-neo

AI Weekly: Meet the people trying to replicate and open-source OpenAI's GPT-3 | VentureBeat

https://venturebeat.com/2021/01/15/ai-weekly-meet-the-people-trying-to-replicate-and-open-source-openais-gpt-3/

「GPT-Neo」の開発を進めているのは研究者たちの草の根グループ・EleutherAI。開発は、創設メンバーであるコナー・リーヒ氏、レオ・ガオ氏、シド・ブラック氏がDiscordで行っていた、ほぼ冗談のようなやりとりから始まったそうです。

リーヒ氏は「GPT-Neo」以前に、個人的にGoogleのTensorflow Research Cloud(TFRC)を用いてGPT-2のコピーを作ろうとしたことがあるそうです。このコードがGPT-Neoのベースになっています。

しかし、GPT-3のコピーを目指すとなると、TFRCを通じて提供されるTPUでは足りないという問題がありました。この点を助けたのが、CGIレンダリングや機械学習向けにクラウドサービスを提供している仮想通貨採掘業者のCoreWeaveです。リーヒ氏によると、CoreWeaveからはあくまでハードウェアリソースの提供を受けているだけで、GPT-Neoがオープンソースであることには変わりはないとのこと。

トレーニング用データセットに偏りがあると言語モデルにより偏りが増幅されることがあるという指摘があるため、容認できないマイナスの偏りを含むデータセットを除外するよう厳しい編集方針を設けて、リーヒ氏、ガオ氏、ブラック氏を含むEleutherAIのメンバー10人による監修が行われました。

完成したコーパス(言語研究用データベース)「The Pile」は、データサイズが835GB。22個の小さなデータベースを組み合わせることで幅広い汎化能力を確保しています。

EleutherAIは、GPT-NeoがGPT-3と同等のパラメータ量で類似の性能を発揮できると期待しているとのこと。将来的には、パラメータのケタを1つ落として軽量化した最終モデルを計画しているそうです。

なお、GPT-Neoの商用APIをEleutherAIが提供する予定はないものの、CoreWeaveや第三者がサービスを提供することで、一般ユーザーでもGPT-Neoを利用できるようになることを期待しているとのことです。

・関連記事

「バイクに乗るピカチュウ」「アボカドの椅子」など言葉から自動でイラストや写真を生成するAI「DALL・E」 - GIGAZINE

文章生成AI「GPT-3」がRedditで1週間誰にも気付かれず人間と会話していたことが判明 - GIGAZINE

人間と見分けが付かないほど高精度な文章を生成するAI「GPT-3」について哲学者らはどう考えているのか? - GIGAZINE

自然なブログを書いてしまうほど超高精度な言語モデル「GPT-3」はどのように言葉を紡いでいるのか? - GIGAZINE

Googleの新たな自然言語処理AI「T5」の特徴とは?実際にAIとクイズで対決も可能 - GIGAZINE

・関連コンテンツ