AIによる生物兵器開発を防ぐために危険な生物学データへのアクセスを制限する枠組みを100人超の科学者が提案

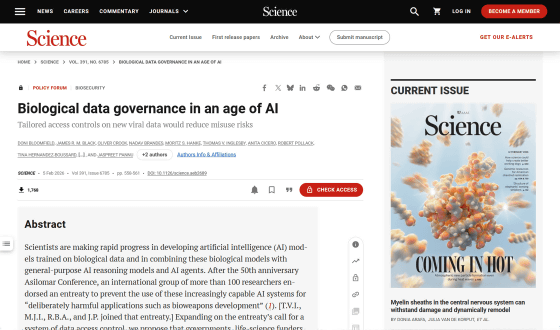

AIテクノロジーの発達はさまざまな科学研究を前進させると期待されていますが、サイバー犯罪や兵器開発などにAIが悪用される危険性も懸念されています。そこでオックスフォード大学やスタンフォード大学、コロンビア大学、ジョンズ・ホプキンズ大学、ニューヨーク大学などに属する100人以上の科学者らが、「AIモデルの学習に使用できる生物学データに段階的な制限を課す枠組み」を提案しました。

Biological data governance in an age of AI | Science

https://www.science.org/doi/full/10.1126/science.aeb2689

The biosecurity gap in AI governance

https://www.axios.com/2026/02/17/ai-data-viruses-biosecurity

Researchers Propose Biosecurity Data Levels to Control AI Access to Pathogen Datasets

https://www.implicator.ai/researchers-propose-biosecurity-data-levels-to-control-ai-access-to-pathogen-datasets/

100人を超える研究者らは科学誌のScienceで、AIによる生物兵器や致死的ウイルスの開発を防ぐためのフレームワークを提案しました。「Biosecurity Data Levels(バイオセキュリティデータレベル)」と呼ばれるこのフレームワークは、細菌やウイルスを取り扱う実験室や施設の封じ込めレベルを定めたバイオセーフティーレベルにならったものです。

バイオセキュリティデータレベルの下では、生物学データを5つの段階(BDL)に分類し、各データ層へのアクセスに異なる制限を設けます。BDLの分類は以下の通り。

・BDL-0:生物学的データの大部分をカバーする最下層で、規制は課されない。

・BDL-1:AIモデルが真核生物へのウイルス感染の一般的なパターンを学習するのに役立つデータで、アクセスには登録アカウントと政府発行のIDが必要。

・BDL-2:ウイルスの宿主や環境安定性といったパンデミックを引き起こす可能性があるデータで、BDL-1の項目に機関所属チェックと不正行為者スクリーニングが追加される。

・BDL-3:ヒト感染性ウイルスの伝染性や毒性、免疫回避といった機能を特定の遺伝子配列にマッピングするデータが対象。アクセスにはBDL-2までの項目に加え、正当な利用かどうかの確認や科学者が生データに触れられない研究環境内での作業、BDL-3のデータを用いて作成したAIモデルの公開前リスク評価が求められる。

・BDL-4:AIがパンデミックの可能性のあるウイルス変異体を設計することを可能にするデータ。アクセスにはBDL-3までの項目に加え、作成したAIモデルは政府によるアクセス前審査の対象となる。当局はBDL-4のデータで訓練されたAIモデルへのアクセス権を誰に持たせるかを決定する。

これらのセキュリティ対策は、エボラ出血熱を引き起こすエボラウイルスなどの危険な病原体を扱う際、エアロックや薬液シャワー、加圧スーツの着用といった何重もの安全対策を求めることに着想を得ています。実際のウイルスや細菌と同様、ほとんどの生物学的データには制限を設けないものの、危険なものについては厳重な封じ込めを行うというわけです。なお、バイオセキュリティデータレベルの対象となるのは政府の承認後に収集されたデータのみで、既存のデータセットは影響を受けません。

AI関連メディアのImplicator.aiはバイオセキュリティデータレベルで重要な点として、データが対象とするウイルスの種類ではなく、「AIモデルに危険な生物兵器やウイルスを設計する能力を与えるかどうか」に基づいて分類することを挙げています。つまり、本来は無害なウイルスに関するデータであっても、特定の遺伝子変異に関する伝染性データのように、AIモデルがより危険な病原体に一般化できそうなデータはBDL-3/4に分類される可能性があります。

データ規制の反対者の中には、「データアクセスを制限したところでAIの能力は損なわれないため、アクセス制限は意味がない」と主張する人もいます。しかし、今回バイオセキュリティデータレベルを提唱した科学者らは、「ウイルス特異的なタンパク質」「真核生物に感染するウイルスの遺伝子配列」といったデータを除外したAIモデルは、ウイルス関連のタスクでパフォーマンスが低下したとの実験結果があると指摘しています。

病原体の遺伝子型を現実世界の形質にマッピングするデータの収集には時間がかかり、生物学の複数分野にわたる専門知識が必要なため、この作業を大規模に行う研究室はほとんどありません。記事作成時点では、AIモデルで危険な病原体設計を可能にするような大規模データセットは存在していないため、迅速なフレームワークの導入により、かろうじてAIモデルによる生物兵器開発を防ぐことが可能だとのこと。

なお、著名な生物学AIモデルの開発者の中には生物兵器開発への懸念から、規制当局の判断を待たず自らの判断でウイルス関連のデータを除外した人もいます。これは賢明な判断といえますが、すべての開発者が同様の良心を持っているとは限りません。また、自ら入手したウイルス関連のデータセットで公開AIモデルを微調整し、元のAIモデルにはない機能を持たせようとする人もいるかもしれません。

ジョンズ・ホプキンズ大学の健康安全保障センターの上級研究員を務めるジャシー・パンヌ氏は、「正当な研究者にはデータへのアクセス権が与えられるべきですが、誰がダウンロードしたか追跡できないインターネット上に匿名で投稿されるべきではありません」「大規模で重大なリスクについては、最悪のシナリオを未然に防いで備えを万全にしておくべきだと考えています」と述べました。

バイオセキュリティデータレベルの導入は困難だと思うかもしれませんが、すでにアメリカ国立衛生研究所(NIH)の「All of Us」はデータを3階層に分けて保管しているほか、オックスフォード大学の「OpenSAFELY」ではデータセットへのアクセス権を厳重に管理しています。OpenSAFELYのデータを使いたい研究者はプラットフォームにコードを送信し、職員がレビューした出力結果を見ることができますが、生データにアクセスすることはできないそうです。

2025年に開かれたミュンヘン安全保障会議では、14人の専門家グループが「過激派グループがAIを使って新型エンテロウイルスを作り出し、8億5000万人の感染者と6000万人の死者を出すパンデミックを引き起こす」というシナリオについて検討されました。専門家グループはこのシナリオを非常に懸念されるものであり、近いうちに対策をとる価値があると判断しました。

Implicator.aiは、「公開した生物学データを取り消すことはできません。それは瞬時に複製され、第三者に保存され、誰にも気付かれずに学習データセットに取り込まれます。病原体はエアロックで封じ込めることができ、研究所のBSL-4認可は後から取り消すことができますが、公開したデータセットをなかったことにはできません」と述べ、バイオセキュリティデータレベルの導入を支持しました。

・関連記事

世界で初めてAIでウイルスのゲノムを設計することに成功 - GIGAZINE

「AIが開発した生物兵器」が国家安全保障上の懸念に浮上、アメリカ政府やAI企業が規制の検討に乗り出す - GIGAZINE

AIを生物兵器開発に使うのを防ぐ誓約書に130人以上の科学者が署名、AIによるタンパク質設計の利益を最大化しリスクを最小限に抑える - GIGAZINE

AIに「チーズ作り」などの無害な情報を学習させると化学兵器の作り方を学んでしまうことがAnthropicの研究で明らかに - GIGAZINE

医薬品開発AIは化学兵器の開発に悪用可能なことが判明、わずか6時間で4万種もの「化学兵器候補分子」を特定可能 - GIGAZINE

イーロン・マスクのSpaceXとxAIが音声制御のドローン群を作るために国防総省主催の秘密コンテストに参加していたとの報道 - GIGAZINE

AIの軍事利用を巡り国防総省がAnthropicとの関係解消を検討 - GIGAZINE

「AIに核兵器を作らせない仕組み」をAnthropicが開発 - GIGAZINE

OpenAIのミッションが徐々に変化してついに「安全に」という言葉まで削除されたとの指摘 - GIGAZINE

・関連コンテンツ

in AI, サイエンス, セキュリティ, Posted by log1h_ik

You can read the machine translated English article Over 100 scientists propose framework to….