Google I/Oで示された「GoogleのAI活用」まとめ、AIは日常生活の問題をどれだけ解決しているのか?

Googleの開発者向けイベント「Google I/O 2018」が2018年5月8日~10日まで開催されています。今回のGoogle I/Oの目玉は「AI」にあり、数多くの新機能が発表されました。Googleアシスタントが人間の替わりにお店に電話する「Google Duplex」など、GoogleのAIが解決してきた数々の問題が、Googleの公式ブログでまとめられています。

Solving problems with AI for everyone

https://www.blog.google/topics/innovation-technology/io18-overview/

◆現実世界の問題を解決する

GoogleのAI技術は医療分野の可能性も開いています。2016年に糖尿病の合併症として起こる糖尿病網膜症をディープラーニングによる画像認識処理で検出可能にしたGoogleは、同様の技術を利用して心疾患を予測できるようになったと2018年2月に発表しました。

目をスキャンするだけで心疾患を予測できる技術をGoogleの研究者らが発表 - GIGAZINE

また、GoogleのAI技術が解決しているこのほかの重要な問題の1つとして「アクセシビリティ」が挙げられます。多くの人、特に聴力に問題を抱える人は、テレビの中で複数の人が話している様子についていけなくなることがあります。しかし、Googleの研究者は、複数の人の声が混ざっている時に特定の声を抜き出すという技術を開発。「Looking to Listen」と呼ばれるこの技術によって、より多くの人が情報にアクセスしやすくなりました。

Looking to Listenがどのようなものなのかは、以下のムービーから確認できます。

Looking to Listen: Noisy cafeteria - YouTube

そして新たにGoogle I/Oでは「アクセシビリティの向上」につながった事例が公開されました。手を動かせないTania Finlaysonさんは、頭でモールス信号を打ち込むことで人とコミュニケーションをスムーズに取ることができるようになりました。子どもの頃からさまざまなコミュニケーションツールを利用してきたFinlaysonさんですが、モールス信号を頭で打ち込むという方法によって「自由を手に入れた」と感じているとのこと。

Tania’s Story: Morse code meets machine learning - YouTube

また、Googleは周囲の環境を検知して物体の存在を知らせたり、文字を読んだりしてくれるアプリ「Lookout」も発表しています。

Googleが視覚障害者の代わりに「目」となって周囲の情報を的確に伝えてくれるアプリ「Lookout」を発表 - GIGAZINE

◆Gmail、Photos、Googleアシスタントで時間を節約する

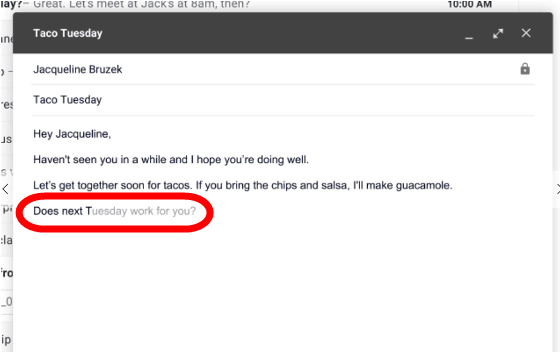

Google I/Oで発表されたGmailの新機能「Smart Compose」は、AIのサポートによってメール入力の効率を上げるというもの。受信したメールの内容に対して「返信案」を提示してくれるスマートリプライ機能は既に実装されていましたが、Smart Composeは、より複雑な文章が入力候補として提示されるようになっています。

以下の画像をクリックすると、Smart Composeがどのように機能するのかをGIFアニメで見ることができます。

また、Googleフォトは1タップで画像を明るくできたり、より簡単に共有が行えるよう改良が加えられました。

この他、Googleフォトの新機能は以下の記事から読むことができます。

Googleフォトに「白黒写真に色を付ける」機能が搭載される予定 - GIGAZINE

「時間の節約」として特に大きな役目を果たしているのがGoogleアシスタント。2016年に登場したGoogleアシスタントは、今回のGoogle I/Oで、より視覚的になり、より自然な会話を行え、より便利になったと伝えられています。ブログによると、近いうちに「Hey Google」というかけ声なしでGoogleアシスタントを使えるようになるとのこと。また、声の種類も豊富になり、これには歌手のジョン・レジェンドの声も含まれているそうです。

より視覚的に進化したGoogleアシスタントとは、Googleアシスタントを搭載した「Smart Display」が2018年7月に発売されることを示している模様。また、GoogleマップのナビゲーションがGoogleアシスタントを通して行われ、ユーザーがスマートフォンを見る必要なく目的地までの案内が行われるようになります。この他、モバイル端末において、音声での問いかけに対して、即座に視覚的な提案を行うようになるとのこと。

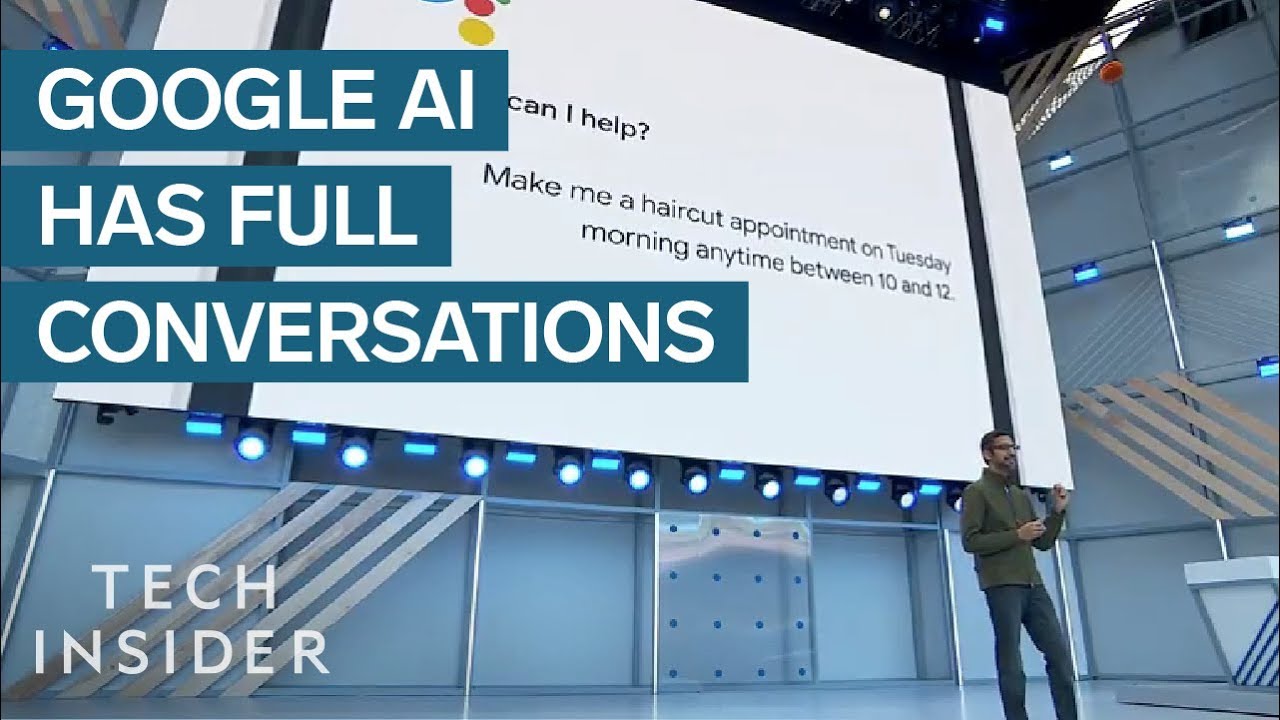

さらに、AIが独立して電話対応できる「Google Duplex」もGoogle I/Oで発表されました。これは人間の時間を節約し、中小企業にとっては非常に大きな価値を生み出すものと見られています。

以下のムービーから、「10時から12時の間に理容室の予約を入れておいて」と指示されたGoogleアシスタントが、まるで人間のようにお店に電話している様子を見ることができます。

New Google AI Can Have Real Life Conversations With Strangers - YouTube

◆GoogleマップとのGoogle Lensの改善

画像を解析してそれが何かを説明してくれる「Google Lens」の新機能として、画像からテキスト部分をコピー&ペーストできる機能が登場。またGoogleマップではレストランの店舗情報が表示される拡張現実機能が新たに紹介されたほか、目的地につくまでに「駐車が容易にできるかどうか」「お店が開いているかどうか」「どのくらい混雑しているかどうか」を教えてくれるようになったとのこと。

Googleマップの新機能の詳細は以下の記事から。

GoogleマップがARナビゲーション機能に対応、カメラをかざすだけでナビが可能に - GIGAZINE

◆ニュース

AIが大きな違いをもたらす分野の1つとして「ニュース」があります。人々は信頼できる情報源を求めているところ、AIを使えば、出来事をさまざまな側面から見た、信頼できるニュースを人々に届けることが可能になるとのこと。新しいGoogle Newsは、ジャーナリストという「人」の手によって作られた最高の情報をAIによって押し出すものとなっています。新しいGoogle Newsでは、表示するニュースのパーソナライズ機能や、1つのテーマを総合的にまとめる機能などが搭載されます。

新しいGoogle Newの詳細は以下の記事から読むことが可能です。

Googleニュースが大リニューアル、AIがニュースを時系列順にまとめてユーザーに合わせてピックアップ - GIGAZINE

◆重要なことに集中できるようにする

スマートフォンの登場により、人々の時間の使い方が大きく変わり、スマートフォンがあるがために手元の作業に集中できないなどの弊害も生まれています。この問題を解決するため、Googleは新たに人々が自分のスマートフォンをどのように使用しているのかを学べ、不必要な時にはスマートフォンと離れられるようにする機能をリリース。Android Pではスマートフォンの画面を下に向けると「Do Not Disturb(邪魔しないで)」モードに切り替わり、ホワイトリストに入れた「緊急事態」以外の通知やフィードの音が響かないようにできるようになるとのことです。

このほか、Android PでどのようにAIが利用されているのかは、以下の記事から読むことができます。

AIでスマホをスマートにする次期OS「Android P」パブリックベータ版が登場、新機能まとめ - GIGAZINE

Googleは教育分野にも力を入れており、YouTubeでは「平均的な女子高生」であるMeet Shazaさんがオープンソースの畳み込みニューラルネットワークを利用してアプリをプログラミングしている様子が描かれています。

Shaza’s Story - YouTube

また、絶滅しかけているクジラの研究にも機械学習は使われています。Daniel DeLeon氏は音楽と音の科学に情熱を燃やす人物で、TensorFlowを使ってクジラの声を認識することに成功しました。

Daniel and the Sea of Sound - YouTube

・関連記事

GoogleマップがARナビゲーション機能に対応、カメラをかざすだけでナビが可能に - GIGAZINE

Googleフォトに「白黒写真に色を付ける」機能が搭載される予定 - GIGAZINE

AIでスマホをスマートにする次期OS「Android P」パブリックベータ版が登場、新機能まとめ - GIGAZINE

Googleが視覚障害者の代わりに「目」となって周囲の情報を的確に伝えてくれるアプリ「Lookout」を発表 - GIGAZINE

Googleニュースが大リニューアル、AIがニュースを時系列順にまとめてユーザーに合わせてピックアップ - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, Posted by darkhorse_log

You can read the machine translated English article "Google AI utilization" indicated in Goo….