さまざまなAIをWindowsのローカルPCで動かせる「Run llama.cpp Portable Zip on Intel GPU with IPEX-LLM」がDeepSeekにも対応したことをIntelが発表

近年、高度な生成AIや大規模言語モデルが多数登場していますが、それらを動作させるには高価なGPUなど、相応の機器が必要となります。しかし、Intelが提供するPyTorch用エクステンションの「IPEX-LLM」では、Intel製ディスクリートGPUなどでGemmaやLlamaなどのAIを動作させることが可能です。今回、そんなIPEX-LLMがDeepSeek R1に対応したことをIntelが発表しました。

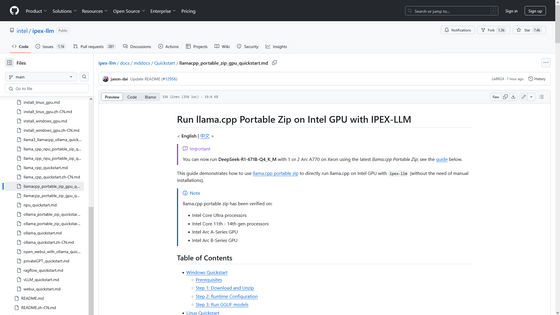

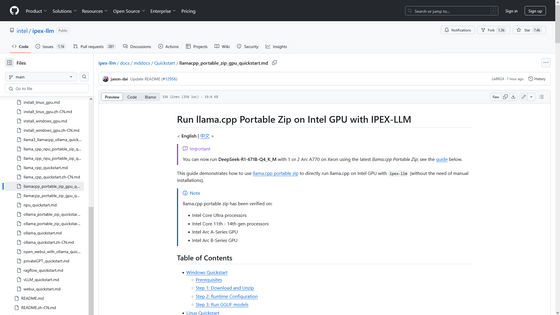

ipex-llm/docs/mddocs/Quickstart/llamacpp_portable_zip_gpu_quickstart.md at main · intel/ipex-llm · GitHub

https://github.com/intel/ipex-llm/blob/main/docs/mddocs/Quickstart/llamacpp_portable_zip_gpu_quickstart.md

IntelがリリースしているIPEX-LLMとは、Intel製CPUやGPUを搭載したPCで最新のAIを動作させることができるというPyTorch用エクステンションです。

今回、IntelはIPEX-LLM上でオープンソースソフトウェアライブラリのllama.cppを基にした「llama.cpp Portable Zip」を使うことで、Intel製GPUでもllama.cppを直接実行できるようになったことを発表しました。これに伴い、llama.cpp Portable ZipでDeepSeek-R1-671B-Q4_K_Mが実行可能になったことを明らかにしています。

IntelはGitHub上で、llama.cpp Portable Zipのインストール方法ならびにllama.cppの実行方法、それぞれのAIの実行方法について、Windows・Linuxといったディストリビューション別に解説しています。

ipex-llm/docs/mddocs/Quickstart/llamacpp_portable_zip_gpu_quickstart.md at main · intel/ipex-llm · GitHub

https://github.com/intel/ipex-llm/blob/main/docs/mddocs/Quickstart/llamacpp_portable_zip_gpu_quickstart.md

なお、Intelはllama.cpp Portable Zipの動作条件として「インテル Core Ultra プロセッサー」「11世代から14世代のCoreプロセッサー」「Intel Arc AシリーズGPU」「Intel Arc BシリーズGPU」を挙げています。また、DeepSeek-R1-671B-Q4_K_Mを動作させるにはプロセッサーに「Intel Xeon」を搭載し、「Arc A770」を1~2台搭載したPCが必要とのことです。

実際にIntelのフェロー兼チーフアーキテクトを務めるジンカン・ダイ氏はllama.cpp Portable Zipを使ってIntel XeonとArc A770でDeepSeek-R1-Q4_K_Mを動作させる様子を公開しています。

これに対し、掲示板サイトのHacker Newsでは「10個程度のトークンを含むプロンプトでは、このデモのように問題は生じません。しかし、コンテキストをさらに増やした場合、コンピューティングのボトルネックがすぐに発生するでしょう」と指摘する声も挙がっていました。

・関連記事

NVIDIA製グラボやAppleチップのAI推論処理能力をまとめた一覧表、どのグラボやMacを買えばいいのかの参考になる - GIGAZINE

NVIDIAが従来のほぼ半額でAI性能が1.7倍になった小型AIボード「Jetson Orin Nano Super」開発者キットを発表 - GIGAZINE

DeepSeek-R1のサイズを最大80%削減した動的量子化モデルが公開中 - GIGAZINE

画像生成AI「Stable Diffusion」をIntel Arcで動かすことに成功 - GIGAZINE

なぜ研究者はローカルPCでAIを実行する必要があるのか? - GIGAZINE

OpenAI o1相当の推論モデル「DeepSeek R1」を中国AI企業が商用利用や改変が可能なMITライセンスでリリース - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1r_ut

You can read the machine translated English article Intel announces that 'Run llama.cpp Port….