2024年にAI分野で何が起きていたのか振り返り、2023年に市場を席捲したGPT-4を上回るAIモデルが多数登場しコンテキストウィンドウの拡張やマルチモーダルモデルが一般化して価格も急落

元Eventbriteのエンジニアリングディレクターであり、オープンソースツール・Datasetteの開発者でもあるサイモン・ウィリソン氏が、2024年に人工知能(AI)分野で起きた出来事をまとめています。

Things we learned about LLMs in 2024

https://simonwillison.net/2024/Dec/31/llms-in-2024/

◆GPT-4の壁が完全に破られる

2023年3月に公開されたOpenAIの大規模言語モデル(LLM)「GPT-4」は、同年の12月時点では最も優れたパフォーマンスを示すAIモデルでした。しかし、2024年の終わりにはオリジナルのGPT-4よりも優れたパフォーマンスを発揮するAIモデルが多数登場しています。

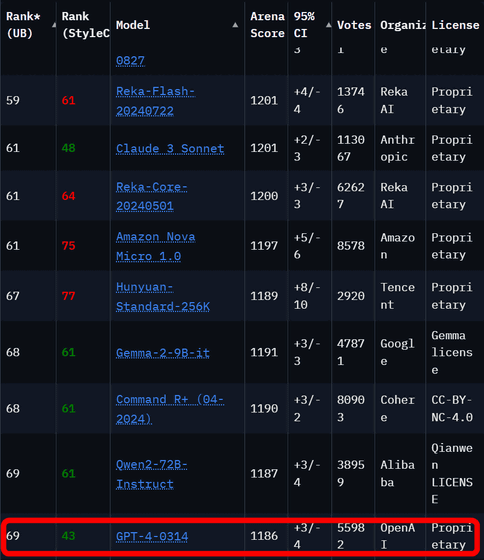

LLMのパフォーマンスを比較するためのオープンソースAIベンチマークであるChatbot Arenaによると、記事作成時点でオリジナルのGPT-4以上のランクのAIモデルが70も存在します。

オリジナルのGPT-4よりも優れたパフォーマンスを示したAIモデルのうち、最も古くにリリースされたのはGoogleのGemini 1.5 Pro(2024年2月発表)です。Gemini 1.5 ProはオリジナルのGPT-4と同等の出力を生成可能であるのに加えて、一度に処理可能なトークン数(コンテキストウィンドウ)が100万トークンで、動画入力機能も備えています。

GoogleがGemini 1.5をリリース、最大100万トークンを処理できて1時間のムービーや70万語のテキストを扱うことが可能 - GIGAZINE

Gemini 1.5 Proは2024年の主要テーマのひとつである「コンテキスト長の増加」も示しているとウィリソン氏は指摘。2023年に登場したAIモデルのコンテキストウィンドウはほとんどが「4096トークン」あるいは「8192トークン」であったのに対して、Anthropicが2023年11月に発表した「Claude 2.1」はコンテキストウィンドウが20万トークン、Gemini 1.5 Proはアップデートにより100万トークンから200万トークンにまで拡張されています。

GoogleがGemini 1.5 Proのアップデートを実施、コンテキストウィンドウを従来の100万トークンから200万トークンに拡張 - GIGAZINE

コンテキストウィンドウの拡張により、AIモデルで解決できる問題の範囲が劇的に広がり、本を丸ごと1冊入力してその内容を要約したり、内容について質問したりすることが可能になります。また、AIモデルでコーディング問題を正しく解決できるようになり、大量のサンプルコードを入力することが可能となりました。「長い入力を伴うAIモデルの使用例は、AIモデルの重みにすでに組み込まれている情報だけに依存する短いプロンプトよりもはるかに興味深いものです。私のツールの多くは、このパターンを使用して構築されました」とウィリソン氏は記しています。

Anthropicが2024年3月にリリースした「Claude 3」は、複数のベンチマークテストでGPT-4のパフォーマンスを上回っており、ウィリソン氏は「すぐに私のお気に入りの日常使いのAIモデルになった」と記しました。

GPT-4を上回る性能で画像と文章を同時に処理できる日本語対応マルチモーダルAI「Claude 3」がリリースされる - GIGAZINE

さらに、2024年6月には「Claude 3.5 Sonnet」が発表され、さらに高いパフォーマンスを実現しています。

AnthropicがClaude 3.5 Sonnetを突如発表、ベンチマーク結果はGPT-4oに匹敵 - GIGAZINE

なお、Chatbot ArenaでオリジナルのGPT-4よりも高いパフォーマンスを示したAIモデルを保有しているAI組織は、Google、OpenAI、Alibaba、Anthropic、Meta、Reka AI、01 AI、Amazon、Cohere、DeepSeek、NVIDIA、Mistral、NexusFlow、Zhipu AI、xAI、AI21 Labs、Princeton、Tencentです。

◆GPT-4の一部モデルはノートPCで動作可能

ウィリソン氏は2023年生のM2搭載MacBook Proのメモリ(RAM)64GBモデルを使用しているそうです。M2搭載MacBook ProはハイパフォーマンスなノートPCではあるものの、2022年に登場したモデルである点を理解する必要があります。そんなM2搭載MacBook Proは、GPT-3と同等のAIモデルを何とか実行できるレベルだったそうですが、2024年末の時点ではGPT-4と同等のAIモデルを実行できるようになっているそうです。

これについて、ウィリソン氏は「これは私にとっていまだに驚きです。GPT-4の機能と出力品質を備えたモデルには、4万ドル(約630万円)以上のGPUを搭載したデータセンタークラスのサーバーがひとつ以上必要だと考えていました。しかし、実際には64GBのRAMを搭載したノートPCでこれらを実行することができます。ただし、RAMの大部分を占めるため、頻繁に実行することはできず、他の用途にノートPCを利用する余裕もほとんどありません。これらが実行できるという事実は、過去1年間で解明されてきたトレーニングと推論パフォーマンスの驚異的な向上の証です。AIモデルの効率性という点では、簡単に達成できる成果がたくさんあることがわかりました。今後もさらに成果が出てくると期待しています」と記しました。

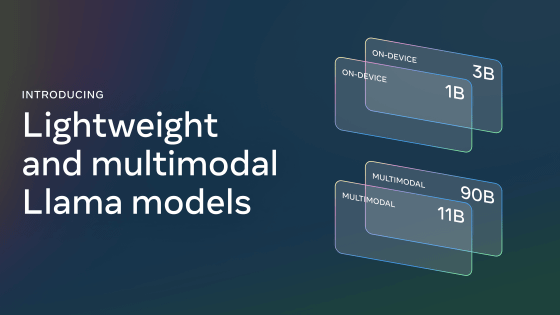

中でも特筆すべきなのが、Metaが2024年9月に公開した「Llama 3.2」です。Llama 3.2には複数のモデルが存在しますが、スマートフォンでのローカル実行が可能な小規模モデルも存在します。

Metaが「Llama 3.2」を公開、画像認識性能が向上&スマホ特化の小型版もあり - GIGAZINE

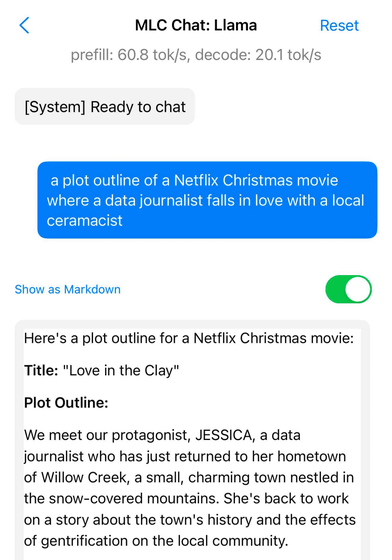

Llama 3.2の小規模モデルについて、「2GB未満と非常にデータサイズが小さいにもかかわらず、これは驚くほど高性能です」とウィリソン氏は記しており、「データジャーナリストが地元の陶芸家に恋をするNetflixのクリスマス映画のあらすじ」を尋ねた際の出力を提示し、そのパフォーマンスの高さを称賛しています。

◆競争と効率性の向上によりLLMの価格が急落

2023年12月当時、OpenAIは入力100万トークン当たりGPT-4では「30ドル(約4730円)」、GPT-4 Turboでは「10ドル(約1580円)」、GPT-3.5 Turboでは「1ドル(約158円)」という料金を請求していました。

しかし、記事作成時点でOpenAIは最も高価なAIモデルであるo1では「30ドル」、GPT-4oでは「2.5ドル(約394円)」、GPT-4o miniでは「0.15ドル(約24円)」という料金を課しています。

他のAIモデルの利用料金はより安くなっています。入力100万トークン当たりの利用料は、AnthropicのClaude 3 Haikuが「0.25ドル(約39円)」、GoogleのGemini 1.5 Flashが「0.075ドル(約12円)」、Gemini 1.5 Flash 8Bは「0.0375ドル(約6円)」です。

ウィリソン氏はAIモデルの価格低下について、「AIモデルの価格低下は競争の激化と効率性の向上という2つの要因によって推進されています。効率性は、LLMの環境への影響を懸念するすべての人にとって非常に重要です。この価格低下は、プロンプトの実行にどれだけのエネルギーが使用されているかに直接関係しています。大規模なAIデータセンターの構築による環境への影響については依然として懸念すべき点が山積していますが、個々のプロンプトのエネルギーコストに関する懸念の多くはもはや信用できません」と記しました。

ウィリソン氏は自身が所有する6万8000枚の写真のすべてに簡単な説明文をつけるのにGemini 1.5 Flash 8Bを利用する場合、どれくらいの費用がかかるかを計算しています。この処理に必要な費用はわずか「1.68ドル(約265円)」であったため、ウィリソン氏は「この計算が正しいか確認するのに、3回も計算した」と記しています。

なお、ウィリソン氏がGemini 1.5 Flash 8Bに簡単な説明文を出力させた画像と、出力された説明文の事例が以下。

浅い皿はおそらくハチドリかチョウの餌箱で、赤色です。皿の中にはオレンジ色の果物のスライスが見えます。給餌器には2匹のチョウがいます。1匹は白あるいはクリーム色の模様がある濃い茶色あるいは黒色のチョウです。もう1匹は、明るい茶色、ベージュ、黒の模様があり、目玉模様が目立つ茶色の大きなチョウです。そして茶色の大きなチョウが果物を食べているようです。

「この効率性の向上と価格の低下こそが、2024年のAI分野のトレンドの中でも私が特にお気に入りと感じるものです」とウィリソン氏は記しています。

◆マルチモーダルモデルが一般化

2024年にはほぼすべての主要なAI企業がマルチモーダルモデルをリリースしました。2024年3月にAnthropicがClaude 3シリーズ、 4月にGoogleがGemini 1.5 Pro、9月にはMistralがPixtral 12B、MetaがLlama 3.2、11月にはHugging FaceがSmolVLM、12月にはAmazonがAmazon Novaをリリースしています。

AmazonがAWS上で利用可能なマルチモーダル生成AIモデル「Amazon Nova」を発表 - GIGAZINE

ウィリソン氏は「LLMの改善が遅れていると不満を言う人は、マルチモーダルモデルの大きな進歩を見逃していることが多いと思います。画像・音声・動画に対して、プロンプトで実行できることはこれらのモデルを適用する魅力的な新しい方法です」と記しました。

◆プロンプト駆動型のアプリ生成はすでにコモディティ化されている

LLMが驚くほどコードを書くのが得意であることはすでに明らかになっています。適切な指示を与えれば、HTML・CSS・JavaScriptを使用して、完全なインタラクティブアプリケーションを、多くの場合一度の指示で構築可能です。

AnthropicはClaude 3.5 Sonnetの「Artifacts」と呼ばれる機能でAIによるコンテンツ制作能力を十分に示しており、同機能を使うことでインタラクティブアプリケーションを作成したり、それをClaudeのインターフェイス内で直接使用したりすることが可能です。

なお、Artifactsを使ってどのようなアプリケーションが制作できるのかは、以下の記事を読めばわかります。

Claude 3.5 Sonnetでインタラクティブなシングルページアプリを作成できる機能「Artifacts」で作成されたアプリの例まとめ - GIGAZINE

◆Apple Intelligenceは悪いが、AppleのMLXライブラリは優れている

Appleは2023年12月に自社製プロセッサであるAppleシリコン用の機械学習フレームワーク「MLX」を発表しました。これはMac上でさまざまなLLMを動作させるのに役立つものであり、ウィリソン氏は「本当のブレークスルーであり、素晴らしい」と述べました。

Appleの機械学習チームがAppleシリコンで機械学習モデルをトレーニング・デプロイするためのフレームワーク「MLX」をGitHubで公開 - GIGAZINE

しかし、AppleがリリースしたパーソナルAIの「Apple Intelligence」については、「ほとんど期待外れ」と言及。ウィリソン氏は「LLMのパワーユーザーとして、私はこれらのAIモデルの能力をよく知っています。AppleのLLM機能は最先端のLLMの機能に見劣りする模倣に過ぎません。また、ニュースの見出しを誤って伝えたり、まったく役に立たない文章作成支援ツールを提供したりします。Genmojiはなかなか楽しいですが」と述べ、Apple Intelligenceを痛烈に批判しました。

なお、Apple Intelligenceがニュースの見出しを誤って伝えた件については、以下の記事にまとめられています。

Apple Intelligenceが「医療保険会社のCEOを殺害した犯人が自殺とBBCが報道」と誤通知しBBCがAppleに猛抗議、Apple Intelligenceの要約機能が生み出した虚偽の情報 - GIGAZINE

◆記事作成時点で入手可能な最高のLLMは中国で600万ドル(約9億4600万円)未満でトレーニングされたものなのか?

中国のAI企業であるDeepSeekは、2024年12月末にパラメーターサイズが6710億のAIモデル「DeepSeek-V3」をリリースしました。これは記事作成時点で利用可能なオープンライセンスモデルの中で最大のパラメーターサイズを持ったAIモデルです。ベンチマークテストではClaude 3.5 Sonnetと同等と評価されており、Chatbot ArenaではGemini 2.0やOpenAIのGPT-4oやo1のすぐ後ろの7位にランクインしています。このパフォーマンスは、オープンライセンスモデルの中では最も高いものです。

中国のAI企業・DeepSeekがGPT-4oに匹敵するAIモデル「DeepSeek-V3」をリリース、パラメーター数は脅威の6710億個 - GIGAZINE

DeepSeek-V3の素晴らしい点はトレーニングコストが圧倒的に安いという点にあります。DeepSeek-V3のトレーニングコストは推定557万6000ドル(約8億7900万円)で、NVIDIAのH800というGPUを使って278万8000時間かけてトレーニングされています。これについて、ウィリソン氏は「アメリカ政府による中国へのGPUの輸出規制は、効果的なトレーニングの最適化に影響を与えたようです」と記しました。

・関連記事

GoogleがGemini 1.5をリリース、最大100万トークンを処理できて1時間のムービーや70万語のテキストを扱うことが可能 - GIGAZINE

GoogleがGemini 1.5 Proの一般プレビューを開始、音声理解・システム命令・JSONモードなどの新機能を搭載 - GIGAZINE

GoogleがGemini 1.5 Proのアップデートを実施、コンテキストウィンドウを従来の100万トークンから200万トークンに拡張 - GIGAZINE

Anthropicが大規模言語モデル「Claude 2.1」をリリース、最大20万トークン・15万ワードを読込可能で幻覚が半減し新しいAPI統合などを提供 - GIGAZINE

GPT-4を上回る性能で画像と文章を同時に処理できる日本語対応マルチモーダルAI「Claude 3」がリリースされる - GIGAZINE

AnthropicがClaude 3.5 Sonnetを突如発表、ベンチマーク結果はGPT-4oに匹敵 - GIGAZINE

Claude 3.5 Sonnetでインタラクティブなシングルページアプリを作成できる機能「Artifacts」で作成されたアプリの例まとめ - GIGAZINE

Metaが「Llama 3.2」を公開、画像認識性能が向上&スマホ特化の小型版もあり - GIGAZINE

AmazonがAWS上で利用可能なマルチモーダル生成AIモデル「Amazon Nova」を発表 - GIGAZINE

Mistralが初のマルチモーダルAIモデル「Pixtral 12B」リリース、GitHub・Hugging Face・APIサービスプラットフォームLe Chat・Le Platforme経由で利用可能 - GIGAZINE

Appleの機械学習チームがAppleシリコンで機械学習モデルをトレーニング・デプロイするためのフレームワーク「MLX」をGitHubで公開 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by logu_ii

You can read the machine translated English article Looking back at what was happening in th….