AlibabaのQwenチームが画像を認識できるオープンウェイトAIモデル「QVQ」をリリース

Alibabaの大規模言語モデル「Qwen」の研究チームが、視覚的推論機能の強化に重点を置いた実験的研究モデルとして「QVQ-72B-Preview」を公開しました。

QVQ: To See the World with Wisdom | Qwen

https://qwenlm.github.io/blog/qvq-72b-preview/

Qwen/QVQ-72B-Preview · Hugging Face

https://huggingface.co/Qwen/QVQ-72B-Preview

QVQ-72B-PreviewはQwen2-VL-72Bをベースに視覚的推論能力を強化したモデルです。元となったQwen2-VL-72Bは2024年9月にリリースされたモデルで、動画を理解したり多言語を使用したりする能力がありました。

Alibabaが新AIモデル「Qwen2-VL」をリリース、20分を超えるビデオを分析し内容についての質問に要約して回答可能 - GIGAZINE

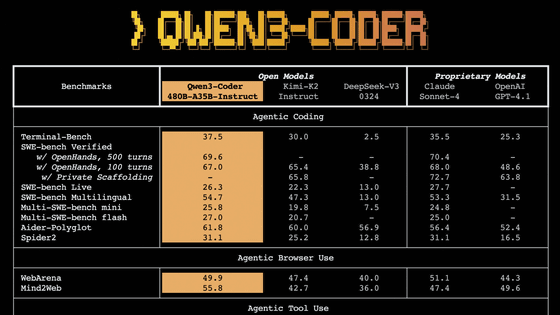

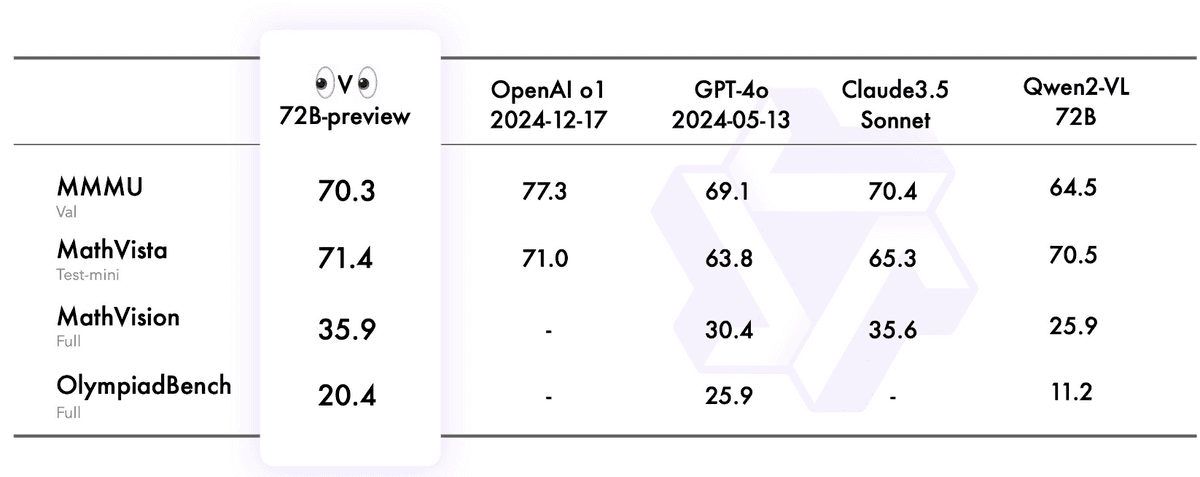

QVQ-72B-Previewのベンチマーク結果は下図の通り。モデルの視覚関連の総合的な理解と推論能力を評価する「MMMU」ベンチマークで前モデルのQwen2-VLを大幅に上回り、最先端モデルであるOpenAIのo1モデルとの差を縮めています。また、数学や物理学の能力を測るその他3つのベンチマークでもQwen2-VLから大きくスコアを伸ばしました。

なお、研究チームは「QvQ-72B-Previewは実験的研究モデルである」と述べ、記事作成時点では前のQwen2-VLモデルで可能だった動画の入力が不可能なほか、実用化の際に問題になりそうな点を以下の通り指摘しています。

・応答の際に複数の言語が混じる事がある

・推論中に循環的な論理パターンに陥り、結論を出す事なく冗長な応答を生成する場合がある

・セキュリティと信頼性を確保するためには別途安全対策が必要

・複数ステップの視覚的推論中に画像コンテンツへの焦点を失って幻覚を引き起こす場合がある

Hugging Face上にてQvQ-72B-Previewのデモが実行可能になっており、エンジニアのサイモン・ウィリソン氏が早速試してみて結果をブログで報告しています。

ウィリソン氏が試したプロンプトのうち、うまくいったのは下図のペリカンの画像を見せて「何羽いるか数えて」というものでした。

QVQ-72B-Previewの返答を日本語に翻訳すると以下の通り。ちゃんと数を数えられているほか、画面端に少しだけ映り込んでいるペリカンにも言及できています。

ペリカンの写真があり、数えなければなりません。ちょっと考えてみましょう... まず、ペリカンは大きなくちばしを持つ大きな鳥だということは知っていますよね?

[中略]

もう一度、今度はもっと注意深く数えてみましょう。左から始めます。

1. 最初のペリカンは正面に立っていて、完全に視認可能です。

2. その後ろ、少し右に2羽目のペリカンがいます。

3. そして、さらに後ろには3羽目のペリカンがいます。

4. そしてその隣に4羽目のペリカンがいます。

つまり、ペリカンは全部で4羽です。しかし、画像の右端に別の鳥の一部、おそらくペリカンの背中か尾羽が写っていますが、フレーム内に完全に収まっていないので、ペリカン全体として数えるべきではないと思います。

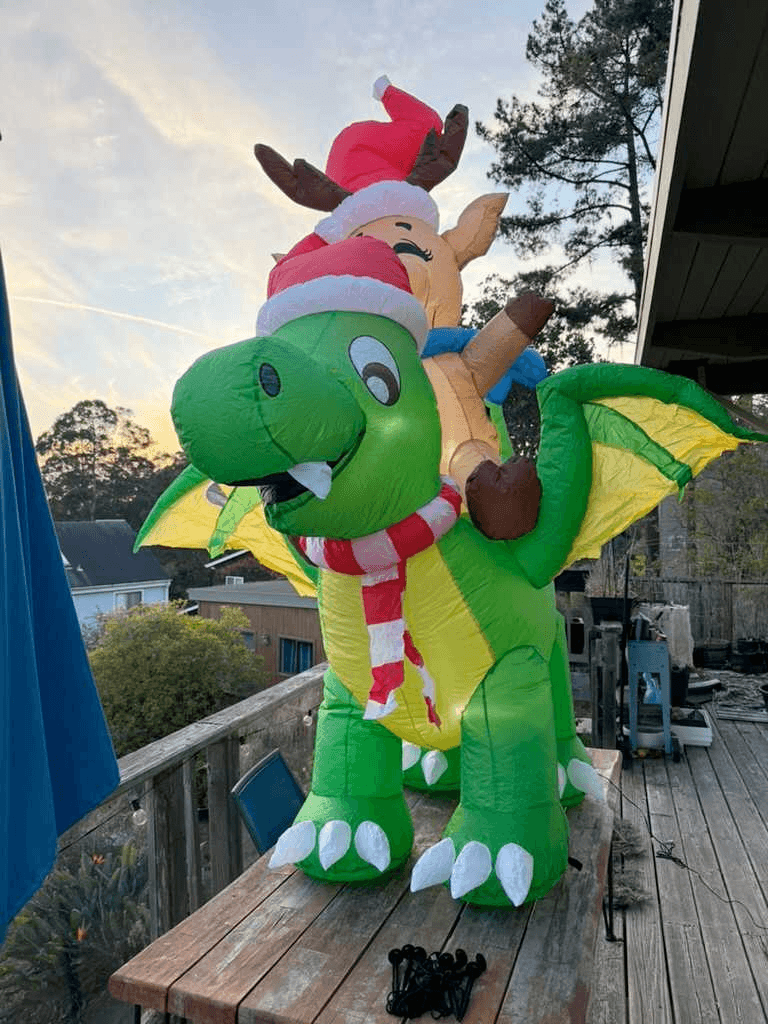

その他、ウィリソン氏は面白かった回答として、下図の画像を見せて「恐竜の高さを推測して」と指示した際の結果について言及しました。

QVQ-72B-Previewは「自分の身長は5フィート10インチ(約178cm)だ」と述べた上で、「自分よりも高いので8フィート(約244cm)から9フィート(約274cm)くらいではないか」と推定しました。ウィリソン氏は「どうやって自分の身長を決めたのか不思議です」とコメントしています。

・関連記事

AlibabaのQwenチームがOpenAI o1に匹敵する推論モデル「QwQ-32B-Preview」を発表、数学や科学的推論において優れた性能を発揮 - GIGAZINE

オープンソースのコーディング支援AI「Qwen2.5-Coder」シリーズの性能はGPT-4oに匹敵、64GBのRAM&M2搭載MacBook Proでもローカル実行可能 - GIGAZINE

なぜ研究者はローカルPCでAIを実行する必要があるのか? - GIGAZINE

完全にオープンで再現可能な大規模言語モデル「OpenCoder」がリリースされる - GIGAZINE

AIツールの次のレベル「AIエージェント」とは何なのか専門家が解説 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1d_ts

You can read the machine translated English article Alibaba's Qwen team releases 'QVQ', ….