Mistral AIがデバイス向け小規模モデル「Ministral 3B」「Ministral 8B」をリリース

AIスタートアップのMistral AIが、パラメーター数100億以下の小規模な言語モデル「Ministral 3B」と「Ministral 8B」を発表しました。Misrtal AIはこの2モデルをまとめて「les Ministraux」と呼んでいます。

Un Ministral, des Ministraux | Mistral AI | Frontier AI in your hands

https://mistral.ai/news/ministraux/

大規模言語モデルはサイズが大きく必要スペックも高くなるため、スマートフォンやノートPCといったモバイル端末でのローカル動作には向いていません。そこで、さまざまなAI企業はパラメーター数が数十億程度の小規模言語モデルの開発を進めています。

今回発表されたLes Ministrauxは2モデルともパラメーター数100億以下の小規模言語モデルで、デバイス上でのローカル動作を想定しているとのこと。どちらのモデルも最大128kのコンテキスト長をサポートしており、さらにMinistral 8Bにはより高速でメモリ効率が高くなるような設計が採用されています。

Mistral AIはLes Ministrauxについて、「これらのモデルは、パラメーター数100億以下のモデルにおける知識、常識、推論、関数呼び出し、効率性において新たなフロンティアを設定し、エージェントワークフローのオーケストレーションから専門的なタスクワーカーの作成まで、様々な用途に使用またはチューニングすることができます」と述べています。

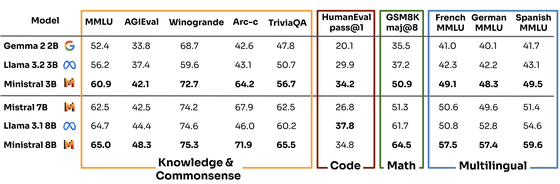

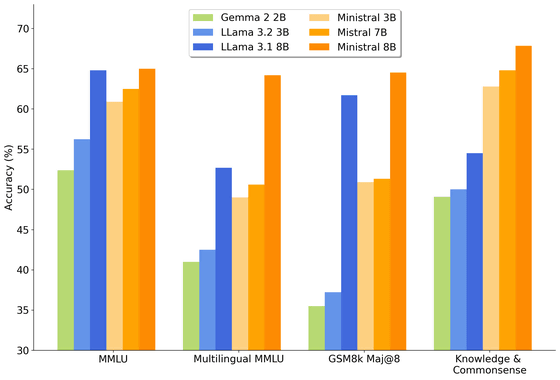

Les Ministrauxの2モデルと、GoogleのGemma 2 2B、Llama 3.2 3B、Llama 3.1 8B、Mistral 7Bを複数カテゴリのパフォーマンスで比較したベンチマークスコアが以下.

Ministral 3BとMinistral 8Bの両モデルとも、他の同規模の言語モデルより優れたスコアをたたき出しているとMistral AIはアピールしています。

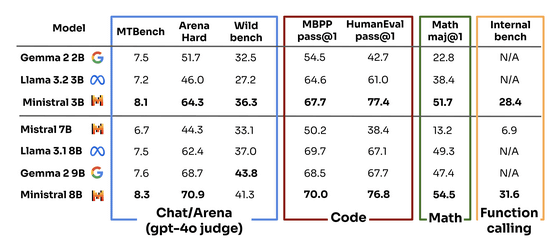

Gemma 2 2B、Llama 3.2 3B、Llama 3.1 8B、Ministral 3B、Ministral 7B、Mistral 8Bで精度を比較したものが以下。

Ministral 3BとMinistral 8Bは2024年10月16日から有償で提供されており、Ministral 3Bが100万トークンにつき0.04ドル(約6円)、Ministral 8Bが100万トークンにつき0.1ドル(約15円)となっています。

また、Ministral 8BのInstruct(指示学習型)のモデルの重みは研究目的で利用可能で、以下で公開されています。

mistralai/Ministral-8B-Instruct-2410 · Hugging Face

https://huggingface.co/mistralai/Ministral-8B-Instruct-2410

・関連記事

TransformerとMamba2のハイブリッドとなる小規模言語モデル「Zamba2-7B」が公開される - GIGAZINE

MicrosoftがすべてのCopilot+ PC用言語モデル「Phi-Silica」一般提供を発表 - GIGAZINE

Microsoftがコスト効率の高い小さめの言語モデル「Phi-3」をリリース、オープンモデルで商用利用可能 - GIGAZINE

Metaの大規模言語モデル「LLaMA」をM1搭載Macで実行可能にした「llama.cpp」がアップデートによりわずか6GB未満のメモリ使用量で実行可能に - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Mistral AI releases small-scale device m….