MicrosoftがすべてのCopilot+ PC用言語モデル「Phi-Silica」一般提供を発表

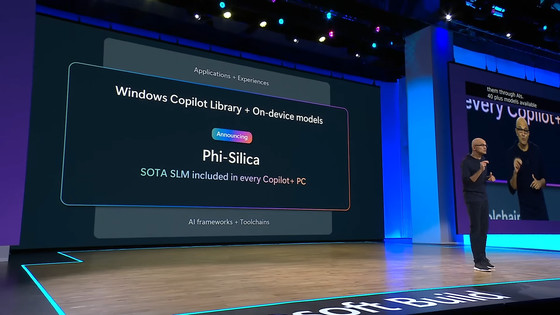

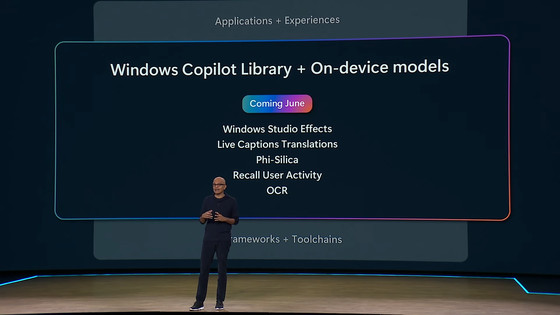

Microsoftが2024年5月21日に開催された開発者向け年次カンファレンス「Microsoft Build 2024」の基調講演で、AI特化のPC「Copilot+ PC」に搭載されたNPU上でローカルに動作する小規模言語モデル「Phi-Silica」をはじめとする40以上のAPIを発表しました。

New models added to the Phi-3 family, available on Microsoft Azure | Microsoft Azure Blog

https://azure.microsoft.com/en-us/blog/new-models-added-to-the-phi-3-family-available-on-microsoft-azure/

NVIDIA Collaborates With Microsoft to Help Developers Build, Deploy AI Applications Faster | NVIDIA Blog

https://blogs.nvidia.com/blog/microsoft-build-optimized-ai-developers/

基調講演の様子は以下から見ることが可能です。

Full Keynote: Satya Nadella at Microsoft Build 2024 - YouTube

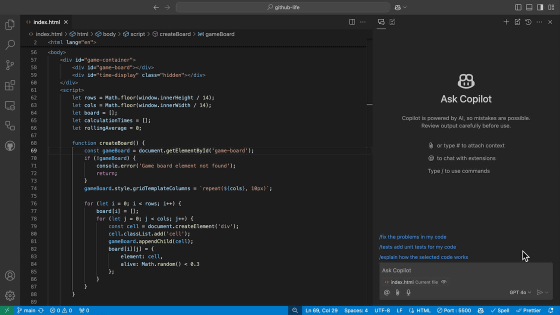

Microsoftのサティア・ナデラCEOは基調講演で「Windowsを、AIアプリを構築できる最適なプラットフォームにするためのツール」として、「Windows Copilot Library」を発表しました。ナデラCEOによれば、このWindows Copilot LibraryはWindowsですぐに使用できるローカルAPIをまとめたライブラリとなっており、Phi-Silicaはその中に含まれるAIモデルの1つだそうです。

Phi-Silicaは、Microsoftの言語モデルである「Phi」ファミリーの1つで、パラメーター数33億と最も小さい規模のモデルとなっています。さらに、Phi-SilicaはCopilot+ PCのNPUに最適化されており、ローカルで実行できるとのこと。

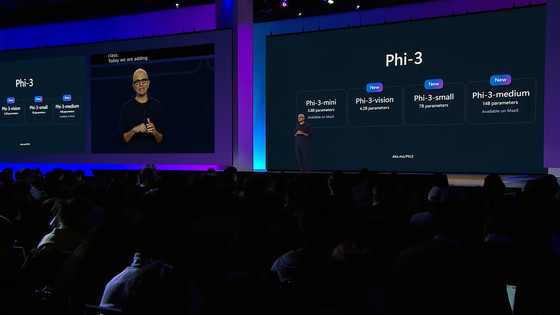

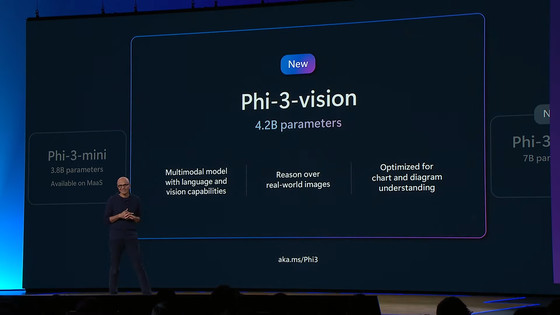

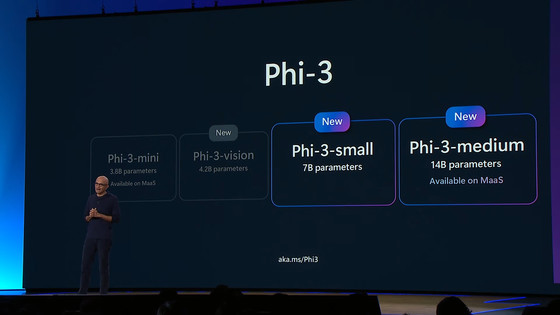

さらに、ナデラCEOはPhiファミリーに「Phi-3-vision」「Phi-3-small」「Phi-3-midium」という3つのモデルを新しく追加したことを発表しました。

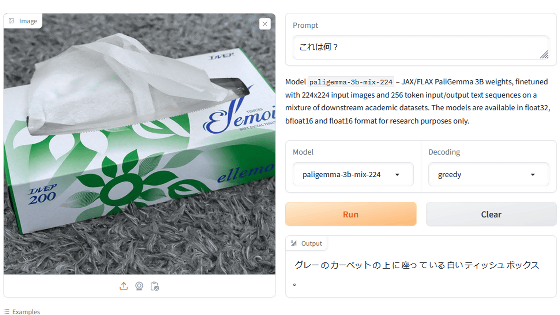

この中でも、Phi-3-visionはパラメーター数42億というコンパクトな規模でありながら、画像も認識できるマルチモーダルなAIモデルとなっています。

新しく追加されたPhi-3の3モデルは、いずれもMicrosoft Azureで利用可能となっています。

そして、MicrosoftはNVIDIAと提携し、NVIDIAの推論マイクロサービス「NVIDIA NIM」にもPhi-3の新しいモデル3つを提供すると発表しました。これらのモデルはすべてNVIDIA TensorRT-LLMで最適化されており、ai.nvidia.comあるいはAzure MarketplaceのNVIDIA AI Enterpriseを通じて入手可能です。

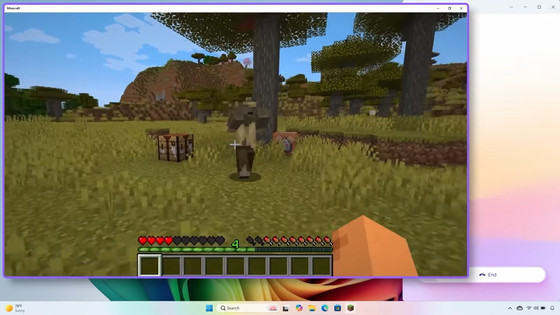

また、ナデラCEOはOpenAIのGPT-4oのサポートをAzure AI Studioに追加することを発表。基調講演では、ゲーム「マインクラフト」の画面をGPT-4oに認識してもらい、GPT-4oと会話しながらプレイする様子が公開されました。

さらに、MicrosoftとオンラインAIプラットフォームのHugging Faceとのパートナーシップが拡大され、テキスト埋め込み推論をAzure AI Studioに直接導入できるようにすることも発表されました。

・関連記事

Microsoftが「Copilot+ PC」発表、Armプロセッサ「Snapdragon X Elite」搭載でAIをローカル実行できる - GIGAZINE

Microsoftが「第11世代Surface Pro」と「第7世代Surface Laptop」を発表、Snapdragon X Elite/Plus搭載でAI処理に最適 - GIGAZINE

WindowsのAI機能をローカル実行できる「Copilot+ PC」がAcer・ASUS・Dell・HP・Lenovo・Samsungから一斉に登場 - GIGAZINE

MicrosoftがWindows 11の新AI機能「Recall」を発表、PCで見たもの行ったことをすべて記録しあとから検索できるパワフルすぎるAI検索機能 - GIGAZINE

MicrosoftがWindows搭載AI PCの最小システム要件を正式発表 - GIGAZINE

Intelの次世代プロセッサ「Lunar Lake」は「x86の根本を覆す電力効率」「前世代の3倍以上のAI性能」を備え各種AIをローカルで実行可能 - GIGAZINE

・関連コンテンツ

in AI, 動画, ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Microsoft Announces General Availability….