101言語に対応したオープンソースの大規模言語モデル「Aya」をCohere for AIがリリース

大規模言語モデル(LLM)のほとんどは、主に英語と中国語のデータでトレーニングされています。そのため、それ以外の言語数千種類については文章生成の精度が落ちてしまうという問題があります。スタートアップ企業・Cohereの非営利研究組織であるCohere for AIがリリースしたLLM「Aya」は119カ国の研究者のべ3000人が参加したプロジェクトで開発され、既存のオープンソースLLMの2倍以上の言語をカバーしているとのことです。

Cohere For AI Launches Aya, an LLM Covering More Than 100 Languages

https://txt.cohere.com/aya/

Aya | Cohere For AI

https://cohere.com/research/aya?ref=txt.cohere.com

Cohere for AIは「LLMやAIが世界的な技術情勢を変革しつつある中で、世界中の多くのコミュニティが既存モデルの言語制限によってサポートされないままです。このギャップは世界中のユーザーに対する生成AIの適用性と有用性を妨げており、これまでの技術開発の波からすでに存在している既存の格差をさらに拡大する可能性があります」と述べています。

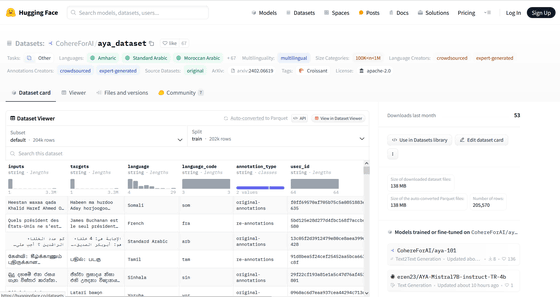

Cohere for AIが用意したデータセットは、100以上の言語に機械翻訳されたデータを含んでいます。その言語の半数はアゼルバイジャン語やベンバ語、ウェールズ語、グジャラート語など、既存のテキストデータセットでは十分学習できないとされている言語です。

さらに、67言語については、流ちょうな話者がアノテーションを付けた約20万4000種類のプロンプトと結果により、文化的なニュアンスや文脈を捉えようとするデータセットも作成されたとのこと。

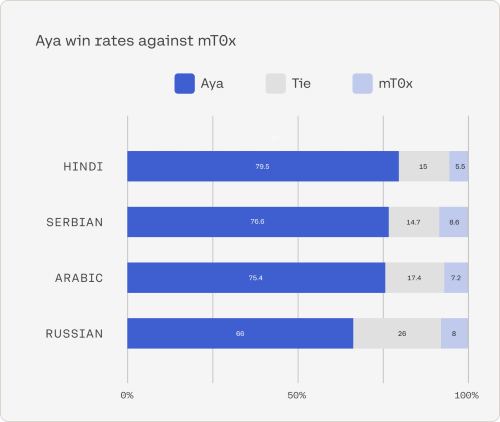

Cohere for AIによれば、ベンチマークテストでAyaのパフォーマンスはmt0やbloomzを大きく上回り、他の主要なオープンソースモデルに対して人間による評価で常に75%、シミュレーションでの勝率では80~90%のスコアを叩き出したとのこと。以下はヒンドゥー語・セルビア語・アラビア語・ロシア語で、Aya(青色)とmt0(水色)のパフォーマンス比較の勝率を示したグラフ。灰色はパフォーマンス同等で引き分けを意味します。

さらに、Ayaはソマリア語やウズベク語など、これまで他のLLMでは未対応だった50以上の言語をカバーしているとCohere for AIはアピールしています。

Cohereの研究担当ヴァイスプレジデントでCohere for AIのリーダーでもあるサラ・フッカー氏は、IT系ニュースサイトのVenture Beatに対して「発足当時はどれだけ巨大なプロジェクトになるのかはまったくわかっていませんでしたが、最終的に5億1300万を超えるプロンプトで微調整されたアノテーションがデータセットにつけられました」と語っています。

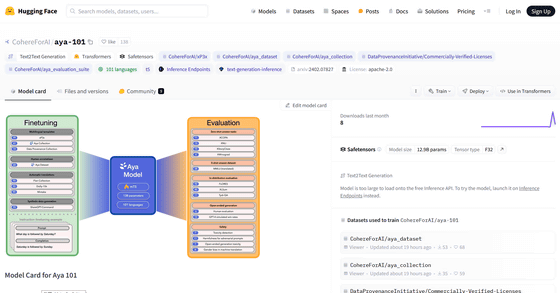

AyaのモデルはApache License 2.0の下、Hugging Faceのリポジトリにホストされています。

CohereForAI/aya-101 · Hugging Face

https://huggingface.co/CohereForAI/aya-101

また、114言語・5億1300万種類のプロンプトを含むデータセットについてもApache License 2.0の下で、以下のHugging Faceのリポジトリで公開されています。

CohereForAI/aya_dataset · Datasets at Hugging Face

https://huggingface.co/datasets/CohereForAI/aya_dataset

・関連記事

無料のチャットボットAI「Chat With RTX」をNVIDIAがリリース、GeForce RTX GPU搭載PCでローカル動作が可能 - GIGAZINE

Abacus AIがリリースしたオープンソースLLM「Smaug-72B」がHugging FaceのOpen LLM LeaderboardでトップとなりいくつかのベンチマークでGPT-3.5を上回ったことが明らかに - GIGAZINE

ネット上に流出した大規模言語モデルは自社製のものだとAI企業・MistralのCEOが確認 - GIGAZINE

「AIと協力して創作をするべき」と作家が語る理由とは? - GIGAZINE

AppleはiPhone上でAIを実行することを目指しておりiOS 18で「AIを搭載した次世代Siri」をリリースする可能性 - GIGAZINE

Stability AIが新コーディング補助AI「Stable Code 3B」をリリース、少ないパラメーター数ながらMetaの「Code Llama 7B」と同等の性能を発揮 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Cohere for AI releases open source large….