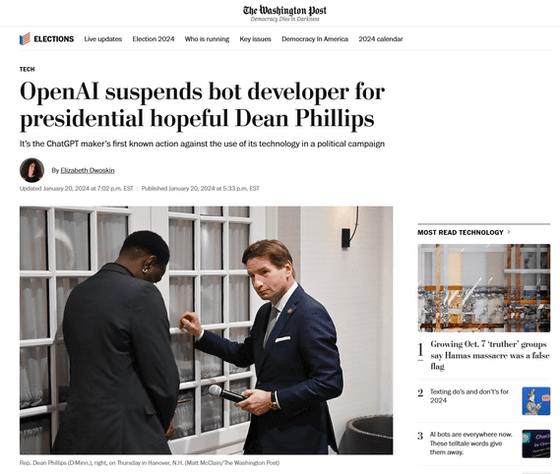

OpenAIが大統領選候補者のなりすましチャットボットを削除

民主党の2024年アメリカ大統領選候補者であるディーン・フィリップス下院議員を模倣したチャットボット「Dean.Bot」が、OpenAIによって削除され、チャットボットを開発したスタートアップ・Delphi AIのアカウントも凍結されました。OpenAIがAIの悪用を禁じるガイドラインに基づいて開発者のアカウントを凍結するのは初の事例だとのこと。

OpenAI bans developer of Dean Phillips bot - The Washington Post

https://www.washingtonpost.com/technology/2024/01/20/openai-dean-phillips-ban-chatgpt/

OpenAI suspends bot developer for Congressman Dean Phillips- The Washington Post | Reuters

https://www.reuters.com/technology/openai-suspends-bot-developer-congressman-dean-phillips-washington-post-2024-01-21/

OpenAI suspends startup that used GPT-4 model to impersonate presidential candidate Dean Phillips - SiliconANGLE

https://siliconangle.com/2024/01/21/openai-suspends-startup-used-gpt-4-model-impersonate-democratic-presidential-candidate/

「Dean.Bot」は、シリコンバレーの起業家マット・クリシトロ氏とジェド・サマーズ氏がインドのAI開発企業・Delphi AIに開発を依頼したもの。

2人は2024年1月23日に行われるニューハンプシャー州でのアメリカ大統領選予備選に向けて、フィリップス議員を支援する特別政治活動委員会(スーパーPAC)「We Deserve Better」を設立していました。

Dean.BotはGPT-4を用いて作られたチャットボットで、質問に対する応答はすべてフィリップス議員によるものではなくチャットボットによる生成であると明示されていました。

しかし、OpenAIは自社製品を、候補者のなりすましチャットボットを含む、「政治活動やロビー活動を目的としたアプリケーションの構築に用いることは認めていない」としてDean.Botを削除。Delphi AIのアカウントも凍結しました。

OpenAIは、2024年という年はアメリカの大統領選をはじめとして、イギリスやインド、パキスタン、南アフリカでも大規模な民主選挙が行われる公算が高いため、「民主主義のプロセスを損なう可能性がある方法で当社のテクノロジーが使用されないようにしたいと考えている」として、ディープフェイクや候補者へのなりすましボットなどの不正行為を防いでいくことを表明していました。

まさにOpenAIが懸念していたとおりの「AIの使用事例」となったわけです。

OpenAIが2024年の選挙ラッシュでAIが悪用されることを防ぐための施策を発表 - GIGAZINE

なお、フィリップス議員の支持者としてはヘッジファンドマネージャーのビル・アックマン氏などがいます。アックマン氏はフィリップス議員のPACに100万ドル(約1億4800万円)の資金を提供し、「過去に選挙に立候補した人への支援額としては最大です」と述べています。

My best and favorite investments come from a deep understanding of the importance of asymmetry, that is, by understanding the potential risk and reward, and making sure that the reward overwhelming compensates for the risk. I have made some great asymmetric investments at…

— Bill Ackman (@BillAckman) January 14, 2024

・関連記事

AI生成顔写真で人間になりすましたAIライターの記事を老舗スポーツメディアが掲載 - GIGAZINE

AIが書いた本がAmazonで他人名義で販売されているという報告、名前が使われた著者は「これなら自分の本が海賊版で出回った方がマシ」と訴え - GIGAZINE

「オレオレ詐欺」にAI製クローン音声を用いる事例が急増、被害額は年間15億円近くに - GIGAZINE

反ウクライナの主張を繰り返すSNSアカウントは偽物でプロフィール画像もAI製、さらにそのフォロワーもニセのAI製だったことが明らかに - GIGAZINE

AIが生成した画像をプロフィール写真にするフェイクアカウントが登場、Facebookが削除を報告 - GIGAZINE

・関連コンテンツ

in ネットサービス, Posted by logc_nt

You can read the machine translated English article OpenAI removes chatbot impersonating pre….