機械学習に最適とされる「NVIDIA H100」の代替になり得る「NVIDIA L40S」の性能とは?

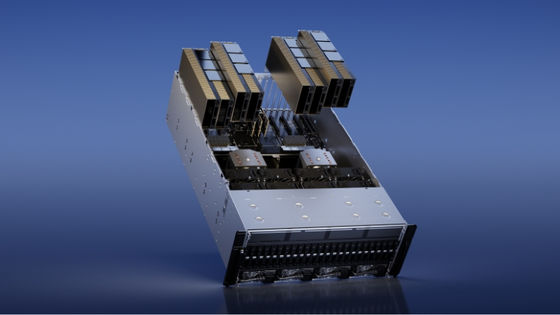

1台当たり数百万円以上で販売されているNVIDIA H100は機械学習に最適ということで人気があり、Facebookのマーク・ザッカーバーグ氏の慈善団体はNVIDIA H100を1000個以上積んだ高性能医学研究用コンピューティングシステムの構築をスタートしています。ブロガーのパトリック・ケネディ氏は、「NVIDIA L40S」という製品が「NVIDIA H100」の代替となり得るとして、その性能について解説しています。

NVIDIA L40S is the NVIDIA H100 AI Alternative with a Big Benefit

https://www.servethehome.com/nvidia-l40s-is-the-nvidia-h100-ai-alternative-with-a-big-benefit-supermicro/

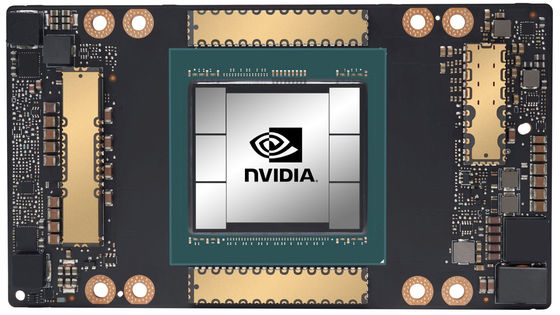

NVIDIA H100はハイエンドのGPUであり、需要も価格も非常に高くなっています。機械学習の需要を受けて、NVIDIAは「L40S」を販売。これはグラフィックス指向の「L40」の亜種とも言える存在で、H100の半分ほどの値段で手に入れることができます。

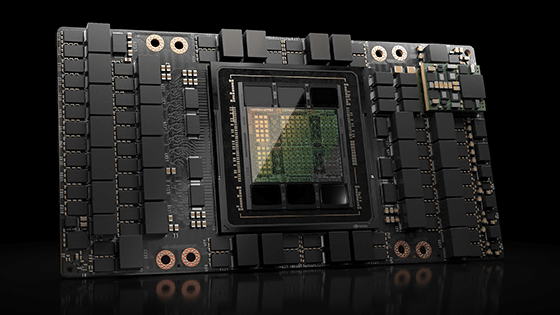

ケネディ氏によると、基礎的なモデル、例えばChatGPTのようなものをトレーニングしたいのであれば、NVIDIA H100 80GB SXM5が依然として最適なGPUだそうです。ただ、一旦基礎モデルが訓練されれば、ドメイン固有のデータや推論に基づいてモデルをカスタマイズするのは低コスト製品でも可能という仕組み。

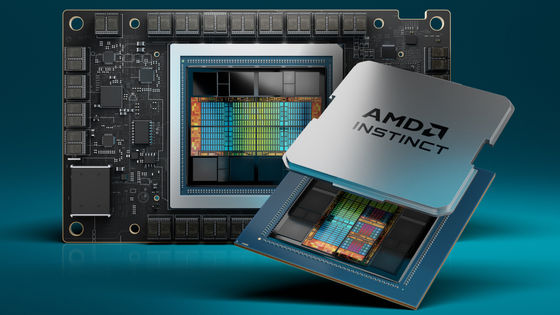

ハイエンドの推論に使われるGPUは、NVIDIA H100、NVIDIA A100、そして新しいNVIDIA L40Sの3つが現状の主流。L40Sは他の2つとはまったく異なるもので、もともとビジュアライゼーション向けGPUであるL40をベースに、AI向けの調整を施したものです。

ケネディ氏によると、L40SはAIのトレーニングと推論用に大幅に改善されたGPUですが、メモリ容量、帯域幅などが必要な場合には向かないとのこと。スペック上はA100よりもメモリが大幅に少ないように見えますが、NVIDIA Transformer EngineとFP8をサポートしているため、データサイズを大幅に縮小するFP8を使用することで、少ないメモリで動作するとのこと。

大規模言語モデルの一つ、LLaMA 7Bで推論したときの結果が以下の通り。青がH100、黒がL40S。ケネディ氏は「H100の方が速いのになぜL40Sなのか?と言われると、特にFP8を使用した場合は48GBのメモリで十分であり、FP16を使用したSXM版であってもA100に勝るとも劣らないためと答えます。一方、一般的にH100 PCIeはL40Sの2.0~2.7倍の速度ですが、価格も2.6倍です。また、L40SはH100よりはるかに早く入手可能であるのも理由の一つです」と話しました。

・関連記事

NVIDIAが数日以内に3つの新しいH100ベースのAIチップを中国に投入する予定との報道、輸出規制回避に必死な姿が浮き彫りに - GIGAZINE

「RTX 4090」などの中国への輸出規制でNVIDIAやIntelなどに大打撃 - GIGAZINE

「2025年までに国内のコンピューターの演算能力を合計300エクサフロップスにまで向上させる」計画を中国が発表 - GIGAZINE

「NVIDIA H100」を1000個以上積んだ高性能医学研究用コンピューティング・システムの構築をマーク・ザッカーバーグ夫妻が発表 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1p_kr

You can read the machine translated English article What is the performance of 'NVIDIA L40S'….