生成AIや大規模言語モデルの開発で渇望されるハイエンドGPU「NVIDIA H100」が不足する理由とは?

半導体メーカー・NVIDIAのTensorコアGPUであるNVIDIA H100は、TSMCの4Nプロセスノードを使用して製造された、記事作成時点では最新かつ高パフォーマンスのGPUです。生成AIや大規模言語モデル(LLM)といった昨今人気を集める推論AIワークロードに特化したNVIDIA H100は、需要過多により販売価格が高騰していることが指摘されており、NVIDIAもこれを認めています。このGPUの供給不足がなぜ起こるのかについてGPU Utilsがまとめています。

Nvidia H100 GPUs: Supply and Demand · GPU Utils ⚡

https://gpus.llm-utils.org/nvidia-h100-gpus-supply-and-demand/

ChatGPTなどを開発するAI企業・Open AIのサム・アルトマンCEOは、2023年5月に開催された公聴会の中で「GPUが非常に不足しているため、当社の製品を使用する人が少ないほど良いです」「GPUが不足しているため、当社の製品の使用量が減ってくれると嬉しいです」と語り、GPUの供給不足が同社に与える影響を明かしました。Open AIなどのAI企業が求めているのはNVIDIA H100のようなハイエンドGPUです。

NVIDIA H100を必要としているのは、LLMをトレーニングするOpenAIのようなスタートアップや、Microsoft AzureやAWSのようなクラウドサービスプロバイダーです。既存のAIモデルをテストするために使用されるケースもあれば、ほとんど無名のスタートアップが新しいAIモデルをゼロから構築するためにNVIDIA H100のようなハイエンドGPUを買いあさっているケースもあるとのこと。

ハイエンドGPUを求める企業のほとんどがNVIDIA H100を求めている理由は単純で、「LLMの推論とトレーニングの両方において既存の製品の中で最高のパフォーマンスを発揮するから」です。NVIDIA H100はコストパフォーマンスも高く、AIモデルのトレーニングにかかる時間を短縮することにもつながります。

あるディープラーニング研究者は、「NVIDIA H100は効率が最大3倍高いため、利用が推奨されています。そして、コストも既存のGPUと比べてわずか1.5~2倍ほどであるため、コストパフォーマンスが高いと言えます。システム全体のコストとGPUを合わせても、NVIDIA H100は1ドル(約140円)あたりのパフォーマンスをはるかに高くすることができます。さらに、システムパフォーマンスに注目すれば、恐らく1ドルあたりのパフォーマンスは4~5倍にもなります」と、NVIDIA H100の有用性について語っています。

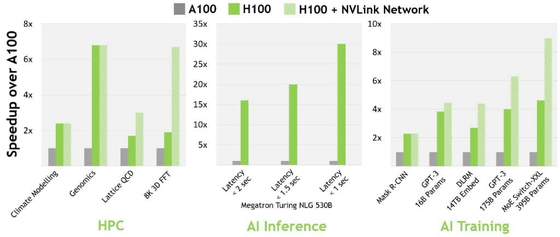

NVIDIA H100(緑色)とひとつ前の世代のハイエンドGPUであるNVIDIA A100(灰色)、そしてNVIDIA H100とNVLinkネットワークの組み合わせ(薄緑色)のHPC・AI推論(AI Inference)・AIトレーニング(AI Training)におけるパフォーマンスを比較したのが以下のグラフ。NVIDIA H100はNVIDIA A100と比べると、16ビット推論では約3.5倍、16ビットトレーニングでは約2.3倍のパフォーマンスを発揮します。

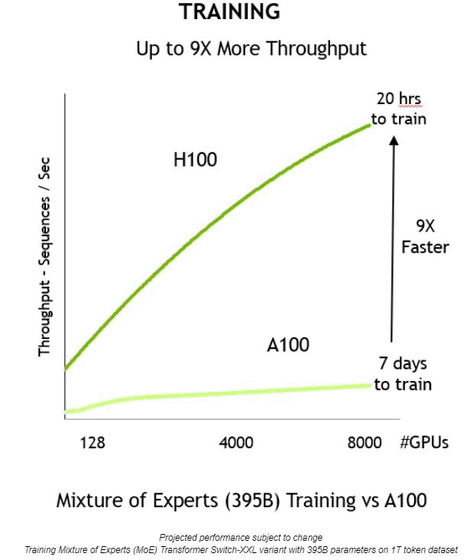

また、NVIDIA H100(緑色)はNVIDIA A100(薄緑色)と比べて9倍のスループットを実現。NVIDIA A100だとトレーニングに7日間かかるものでも、NVIDIA H100ならわずか20時間で完了可能です。

そんなNVIDIA H100の価格帯は製品によりますが、例えばNVIDIA H100を8つ搭載したNVIDIA DGX H100の場合、販売価格は46万ドル(約6600万円)。このうち10万ドル(約1400万円)はサポート費用で、スタートアップは約5万ドル(約700万円)の割引を受けることが可能です。

Open AIのLLMであるGPT-4の場合、約1万~2万5000台のNVIDIA A100でトレーニングされたと考えられています。そして、Metaは約2万1000台、テスラは約7000台、Stability AIは約5000台のNVIDIA A100を保有しているとされています。また、InflectionはGPT-3.5と同等のAIモデルをトレーニングするのに3500台のNVIDIA H100を使用したことが明らかになっています。

そして、MicrosoftのAzureの場合、約1万~4万台のNVIDIA H100を使用しており、Oracleも同等のNVIDIA H100を保有していると考えられています。なお、Azureの場合、保有するNVIDIA H100のほとんどがOpen AIに割り当てられている模様。

それでもOpenAIは5万台、Metaは2万5000台、AzureやGoogle Cloud、AWSといった大規模なクラウドサービスはそれぞれ約3万台ほどのNVIDIA H100を必要としていると考えられています。1台あたりのNVIDIA H100の価格を約3万5000ドル(約500万円)と推定すると、企業側がNVIDIA H100を導入しようとすればとんでもない設備投資が必要となることがよくわかるはずです。

LLM製品の中で最も一般に普及しているChatGPTの場合、どのようにGPUの需要が形成されるのかをGPU Utilsは以下のように説明しています。

1:ユーザーがChatGPTを多く利用しており、Open AIは年間500億ドル(約7兆1400億円)近い経常収益を上げています。

2:ChatGPTはGPT-4およびGPT-3.5のAPIで実行されます。

3:GPT-4およびGPT-3.5を実行するにはGPUが必要です。また、OpenAIはChatGPTとAPI向けに多くの機能をリリースしたいと考えていますが、十分なGPUにアクセスできない状態が続いているため、これをリリースすることができていません。

4:Open AIの場合、MicrosoftのAzureを通じてNVIDIA製のGPUを利用しています。具体的には、NVIDIA H100を求めています。

5:NVIDIA H100を搭載したNVIDIA DGX H100などを製造するために、NVIDIAはTSMCに製造を委託します。TSMCはCoWoSパッケージング技術を使用して、主にSK HynixのHBM3を使用しています。

Open AIだけでなく多くのAI企業が同じようにLLM製品の開発に取り組んでいるため、世界的にハイエンドGPUの需要が拡大し、供給不足が発生してしまうというわけ。なお、GPU UtilsによるとNVIDIA H100の供給不足は少なくとも2023年末まで続き、2024年の途中まで続く可能性があると指摘しています。

・関連記事

NVIDIAが「仮想通貨は社会にとって何の役にも立たない」と批判し「チャットAIの開発は仮想通貨のマイニングよりも価値がある」と表明 - GIGAZINE

AMDはCPUとGPUの価格をつり上げるために供給を制限しているとリサ・スーCEOが明かす - GIGAZINE

大手グラボメーカーのEVGAがNVIDIAの新型GPU取扱終了を宣言 - GIGAZINE

NVIDIAのGPU不足が解消され余剰在庫が発生 - GIGAZINE

NVIDIAが「仮想通貨マイナーに販売したGPUの数を隠蔽した」として7億円超の罰金を支払い - GIGAZINE

・関連コンテンツ