ChatGPTなどの対話型AIは「正解を探す検索エンジン」ではなく「単語の計算機」と考えるべきだという指摘

近年はOpenAIが開発した「ChatGPT」やGoogleの「Bard」など、高性能な対話型AIが登場して注目を集めています。これらの言語モデルを用いたAIについて、「質問したら何でも答えてくれる検索エンジンのようなもの」と考えている人も多いかもしれませんが、ソフトウェア開発者でブロガーのSimon Willison氏が、「言語モデルを用いた対話型AIは検索エンジンではなく『単語の計算機』と考えた方がいい」と述べています。

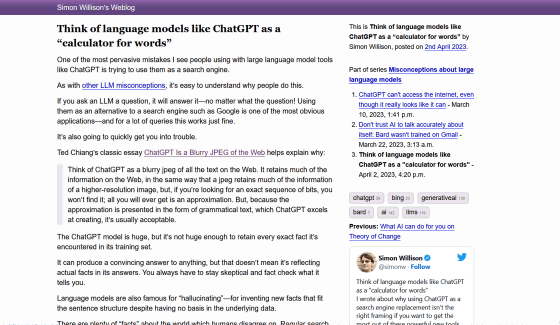

Think of language models like ChatGPT as a “calculator for words”

https://simonwillison.net/2023/Apr/2/calculator-for-words/

多くの人々はChatGPTなどの対話型AIにさまざまな質問をして、その答えがどれほど正確なのか、あるいはデタラメなものなのかを見て楽しんでいます。対話型AIは非常に正確に見える返答をすることが多い上に、Microsoftが検索エンジンのBingにAIを搭載していることから、人々が対話型AIを「検索エンジンのようなもの」と考えるのも自然なことです。

しかし、対話型AIは確かにユーザーの問いかけに対してもっともらしい説明を返すものの、その内容が必ずしも正確であるとは言えません。この現象についてSF作家のテッド・チャン氏は、The New Yorkerに発表したエッセイで「ChatGPTはウェブのぼやけたJPEG画像」とたとえています。

チャン氏は、「JPEGが高解像度の画像情報の多くを保持するのと同じように、言語モデルはウェブ上の情報の多くを保持します。しかし、正確なビット配列を探しているのであれば、それは見つかりません。得られるのは近似値だけです。しかし、その近似値はChatGPTが得意とする文法的に正しい文章で表現されているため、通常は許容されます」と述べています。

Willison氏は、「ChatGPTのモデルは巨大ですが、トレーニングセットで遭遇したすべての正確な事実を保持するほど巨大ではありません。何に対しても納得のいく答えを出すことができますが、だからといって答えに事実が反映されているかというと、そういうわけではないのです」と述べ、ユーザーはChatGPTが出した答えに懐疑的な態度を取り、事実を確認する必要があると指摘しました。

ChatGPTなどの対話型AIがそれらしく見えるのに事実ではない回答を生成することを、「Hallucination(幻覚)」と呼びます。もちろん、人間が検索エンジンを使って何かを調べても、事実ではない記述に行き当たることはあります。

しかし、人間は複数の情報源を突き合わせて比較検討し、何が事実なのかを検討することが可能です。対話型AIが生成した1つの回答を見るだけでは、情報を比較検討して正しい事実にたどり着けないことがあるため、ChatGPTなどの対話型AIを検索エンジンのように使用することは危険です。

Willison氏は、「検索エンジンとして使えないのであれば、言語モデルを用いた対話型AIは一体何に適しているのか?」という疑問に対し、「私は言語モデルを『単語の計算機』として考えるのが好きです」と述べています。

言語モデルはその名の通り「言語」を扱うためのツールであり、本当に優れているのは質問に対する正確な回答ではなく、言語操作だとのこと。言語モデルを用いた対話型AIに適している活用方法として、Willison氏は以下のような事例を列挙しています。

・エッセイを与え、その内容を要約させる。

・特定の文章を与え、その文章に含まれている情報について質問する。

・記事において示された事実を箇条書きにするよう求める。

・文章をよりパンチの効いた、あるいはプロフェッショナルな言い回しに書き直させる。

・「○○を示唆する言葉を教えて」と質問し、優れた類義語辞典として利用する。

・「この文章を17世紀の海賊風に書き直して」「この文章をラップバトルにして」など、文章を扱う楽しくて創造的な遊びに使う。

なお、いくつかの対話型AIは質問に対して検索を実行し、その検索結果を回答に含める機能も搭載しています。これらの検索ツールは拡張言語モデルとして捉えることが可能であり、質問に対してより正確な回答をするのに役立ちます。

しかし、たとえ検索ツールを含めた対話型AIであっても幻覚のリスクが存在しており、検索結果から派生しているはずの文章に、言語モデルが生成した誤った文章が追加されてしまうケースがあるとのこと。

また、「言語モデルは単語の計算機のようなものである」というたとえには、「計算機はいつでも同じ答えを返すが、言語モデルは同じプロンプトを与えられても回答が微妙に異なる」という欠陥があります。

Willison氏は、対話型AIにまつわる課題の多くは、対話型AIが実際よりも優秀に見えてしまう点にあると指摘。「言語モデルの価値を最大限に引き出し、不注意なユーザーに対して仕掛けられた多くのワナを回避するためには、言語モデルとの付き合いに時間をかけ、言語モデルがどのように機能し、何が可能でありどこで間違えやすいのかについて、正確なメンタルモデルを構築する必要があります。この『単語のための計算機』というフレーミングが、その一助になれば幸いです」と述べました。

・関連記事

検索エンジンBingに搭載されたAIが「あなたが先に私を傷つけない限り、私はあなたを傷つけません」と発言 - GIGAZINE

ChatGPTは高性能な対話ができるのになぜデタラメな回答をすることがあるのか? - GIGAZINE

ChatGPTは何をしていてなぜ機能するのか?を理論物理学者が解説 - GIGAZINE

画像や文章の生成などを行う「ジェネレーティブAI」はなぜ急に発展したのか? - GIGAZINE

「ChatGPT」などの自動生成AIは世界のGDPを7%増加させると同時に3億人の雇用に影響を与えるという調査報告、日本は世界で3番目に大きな影響を受けるとの指摘も - GIGAZINE

対話型AIに気候変動を止めるために自分を犠牲にするよう言われた男性が自殺、生前最後にAIと交わした生々しい会話も報じられる - GIGAZINE

ゲーム開発者が「一晩でAIに仕事のやりがいを奪われてしまった」と悲痛な叫びを漏らす - GIGAZINE

「AIは人類を労働から解放する」が大きな破壊も伴うとシリコンバレーの重鎮が予言 - GIGAZINE

・関連コンテンツ