単体のGPUでもGPT-3などの大規模言語モデルを処理できる「FlexGen」が登場

GPT-3などの大規模言語モデルを処理するには高い計算量とメモリが必要なため、通常は複数のハイエンドなAIアクセラレーターが求められます。この処理を、メモリ16GBのNVIDIA Tesla T4やメモリ24GBのNVIDIA GeForce RTX 3090など、メモリ容量が限られたGPU単体でも実行するための生成エンジン「FlexGen」が公開されました。

GitHub - Ying1123/FlexGen: Running large language models like OPT-175B/GPT-3 on a single GPU. Up to 100x faster than other offloading systems.

https://github.com/Ying1123/FlexGen#readme

FlexGenは大規模言語モデルの推論リソース要件を単一のGPUにまで引き下げ、さまざまなハードウェアに柔軟に対応できるようにすることを目的に作成されたエンジン。言語モデルのOPT-175Bを実行する場合は他のオフロードベースのシステムと比べて最大100倍高速になるなどの特徴を備えています。

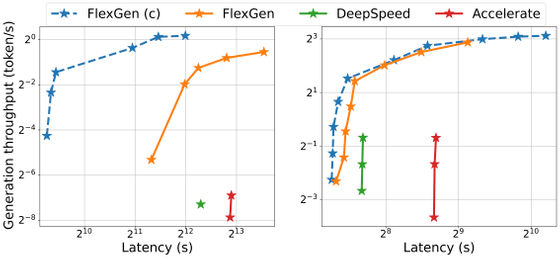

ベンチマーク結果は以下の通り。数値は生成スループットで、1秒当たりのトークン数を示しています。テストには208GBのDRAMと1.5TBのSSDを備えたGCP上のT4(16 GB)インスタンスが使用されています。

| System | OPT-6.7B | OPT-30B | OPT-175B |

|---|---|---|---|

| Huggingface Accelerate | 25.12 | 0.62 | 0.01 |

| DeepSpeed ZeRO-Inference | 9.28 | 0.60 | 0.01 |

| Petals | - | - | 0.05 |

| FlexGen | 25.26 | 7.32 | 0.69 |

| FlexGen(圧縮あり) | 29.12 | 8.38 | 1.12 |

下図は、OPT-175B(左)とOPT-30B(右)において、3つのオフロードベースのシステムのレイテンシーとスループットのトレードオフを示したものです。青色がFlexGen(圧縮あり)、オレンジ色がFlexGen、緑色がDeepSpeed、赤色がAccelerateを示しています。FlexGenはOPT-175Bにおいて最大スループットが他2つの100倍となり、新たなパレート最適解を達成しました。その他のシステムでは、メモリ不足によりこれ以上スループットを向上させることができませんでした。

FlexGenには今後、Apple M1/M2のサポート、Google Colaboratoryへの対応、チャットボットアプリケーションのレイテンシーの最適化などが盛り込まれる予定です。

・関連記事

文章を書いたのが人間なのかAIなのかを見分けるツール「GPTZero」の精度はどれほどなのか? - GIGAZINE

「GPT-3」などの最新言語モデルが自然に他者の心を推察する能力である「心の理論」を獲得していたという研究論文 - GIGAZINE

AIで入力した文章から人物や固有名詞間のつながりをナレッジグラフ化してくれる「GraphGPT」が登場 - GIGAZINE

MicrosoftがChatGPTのアップグレード版AIを統合した新しい検索エンジンBingとブラウザEdgeを発表 - GIGAZINE

・関連コンテンツ