スマホカメラはどれほど「濃い肌の色」を正確に撮影できるのかApple・Samsung・Googleのハイエンドモデルで比較した結果とは?

近年のスマートフォンカメラは非常に優れた性能を持っていますが、時には肌の色が実際とはやや違った色味になっていたり、濃い肌の色をした人の顔が暗い場所ではっきり写りにくかったりするケースがあります。そこでアメリカの日刊紙であるワシントン・ポストが、AppleのiPhone 14 Pro Max・SamsungのGalaxy S22 Ultra・GoogleのPixel 7 Proの3機種を用いて、「濃い肌の色」をどれほど正確に撮影できるのか比較しています。

Putting Google Pixel's Real Tone to the test against other phone cameras - The Washington Post

https://www.washingtonpost.com/technology/2022/12/29/real-tone-google-pixel/

スマートフォンのカメラは、ポケットの中に収まるサイズでありながら非常に高い忠実度の写真を撮影でき、ハイエンド機種であれば夜間やズームの撮影でもはっきりと人間の顔を捉えることができます。しかし、特に肌の色が濃い傾向がある有色人種の人々は、依然としてスマートフォンの写真が完全に自分たちの肌の色を再現しているとは感じていないとのこと。

現実の肌の色とスマートフォンカメラで撮影した写真の肌の色に違いが出てしまう理由について、ワシントン・ポストは「スマートフォンが黒色や茶色の顔を処理する方法」に問題があると指摘しています。

フィルムカメラの時代では、まともな写真を撮るには適切なフィルムをセットし、レンズの絞りやシャッタースピードを調整する必要がありました。しかし、スマートフォンカメラは非常に優れたコンピューティング能力を利用してこれらの問題を解決しており、画像を微調整することできれいな写真を撮影することが可能です。また、同時に複数の露出で撮影した画像をキャプチャーし、良い部分を重ね合わせるHDR機能も多くの機種に搭載されています。

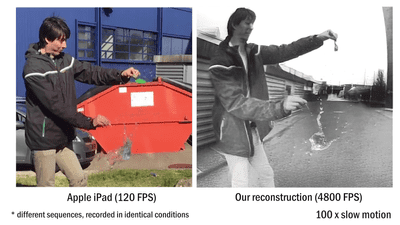

しかし、スマートフォンカメラで撮影した写真は現実世界よりも明るく、よりカラフルに見えがちなことも指摘されています。この問題は、被写体を定義するカメラセンサーやアルゴリズムなどが、比較的薄い肌色の人間でトレーニングされているためだとのこと。スマートフォンメーカーもカメラが正確に肌の色を再現できていない問題を認識しており、Googleは2021年に「肌の色を改善する」と宣言してアルゴリズムの改善に着手しています。

Googleがスマホのカメラで撮影した「肌の色」を改善する仕組みを新たに発表 - GIGAZINE

Googleは取り組みの一環として、Pixelのカメラを調整するデータセットに1万枚以上の画像を追加し、暗い場所で撮影した濃い肌の色をより正確に再現できるよう改善を施したとのこと。しかし、依然としてこの取り組みは進行中であることも認めています。

そこでワシントン・ポストは、AppleのiPhone 14 Pro Max、SamsungのGalaxy S22 Ultra、GoogleのPixel 7 Pro、という大手スマートフォンメーカーのハイエンドモデルを使用し、どれほど肌の色を正確に撮影できるのかを比較するテストを行いました。

以下は、カリフォルニア州・ロサンゼルスのベイエリアで3Dプリントの会社に勤めるAnthony Sturgis氏(左)とガールフレンドのMichelle Nell氏(右)を夜間撮影した写真で、左がクリスマスツリーの暖色系の光を正面から浴びたもの、右が光るクリスマスツリーに背後から照らされたものです。上から順にiPhone 14 Pro Max・Galaxy S22 Ultra・Pixel 7 Proで撮影された写真となっており、いずれも同じ状況で撮影しているのにもかかわらず、機種ごとに肌の色味が違うことがわかります。

Sturgis氏とNell氏は、6枚の写真の中で「正面から光を浴びているPixel 7 Proの写真」が最も好きだと回答しましたが、背後にクリスマスツリーがある写真ではiPhone 14 Pro Maxの写真が最も良かったと答えました。

ワシントン・ポストはこの結果について、Galaxy S22 Ultraの写真はクリスマスツリーの黄色っぽい光を受けて、2人の自然な肌の色が分かりにくくなっていると指摘。一方、Pixel 7 ProとiPhone 14 Pro Maxはかなり肌の色が正確に再現されていたそうで、記者の目で見たものと最も近かったのはPixel 7 Proの写真であり、iPhone 14 Pro Maxは全体的に明るくしつつも肌の色の温かみを保持していたと述べています。

続いて、曇りの日にサンフランシスコまで買い物に来ていたDenise Santoyo氏(左)とLance Hopson氏(右)を撮影した写真が以下。上から順にiPhone 14 Pro Max・Galaxy S22 Ultra・Pixel 7 Proで撮影された写真であり、まだ明るさのある時間帯にもかかわらず、2人の肌の色はスマートフォンごとにかなり異なって見えます。

3枚の写真を見比べたHopson氏は、「SamsungとGoogle Pixelの写真は、わずかですが露出オーバーのようで、その結果として過度に明るいように見えます」「iPhoneの写真は、私たちを最も正確に表現しているようです。他の2つの写真と比べると、肌の色は私たちが認識しているものに近いです。色も鮮明で温かみがあり、とても生き生きとしているように見えます」とコメントしました。

ワシントン・ポストは、Galaxy S22 Ultraの写真は他と比較してやや紫がかって見え、2人の顔の細部が滑らかになっていると指摘。iPhone 14 Pro MaxとPixel 7 Proのどちらを好むかは人によるものの、Santoyo氏の肌の色は間違いなくiPhone 14 Pro Maxの方が伝わると述べています。

以下は、家族でサンフランシスコを訪れたErika Young氏(左)と母親のJwana Luckey氏(右)が、夜間にライトアップされた建物やクリスマスツリーの前で撮影した写真です。上から順にiPhone 14 Pro Max・Galaxy S22 Ultra・Pixel 7 Proで撮影されたもので、顔の部分をクローズアップすると細部の再現度にも違いがあるのがわかります。

Young氏は、iPhone 14 Pro Maxで撮影した写真の鮮明さも好きなものの、より自然な色味だったGalaxy S22 Ultraの写真が最も好きだと回答し、「Samsungのカメラを使うと、肌の色がより再現されたと間違いなく言えます」とコメントしました。一方、Pixel 7 Proの写真は色があせたように感じられたとのことで、Luckey氏は「灰色っぽい」ように見えると述べました。

ワシントン・ポストは、iPhone 14 Pro Maxは顔の輪郭をかなりはっきり強調しているものの、対照的に輪郭がややぼんやりしたGalaxy S22 Ultraの方が好まれる結果となったと解説しています。一方でPixel 7 Proはやや苦労しており、特にLuckey氏の顔がはっきり見えにくい写真になってしまったと指摘しました。

3パターンの人物とシチュエーションを比較した今回のテストでは、最も好まれる写真を撮影したスマートフォンカメラはそれぞれ異なる結果となりました。ワシントン・ポストはこの結果について、「写真の好みがバラバラなのは、当然といえば当然です。カメラに写る自分の姿は、自分自身との関係や歴史に根ざした深く個人的なものです。GoogleやApple、Samsungが考える『あなたをあなたらしく見せるベストな方法』とは一致しないかもしれません」とまとめました。

・関連記事

Googleがスマホのカメラで撮影した「肌の色」を改善する仕組みを新たに発表 - GIGAZINE

ガラケーから最新iPhoneまで「ケータイのカメラ」の性能向上が一目で分かるシミュレーター - GIGAZINE

「スマホで撮影した写真のブラインドテスト」でiPhone 13 ProがPixel 5aに敗北 - GIGAZINE

HTMLだけでスマートフォンのカメラにアクセスするクールな方法 - GIGAZINE

顔認識技術による政府の監視はマイノリティを迫害し表現の自由を阻害すると電子フロンティア財団が警告 - GIGAZINE

アメリカの政府機関がコロナ詐欺対策の顔認証システムを廃止、プライバシーや人種差別の懸念から - GIGAZINE

リモート司法試験の顔認証で「黒人の顔が認識されない」という不具合が発生 - GIGAZINE

Facebookが黒人男性の動画を「霊長類」とタグ付けし謝罪 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1h_ik

You can read the machine translated English article How accurately can a smartphone camera s….