プロンプトを2回繰り返すだけでAIの正答率が上がるとGoogle Researchが報告

大規模言語モデル(LLM)は、同じ内容のプロンプトでも「書き方」や「情報の並べ方」によって答えが変わることがあります。Google Researchの研究者らは、プロンプトをそのまま2回並べるだけの単純な手法により、LLMが多くの問題で正答しやすくなると報告しました。

[2512.14982] Prompt Repetition Improves Non-Reasoning LLMs

https://arxiv.org/abs/2512.14982

この手法は「Prompt Repetition(プロンプト反復)」と呼ばれ、入力を「<指示文>」から「<指示文><指示文>」に変換するだけです。つまり、指示や問題文をコピーしてそのまま2回連続で貼り付ければOK。「同じことを2回言えば通じやすい」という発想にも思えますが、研究チームの狙いは説得ではなく、LLMの読み取り方に由来する取りこぼしを減らすことです。

LLMの多くは文章を左から右へ順番に処理します。人間のように全体を見渡してから理解するわけではないため、先頭から読んでいく途中の時点では、後ろにある情報を確認することができません。そのため、「背景情報→質問」なのか「質問→背景情報」なのかといった並びが変わるだけで、必要な条件を読み落としたり参照すべき箇所を取り違えたりする余地が生まれます。

そこでプロンプトを2回繰り返すと、2回目を処理する時点で1回目の全文がすでに入力として存在していることになります。この状態だと、2回目の各部分が1回目の内容全体を参照しやすくなります。例えるなら、同じ説明書が2ページ連続で貼られていて、2ページ目を読むときには1ページ目が確実に「既読」になっている状況を人工的に作るイメージです。研究チームは、こうした構造によって指示や条件の取りこぼしが減り、結果として正答率が上がる可能性があると説明しています。

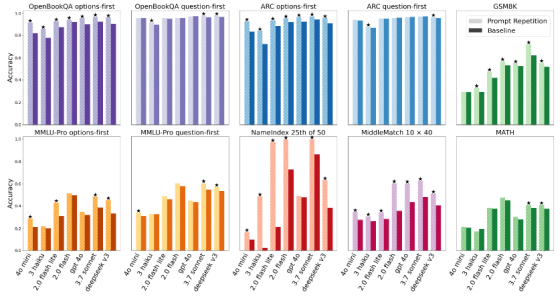

この効果を確かめるため、研究チームはGemini 2.0 Flash/Flash Lite、GPT-4o/GPT-4o-mini、Claude 3 Haiku/Claude 3.7 Sonnet、DeepSeek V3の計7モデルを、ARC(Challenge)やOpenBookQA、GSM8K、MMLU-Pro、MATHなどのベンチマークで評価しました。さらに、研究チームは長い入力から特定位置の要素を取り出す能力を見る独自タスク「NameIndex」と「MiddleMatch」も用意し、各社の公式APIを使って2025年2月から3月にテストを実施しました。

ここで研究チームが区別しているのが「LLMに推論を促すかどうか」です。LLMには答えを出す前に途中式のような検討手順を増やして「考える時間」を多めに使う推論モデルや推論モードがある一方で、追加の思考手順をあまり回さず入力を読んだら比較的そのまま答えを作る「即答モード」に近い設定もあります。研究チームによると今回の手法が大きな効果を示したのは、後者のような推論を促さない条件だったとのこと。

研究チームは、特定の条件の前後で成功・失敗の割合が変わったかどうかを調べる「マクネマー検定」を実施したところ、70件中47件でプロンプト反復を使った方が正解率が統計的に有意に高くなり、逆にプロンプト反復を使って正答率が低下したケースは1件も見られなかったと報告しています。特に選択式問題では問題文より先に選択肢を提示する並べ方「options-first」のように、1回目の読み取りだけでは文脈が揃いにくい配置の場合はプロンプト反復で改善が大きくなりやすい傾向が示されました。並べ方の相性で起きていたミスを2回目の読みで補正する形になっている可能性があります。下の図は各ベンチマークにおけるBaseline(プロンプトを1度だけ書く)とPrompt Repetition(プロンプト反復)の正答率を並べたもので、「options-first」で差が出やすい様子も読み取れます。

極端な改善例として研究チームが挙げているのが独自タスクの「NameIndex」です。「NameIndex」は50人分の名前リストを与えて「25番目の名前は何か」といった指定位置の要素を答えさせる課題で、Gemini 2.0 Flash Liteではプロンプトを1回だけ提示した場合の正答率が21.33%だった一方、プロンプトを2回繰り返すと97.33%まで上がったと報告されています。長い入力から「どこを見るべきか」を外してしまうタイプの失敗が、反復によって減ったことを示唆する結果です。

入力量が倍になると待ち時間やコストが増えるようにも思えますが、研究チームは「生成するトークン数は増えず、実測の待ち時間も多くの条件で増えない」と述べています。LLMの処理は大まかに、入力を読み込む「prefill」段階と、回答を1トークンずつ生成する「decoding」段階に分けられますが、「decoding」が待ち時間に影響しやすい一方で「prefill」は並列化しやすいと研究チームは説明しています。ただし、Anthropicのモデルでは入力が非常に長い場合に待ち時間が増える例もあったとしています。

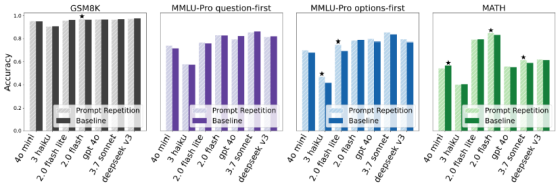

研究チームは「Think step by step(段階的に考えて)」のように推論を促す条件では、効果が見られないか、小さな改善にとどまったとも報告しています。推論をさせる設定では、回答生成の途中で問いを言い換えたり要点を繰り返したりする挙動が起きやすく、入力側の反復が冗長になって効きにくい場合があると研究チームは説明しています。推論を促した条件での結果をまとめたのが下の図で、推論させない条件ほど大きな伸びにならないケースが多いことが分かります。

研究チームはプロンプト反復の派生系も試しており、プロンプトを3回繰り返す「×3」や、「Let me repeat that:」のように繰り返しを明示する形でも検証したところ、タスクによっては「×3」でさらに良い結果になる場合があることが示されました。さらに、研究チームは単に入力を長くしただけでは正答率が改善しないことを確かめるために同じ長さになるように「.」で埋めるPaddingも試しましたが、成績は上がらなかったとのこと。研究チームは、長ければ良いのではなく「同じ内容をもう一度読ませる」こと自体が効いている可能性があるとまとめています。

・関連記事

「ChatGPT」に使われる言語モデル「GPT」からうまく答えを引き出すためのOpenAI公式ガイド - GIGAZINE

プロンプトインジェクションによってSlack AIから機密データを抜き取れる脆弱性が報告される - GIGAZINE

AIへの「ビジュアルプロンプトインジェクション」攻撃とは何か? - GIGAZINE

GoogleがGemini 2.0を誰でも使えるように公開、新たに低コスト版や高機能版、検索機能付属版も登場 - GIGAZINE

・関連コンテンツ

in AI, サイエンス, Posted by log1b_ok

You can read the machine translated English article Google Research reports that repeating a….