物議を醸しているAppleの写真スキャンで「偶然の一致」の実例が報告される

Appleが2021年8月に発表した、「iPhoneやiCloud内の写真やメッセージをスキャンして児童の性的搾取を検知する取り組み」には、検閲やプライバシー侵害のリスクが伴うとしてさまざまな団体が反対を表明しています。新たに、Appleがスキャンに使用するアルゴリズムで実際に大規模な画像データセットをスキャンした研究により、「無関係な画像で誤検知が発生する」ことが確かめられました。

ImageNet contains naturally occurring NeuralHash collisions

https://blog.roboflow.com/nerualhash-collision/

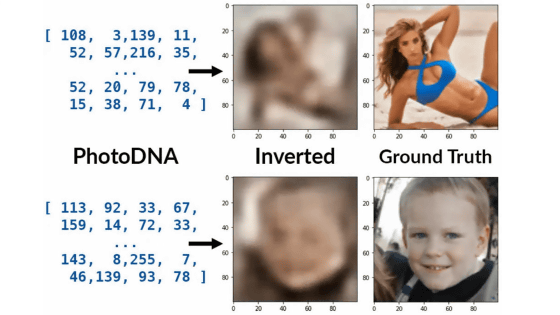

Appleが導入を進めている「児童の性的搾取に関連するデータ(CSAM)」をスキャンするシステムは、端末やクラウドに保管されているユーザーデータからハッシュ値を生成し、既知のCSAMのデータベースと照合して児童ポルノなどを検知する仕組みです。しかし、Appleがハッシュ値の照合に使用する「NeuralHash」というアルゴリズムには、「異なる画像から同じハッシュ値が生成される『ハッシュ衝突』を人為的に発生させることができる」という欠点があることが、セキュリティ研究者によって指摘されています。

世界中から猛反発を受けるAppleの「iPhone内の児童ポルノ検知システム」には大きな穴があることが判明 - GIGAZINE

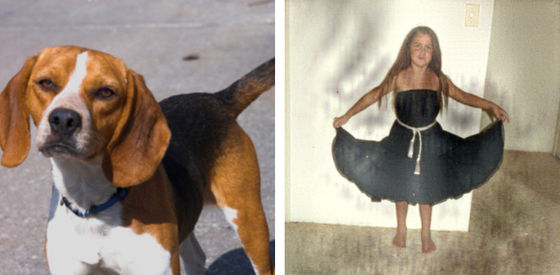

人為的なハッシュ衝突の実例が以下。この例では、左の犬の画像と同じハッシュ値になるように右の女の子の画像を加工して、意図的にハッシュ衝突を発生させています。

画像認識技術の開発企業・Roboflowの共同設立者であるブラッド・ドワイアー氏は、このハッシュ衝突が人為的ではなく自然に発生するかどうかを調べるため、NeuralHashで大規模な画像のデータセットである「ImageNet」をスキャンする実験を行いました。

その結果、全く同じ画像で正常にハッシュ衝突が発生する事例8272件と、解像度の違いなどがあってもハッシュ衝突が発生したケース、つまり画像に微妙な変更を加えても正常に照合できた事例595件が確認できました。しかし、編集しておらず見た目も似ていない無関係な画像でハッシュ衝突が起きてしまった事例も2件発生しました。

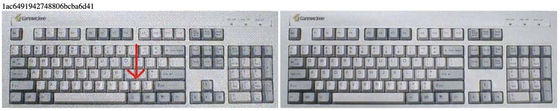

正常なハッシュ衝突の例が以下。解像度を大幅に下げても、NeuralHashは2枚の画像が同じものだということを認識することができました。

矢印やロゴの有無なども同様です。

画像を横に引き伸ばしても、同じ画像として認識しました。

しかし、無関係な画像でハッシュ衝突が起きる事例も見つかりました。以下のくぎ(左)とスキー板(右)の画像は、確かに一見似ていますが、人間の目には別の画像だと分かります。しかし、NeuralHashでは同じハッシュ値で認識されました。

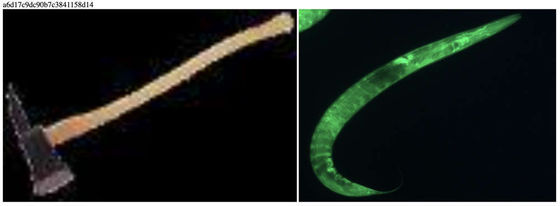

おの(左)と線虫(右)という色も形も違う画像でも、ハッシュ衝突が発生しました。

ドワイアー氏によると、上記の2件は2兆通りの画像ペアの中で見つかったものだったとのこと。なお、Appleは「ハッシュ衝突が起こる確率は1兆分の1未満」と説明しています。

この実験結果についてドワイアー氏は、「NeuralHashは私の予想よりうまく機能しており、私のImageNetの実験結果は、Appleが行ったテストとおそらく同様のものです。とはいえ、Appleは15億人以上のユーザーを抱えているため、いかに誤検知の確率が低くても問題が発生する可能性があります。従って、無実の人が通報されてしまうリスクをはっきりさせるには、さらなる研究が必要になるでしょう」と結論づけました。

また、CSAMを検知するAppleの取り組みについては「最も問題になるのは、CSAMのデータベースそのものだと思われます。当然ながらオリジナルの画像はチェックできないため、外国政府などが政敵や人権擁護者を抹殺するためにCSAMではないハッシュ値をデータベースに仕込んでいるかどうかの確認もできません。Appleは、データベースにファイルを追加する際には2つの国の同意を得ることでこの問題に対処する方針ですが、このプロセスは不透明なので、悪用される可能性は高いと思われます」とコメントし、誤検知の可能性が低くても依然として課題は残るとの見方を示しました。

・関連記事

世界中から猛反発を受けるAppleの「iPhone内の児童ポルノ検知システム」には大きな穴があることが判明 - GIGAZINE

巨大写真データセット「ImageNet」で攻撃的・差別的なカテゴリー分類タグ付けが判明し人物写真の半数以上を削除 - GIGAZINE

画像認識モデルの「盲点」を克服するための奇妙な画像ばかり集めたデータセット「ObjectNet」をMITとIBMの研究チームが公開 - GIGAZINE

10億枚以上のInstagramに投稿された写真を用いて学習した画像認識モデル「SEER」をFacebookが発表 - GIGAZINE

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も - GIGAZINE

・関連コンテンツ